近年来,人工智能领域尤其是大型语言模型(LLMs)的发展可谓突飞猛进,模型的上下文窗口容量也从最初的几千令牌扩展至百万级别,极大地推动了模型在长文本处理、代码理解与生成等复杂任务上的表现。然而,随着上下文窗口的极端扩展,如何评估模型在超长上下文条件下的真实能力成为当下亟需解决的问题。LongCodeBench作为一项面向百万上下文窗口的代码理解和修复基准测试,恰好为此提供了极具价值的评测标准和实践依据。 LongCodeBench的设计初衷是应对现代大型语言模型在代码领域中对长上下文的巨大需求。代码作为结构严谨且常涉及跨文件、跨模块背景知识的专业文本,天然适合用作长上下文能力的考察对象。传统的基准测试往往着眼于短文本段落或者单文件任务,难以真实反映出模型在百万级令牌处理上的优势或短板。

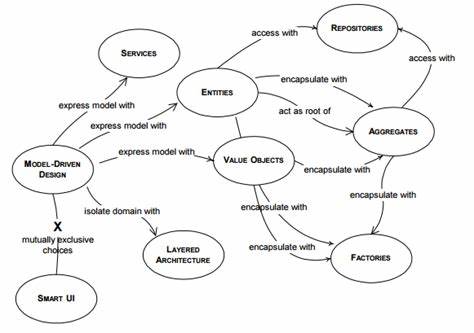

LongCodeBench则直接聚焦这一空白,利用真实的GitHub项目中的复杂代码库和典型的代码问题,构建了覆盖代码阅读理解与软件错误修复两大核心任务的评测体系。 LongCodeBench包含两个主要子任务:LongCodeQA和LongSWE-Bench。LongCodeQA任务重点考察模型对给定百万令牌上下文中代码逻辑的深度理解能力。通过从真实的开源项目中提取大量代码文件及其相关文档,模型需要基于巨大上下文做出准确的问答推理,展现其快速定位信息和综合分析复杂输入的能力。而LongSWE-Bench则模拟真实的软件开发环境中的代码错误修复场景,要求模型在极端长上下文中识别并修正隐含的bug,考验模型的代码诊断与生成精准性。 LongCodeBench不仅仅是一个数据集,更是一个针对长上下文极限挑战的试金石。

该基准测试精心分层了任务复杂度,从相对简单的代码阅读到极其复杂的跨模块错误修复,涵盖了多种不同规模和难度,确保能够公平且全面地评估市场上各种规模和架构的代码大型语言模型。值得一提的是,评测过程中涵盖了包括Qwen2.5 14B Instruct和谷歌的旗舰Gemini模型等多个知名模型,为行业提供了整体性能的宏观视角。 测试结果令人警醒,同时也彰显了挑战的严峻性。尽管现代大型语言模型在短文本处理上表现优异,但当上下文扩展到百万令牌时,所有模型的性能均出现明显下降。例如,Claude 3.5 Sonnet的准确率从29%骤降至仅3%,Qwen2.5则从70.2%下降至40%。这些数据清晰地表明,长上下文的管理、记忆保持、信息检索与整合依然是现阶段模型的显著弱点。

LongCodeBench不仅揭示了技术发展的瓶颈,还为未来提升模型长上下文能力指明了方向。 纵观LongCodeBench的研究背景,代码领域其实具备天然的长上下文需求,原因在于软件开发过程中常涉及数十万至百万行代码的整体环境,且错误修复往往跨越多个文件间的复杂依赖。传统单文件或者短上下文模型难以捕捉代码全局信息,因此从代码阅读理解到自动化修复,强大的长上下文建模能力成为核心竞争力。LongCodeBench恰好压制了这部分场景中的实际需求,使研究与开发更具针对性和现实意义。 LongCodeBench的推出,对行业内外都有重要意义。对于模型开发者而言,有了这样一个高质量且分层细致的基准,能够更精准地进行性能调优和架构优化。

长上下文能力的突破势必带来更智能、更高效的代码自动化辅助工具,极大提升软件开发及维护的效率和质量。对学术研究者而言,LongCodeBench提供了一个可重复、可拓展的实验平台,促进长文本与长代码理解技术的深化探索。 对普通开发者和产品用户来说,未来具备百万令牌上下文处理能力的代码大型语言模型,将极大改善其开发体验。无论是复杂项目的代码导航,还是自动化bug修复与重构建议,高效利用海量上下文信息将重塑软件工程工作流。LongCodeBench在一定程度上推动了这股技术革新的步伐,加速向智能助理和开发自动化工具转型。 随着硬件计算能力提升与优化技术的进步,百万上下文窗口的深度学习发展迎来新的机遇。

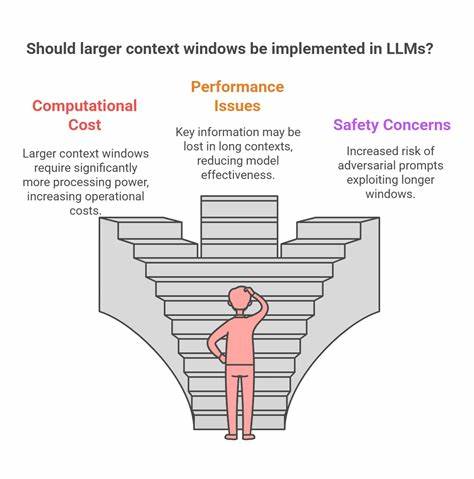

改进的内存机制、稀疏注意力模型、多阶段推理框架等技术不断涌现,为长上下文模型的稳定训练和推理提供技术支持。LongCodeBench的存在不仅促进了这类技术的落地验证,也帮助行业明确实际应用中的关键需求。 当然,百万级上下文下模型还面临诸多挑战,包括计算资源消耗巨大、长程依赖关系捕捉困难以及多任务协同处理等。面对这些瓶颈,LongCodeBench的实验数据为模型改进提供了宝贵的参考,激励业界在模型架构、优化策略和多模态融合等方向持续创新。 随着未来更多具备强大长上下文处理能力的模型问世,LongCodeBench也将不断迭代升级,涵盖更多样化的代码场景和任务类型,进一步扩大其在代码智能领域的权威地位。为推动代码人工智能的深度应用,相关研究和产业界需持续关注并参与这一基准的建设与完善。

总结来看,LongCodeBench作为全球领先的针对百万令牌上下文的代码大型语言模型评测体系,精准捕捉了长上下文时代面临的关键挑战与机遇。它的出现不仅提供了评判模型长文本能力的规范化工具,更是指导未来模型研发与应用创新的重要里程碑。未来,提升代码大型语言模型在长上下文任务中的表现,将极大促进智能软件开发工具的演进,推动软件行业迈向更加智能、高效的新时代。