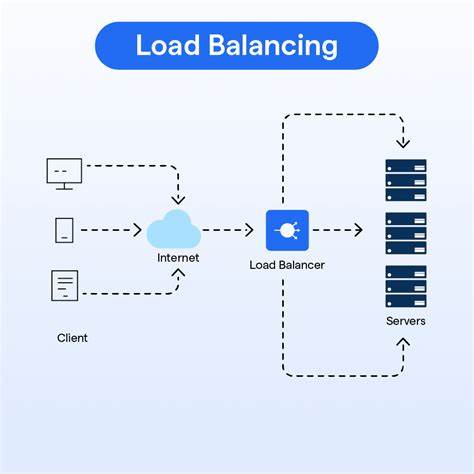

随着计算机硬件的飞速发展,尤其是多核处理器和异构计算架构的普及,负载均衡作为操作系统内核调度中的关键环节,正面临前所未有的挑战。传统的调度算法如完全公平调度器(CFS)最初设计时基于较为简单的硬件模型,适用于核心数有限且CPU同质的环境。然而,进入2020年代,面对超过48核,甚至更复杂的异构多核处理器,传统的调度策略显得力不从心,无法满足现代应用对于性能、延迟和能源效率的多重需求。近年来,随着机器学习技术的成熟,将其应用于负载均衡调度领域成为了一种崭新的解决方案。通过机器学习,调度器可以动态地感知系统状态,识别复杂的运行时模式,从而做出更加智能且优化的调度决策。Linux内核中引入的扩展调度类(sched_ext)为定制调度器提供了灵活的框架,该框架支持基于BPF的调度逻辑,使得实验和研发具备更高的效率和可扩展性。

在2025年开源峰会北美站上,Ching-Chun Huang展示了利用本地机器学习优化复杂系统进程调度的最新进展。Linux调度器的发展历程证明,固化单一算法难以兼顾各种不同场景的调度需求。从2007年引入CFS至今,历经BFS、MuQSS等替代方案的探索,再到2024年sched_ext的引入,调度器的演进反映了人们对多样化工作负载和多核体系结构的深入理解与应对。2007年Linus Torvalds曾断言服务器与桌面调度应统一策略,认为区分负载并无意义。但随着技术发展,这一观点逐渐过时。如今,桌面环境与服务器、游戏与网络处理等不同场景对调度策略的需求差异日益明显,单一调度算法的局限性迫使系统管理员通过进程绑定和系统划分等手段绕过内核调度的不足。

面对现代复杂系统设计的诸多挑战,例如非统一内存访问架构(NUMA)中任务远离内存造成性能下降,或者异构CPU带来的性能与功耗权衡,以及指令集差异导致的程序崩溃风险,传统算法难以自动适配。多样化的应用类型和混合负载进一步提升了调度策略的难度。以游戏为例,渲染任务要求高度低延迟性能,适合高性能核心,而流媒体流量则可托付给低功耗核心。若两者一视同仁,游戏体验将遭受严重影响。5G网络中,网络包处理既要求严格的低延迟,又需处理大量计算密集型任务。开发者也需面对繁重的编译与交互任务混合,糟糕的调度决定会导致频繁切换和界面卡顿。

针对这些复杂情形,sched_ext框架为调度器引入了基于机器学习的创新设计,标志着负载均衡迈入适应性更强的时代。Free5GC项目做为案例,展示了机器学习调度的具体应用。该项目专注于开源5G网络处理,尤其是数据面处理环节。该部分负载既有计算资源密集的特性,也存在强烈的延迟限制。传统调度器难以平衡这些因素,而Free5GC在sched_ext上运行的调度器“scx_packet”通过将系统CPU划分为网络延迟敏感和计算密集两部分,取得了初步成效。但由于对网络流量缺乏细粒度区分,仍存在优先级冲突和资源分配不均问题。

借助机器学习,研发人员扩展了调度器的表现力。机器学习模型能够综合考虑任务优先级、CPU需求、虚拟运行时间、近期CPU使用率、各CPU负载、NUMA距离、缓存共享及运行频率等多维度信息,同时吸纳具体应用场景的需求,实现智能迁移决策。调度器初期在数据采集模式下运行,通过观察迁移决策的性能反馈,构建并逐步训练用于负载均衡的机器学习模型。模型存放于BPF映射中,可以在内核中实时调用。用户空间不断收集反馈数据,持续更新模型,实现线上学习和自适应演化。值得一提的是,内核环境对浮点运算有严格限制,传统的神经网络通常依赖浮点计算。

为此团队采用定点数算法替代浮点运算,既满足内核禁止浮点指令的规定,也保证了神经网络推断的计算效率。在实际测试中,基于机器学习的调度器在Linux内核编译基准测试中表现尤为突出,编译时间比EEVDF调度器缩短了约10%,且任务迁移次数大幅降低77%,极大减少了系统调度开销和上下文切换,提高整体运行效率。调度问题本质上属于模式识别领域,神经网络的擅长能力使机器学习成为理想的解决手段。调度器通过机器学习实现多目标平衡,自适应应对新硬件架构和多样负载。不同于固定规则,机器学习调度能持续调整其策略,处理15项以上调度参数,确保迁移决策的科学合理。未来,机器学习调度领域前景广阔,值得进一步探索。

其应用不仅局限于进程调度,还可扩展至网络拥塞控制、高性能计算调度、虚拟化环境及云原生场景中。整合深度学习与强化学习技术,有望构建更智能的操作系统内核,提升效率,降低能耗,保障关键任务服务质量。总的来看,借助如sched_ext这样的可扩展调度框架及机器学习技术,现代负载均衡迈出了历史性步伐。面对多核异构和复杂多变的计算场景,机器学习驱动的调度器展现了卓越的适应性和优化潜力,预示着操作系统调度进入更加智能化、动态化的新时代。