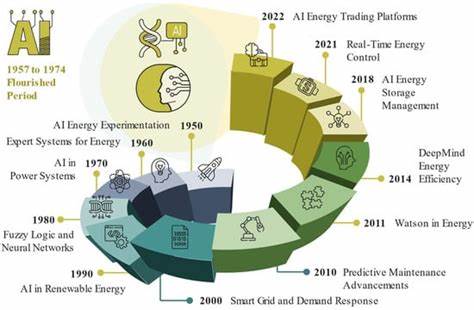

近年来,人工智能(AI)技术的迅猛发展引发了广泛关注,尤其是在其庞大的能源需求方面。随着大型模型的训练与推理不断升级,能源消耗和碳排放成为不可忽视的议题,给人们的可持续发展目标带来了挑战。然而,纵观整个产业链,从算法设计到芯片技术再到数据中心的建设管理,均出现了诸多创新举措,这些努力为AI能源使用带来了更多乐观的可能性。首先,AI模型的发展正朝着更高效的方向演进。传统上,训练深度学习模型往往依赖于海量、无差别的数据集合,模型通过反复运算在庞杂数据中自行提炼特征,这种方法不仅耗时,且因训练资源浪费巨大而导致能耗居高不下。如今,越来越多科研机构与企业采用“定制化数据集”理念,精准筛选与特定任务相关的高质量数据,取代盲目堆积数据的模式。

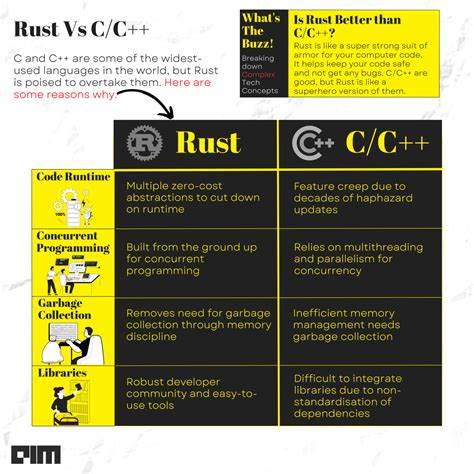

借助这一模式,模型训练步骤变得更加专注且高效,训练时间与能耗均大幅缩减。例如,一些企业运用合成数据技术,打造针对特定场景优化的训练集,不仅提高了模型表现,也有效节省了能源开销。此外,随着AI应用范围愈发多元化,市场需求促使开发更多专用且轻量化的模型取代通用大型模型。轻量化模型通常占用更少计算资源,并能满足行业中大量细分应用的具体需求,使得整体系统运行的能量消耗得到进一步控制。同时,工程师们还在积极探索更智能的推理算法,比如并行计算技术,通过拆分复杂任务,实现多线程同时处理,极大提升计算效率。这种方法不仅能加快响应速度,还帮助降低硬件负荷,进而减少功耗。

硬件层面,芯片技术的创新同样推动了AI向着节能方向迈进。尽管业界短期内依旧追求更强算力的芯片以应对因模型多样化带来的计算需求激增,长期来看,单纯依靠传统数字芯片的无限制扩张难以持续。新兴的模 analog计算技术打破了数字二进制的限制,允许信息在更广泛的数值范围内表示,从而用更少的功耗完成更多计算。此类芯片除了提升了计算精度外,还具备显著的能效优势,成为未来低功耗AI设备的核心选择。除模拟芯片外,类脑计算与光学芯片等前沿技术也逐步显现潜力。这些技术借鉴生物大脑结构及光子传播原理,试图开辟更节能的计算路径,虽然尚未进入主流市场,但为降低AI能源成本提供了宝贵的方向指引。

同时,数据中心作为AI计算的重要基础设施,也在节能方面实现了显著革新。现代AI芯片相比传统处理器功率密度大幅提升,意味着数据中心必须采取更高效的散热方案以保证稳定运行。水冷技术因其优异的传热性能被广泛采用,虽引发了对水资源消耗的忧虑,但创新的循环利用水冷系统如将余热转移用于供暖或公共设施取暖,有效减少了环境压力。还有企业研发的基于热电子效应的微型制冷晶片,能够根据硬件温度波动智能启动散热,显著提高冷却效率并降低总能耗。这些高精度温控芯片的运用,使得数据中心内冷却系统更加灵活和节能,同时配合可再生能源充足供给,数据中心正逐步朝绿色、低碳方向发展。在市场机制和商业驱动方面,能源消耗与成本紧密相关的特性促使企业实现能效最大化。

节约能源意味着直接降低运营费用,进而提升竞争力。因此,越来越多公司明确推行“效率优先”的技术战略,积极采用小型、定制化模型,并注重运行时的能源管理。这种趋势不仅符合商业利益,也与全球节能减排目标不谋而合。随着人工智能技术日益普及与成熟,价格逐渐趋于平民化,更多中小企业和个人用户加入应用行列。历史经验显示,技术革新往往伴随着更高能效,比如互联网和个人计算机的普及期,用户数量暴增却未导致能源消耗线性增长,反映出技术与效率的良性循环。未来,市场竞争将进一步推动芯片制造商和AI服务提供者优化技术和运营,促成人工智能更加环保节能。

综合来看,纵使当下AI在计算及能源需求方面仍存在不小的挑战,技术进步的连续涌现为解决能源困境送来了曙光。模型定制化、硬件创新、数据中心散热改进与经济激励机制的相辅相成,使得人们有充分理由对AI能源使用保持积极的期待。持续的研发投入和政策支持或将帮助这一领域催生更多颠覆性成果,推动AI产业在保障性能的同时,迈入绿色可持续发展的新时代。