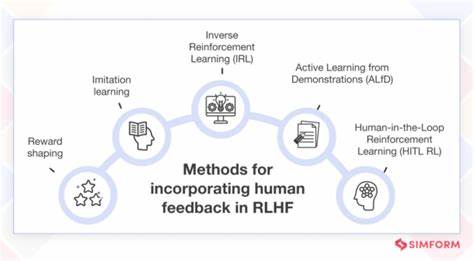

近年来,人工智能领域中的语言模型持续迅猛发展,尤其是大型语言模型(Large Language Models, LLMs)如GPT系列获得了广泛关注。如何使这些模型在应用场景中更贴近用户意图、生成更加符合期望和质量更优的文本,成为研究的热门方向。基于人类反馈的强化学习(Reinforcement Learning from Human Feedback, RLHF)则提供了一种有效的方法,通过模拟和学习人类对模型输出的反馈,进一步优化和调整模型的表现。本文将围绕RLHF的理论原理及具体实现展开介绍,重点结合一个开源项目中基于Jupyter笔记本的教学习例,全方位剖析RLHF的三大核心步骤及实操细节。 RLHF的核心理念在于通过强化学习手段,使预训练语言模型能够根据人类反馈进行调整,从而输出更符合预期或者用户需求的文本。传统的强化学习往往依赖于环境或人类直接给出的奖励信号,而RLHF的方法则创新性地引入奖励模型(Reward Model),先通过人工标注的数据训练该奖励模型,使其能够预测质量优劣,再在奖励模型的指导下对语言模型进行强化学习优化。

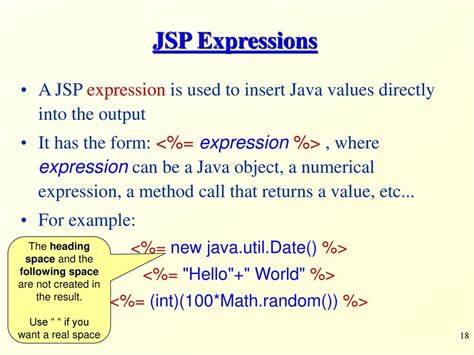

这种方法兼顾了人类反馈的准确性与强化学习的自主能力,显著提升了模型适应性的同时避免了人工标注工作的大量重复。 具体来说,RLHF的流程一般包含三个关键步骤。首先是有监督微调(Supervised Fine-Tuning, SFT),这一阶段通常基于已有人类优质问答数据或特定场景的数据集,通过标准的有监督学习方法微调预训练模型,使其能够更好地生成符合训练样本特征的文本。接下来是奖励模型训练阶段,研究人员会引入额外的“奖励头”结构作为预训练语言模型的一部分,通过对人工排名标签的学习,使奖励模型能够对生成文本进行打分,模拟人类对文本优劣的判断。最后则是利用强化学习算法对策略模型进行进一步调整,在该阶段策略模型会基于奖励模型的评分对输出生成序列的概率分布进行优化,从而提升生成文本的质量和符合人类偏好的概率。 在实际应用中,为了帮助研究者和开发者快速理解和应用RLHF,一些开源项目开发了基于Jupyter笔记本的逐步演示,配合详细的代码实现和注释。

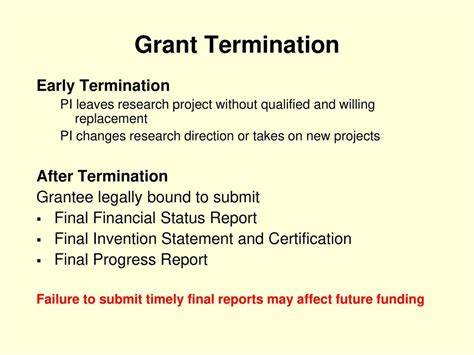

以现有的开源项目为例,该项目利用GPT-2作为预训练基础模型,结合斯坦福情感分析数据集(sst2)完成了利用RLHF生成积极情感句子的典型案例。项目中设计了三个独立但紧密相关的笔记本文件,分别对应RLHF三大阶段:1-SFT.ipynb实现了对GPT-2的监督微调,训练模型生成符合情感标签的文本;2-RM Training.ipynb则定义了带有奖励头的GPT-2模型并训练奖励模型,准确预测句子的情绪倾向;3-RLHF.ipynb则正式运行PPO(Proximal Policy Optimization)强化学习算法,以奖励模型打分为反馈,优化策略模型的文本生成能力。 这一流程不仅让模型能够有效学习情感属性,还使得生成文本更加自然且符合预期的积极情绪。值得注意的是,整个过程的设计极具通用性,尽管示例聚焦于情感分类,但同样适用其他需要结合人类反馈调整的大规模语言模型场景。通过环境变量和Hugging Face访问令牌的设置,使用者还能够便捷获取预训练权重,确保本地或云端环境的顺畅运行。 RLHF技术的最大优势在于它结合了人类监督学习的优点和强化学习的灵活性,解决了纯强化学习中奖励信号稀疏且不稳定的难题,同时远超传统监督学习在对实际用户偏好适应性的表现。

其运用不仅限于聊天机器人和文本生成,也逐渐扩展到内容审核、个性化推荐系统以及自动化写作辅助工具等领域。通过RLHF,语言模型能够持续从真实环境中进一步提升响应质量,实现更加自然和可信的语言交互体验。 从研究角度看,RLHF也推动了奖励模型架构、策略梯度算法及稳定训练技术等多方面的发展。诸如PPO等先进强化学习算法,能确保训练过程中的参数调整安全且有效,避免模型因过度优化出现性能崩溃问题。此外,针对奖励模型训练过程中公平性和鲁棒性的挑战,社区内不断探索多样化的反馈采集策略和模型正则化手段。 总体而言,基于人类反馈的强化学习正在为自然语言处理带来深刻变革。

借助开源项目提供的清晰路径与实际代码示例,技术人员能够更快速上手并灵活应用RLHF架构,推动对话系统和其它生成任务的性能跨越式提升。在未来,此类结合人类评判与机器自我优化的混合智能方法,势必成为人工智能走向更高水平智能交互的关键利器。 对于希望深入学习RLHF的开发者,建议关注包括Hugging Face社区、OpenAI发布的相关论文和教程,以及主流机器学习会议中的最新成果。同时,动手实践上述基于GPT-2与斯坦福情感数据集的案例,有助于加深理解强化学习和奖励模型训练的细节,掌握提升语言模型生成质量的实用技巧。总结来看,RLHF不仅是一种技术创新,更是实现人机协作智慧升级的桥梁,为打造更智能、更人性化的AI系统奠定坚实基础。