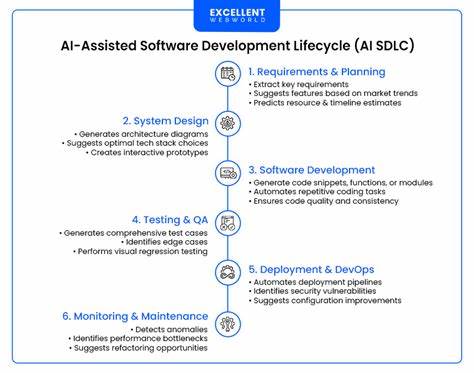

随着人工智能技术的日益成熟,AI辅助开发已经成为现代软件工程不可或缺的关键环节。然而,传统云端AI服务在数据隐私、网络依赖及成本控制方面存在诸多挑战,尤其是在涉及敏感数据和受监管行业时,开发者需求愈发多样化和严苛。面对这些问题,本地AI模型的兴起为开发者带来了全新的解决方案。借助本地模型,开发者能够在自己的设备上运行智能模型,确保数据安全与控制权,同时提升开发效率和灵活性。微软旗下的Foundry Local与GitHub Copilot的深度整合,完美诠释了这一趋势,为AI辅助开发注入了新的动力。 Foundry Local是微软推出的前沿技术平台,旨在实现本地AI模型与开发环境的无缝连接。

通过Foundry Local,开发者能够在Visual Studio Code(VS Code)中直接调用本地模型,摆脱对云端计算资源的依赖。这不仅有效降低了数据泄露风险,更减少了因网络波动带来的生产力损失。Foundry Local支持一系列优化的代码生成和自然语言处理模型,如多语言能力强劲的Qwen模型、高效推理与代码生成的Microsoft Phi模型以及兼具兼容性和高级能力的OpenAI GPT模型,为开发者提供多样化选择。 在实际使用中,开发者只需安装VS Code,并添加GitHub Copilot与AI Toolkit扩展,即可通过Foundry Local便捷地管理本地AI模型。用户可通过模型选择器灵活切换不同模型,满足项目多样化的需求。AI Toolkit则作为一站式管理工具,支持模型下载、更新和配置,极大简化了模型的维护工作。

此外,Foundry Local的集成过程简单直观,用户体验极佳,无需复杂的配置即可迅速上手,提高整体开发效率。 隐私保护是本地模型最大的优势之一。与传统云端AI不同,Foundry Local保证所有查询和数据处理均在本地设备完成,不涉及数据传输至远程服务器,极大提升了数据安全性。这对于金融、医疗、政府等对数据隐私要求较高的行业尤为重要。同时,通过本地运行模型,企业和个人能够全面掌控AI工具运行环境,随时调整算法和策略,实现高度定制化的开发流程。 从成本角度来看,采用本地模型同样具备显著优势。

云端AI服务往往伴随着高昂的计算和数据传输费用,尤其在大规模使用时,成本压力明显。Foundry Local利用本地硬件资源,避免了持续的云端计费,实现了经济高效的AI开发模式。AI Toolkit还支持混合模式,允许开发者根据具体情况灵活选择本地或云端模型,优化资源调度,最大程度地节约成本。 模型的灵活性与管理能力是Foundry Local不可忽视的亮点。开发者不仅可以使用预置的多款主流模型,还能够根据项目需求集成自定义模型。这种开放性极大满足了不同领域专业开发者对AI工具的个性化需求。

统一的管理界面让模型的添加、切换和更新变得轻松自如,无需跳转多个平台或工具,极大提升了工作流的便利性和连贯性。 深度融合VS Code和GitHub Copilot使得Foundry Local的应用更加顺畅。VS Code作为当前最受欢迎的开源代码编辑器之一,配合GitHub Copilot强大的代码补全和智能提示功能,为开发者提供全面的辅助支持。Foundry Local的本地模型赋能,将这些智能工具的潜力发挥到极致,无论是在无网络环境下还是面对高敏感度数据的开发场景,都能保证开发体验的连续性和高效性。 围绕Foundry Local,微软不断优化用户体验和功能集成,致力于打造统一、简洁且强大的AI辅助开发平台。直观的界面设计减轻了开发者的学习负担,使其能够专注于核心编码任务而非环境配置。

随着社区和生态的不断壮大,基于Foundry Local的本地AI开发模式有望成为行业主流,推动开发效率和数据安全双赢。 展望未来,本地AI模型的发展潜力巨大。一方面,随着硬件性能的提升,复杂模型的本地运行已成为可能,进一步丰富了AI辅助工具的功能。另一方面,隐私法规趋严和用户对数据安全意识的增强,必将驱动更多企业和开发者采纳本地AI方案,减少对云端依赖。同时,本地模型的开放可定制属性为人工智能的创新提供了广阔空间,促进跨领域的技术融合与应用扩展。 从个人开发者到大型企业团队,本地模型辅助的AI开发正在重塑软件开发的未来格局。

微软Foundry Local与GitHub Copilot的深度结合,凭借其卓越的隐私保护、灵活管理和高效集成优势,为用户带来了革命性的开发体验。随着行业不断探索和优化,AI辅助开发的本地化趋势必将成为推动技术进步和数字化转型的重要驱动力。开发者若能及时把握这一趋势,将在激烈的技术竞争中占据先机,释放更加创新和高效的开发潜力。 。