人工智能(AI)作为科学技术的前沿领域,已经成为21世纪最受关注的技术之一。几十年来,人工智能在学术和工业界经历了多次浪潮,从早期的符号主义AI到神经网络,再到现代的深度学习技术。然而,最近的趋势显示,AI的定义正在经历显著的变化,尤其是在公众认知和行业聚焦方面,‘AI’几乎已经成为大型语言模型(LLMs)的代名词。这一现象不仅反映了技术发展本身,也揭示了人工智能领域未来的发展方向。要理解为什么‘AI’如今主要指大型语言模型,需要回顾人工智能的发展历程及其现阶段技术成就。与人工智能不同类型技术和方法相比,LLMs因其独特优势和广泛应用迅速占据主导地位。

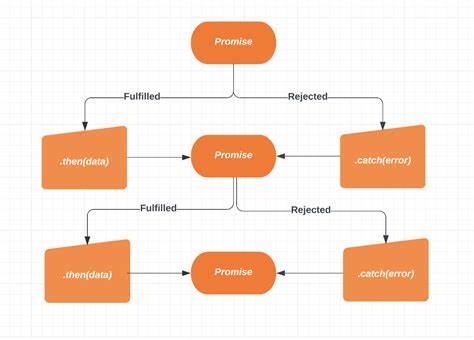

早期的人工智能研究曾试图通过规则和逻辑推理构建智能系统,这种符号主义方法在计算能力有限的时代曾显得极具吸引力。随着计算资源的增强,人类开始探索数据驱动的方法,神经网络的兴起和深度学习技术的突破为人工智能带来了新生。特别是自2011年AlexNet的引入,深度学习架构开始在图像识别、语音识别和自然语言处理等领域表现出超乎想象的能力。大型语言模型作为深度学习在自然语言处理上的杰出应用,能够通过海量文本数据训练出强大的语言理解和生成能力。LLMs不仅能模仿人类语言表达,还能在文本创作、翻译、问答、代码生成等任务中表现出色,极大地拓宽了人工智能的应用场景。当前市面上的先进模型,如OpenAI的GPT系列,已经展示出代码编写、数学推理、创意写作等多方面的潜力,成为推动AI技术商业化和普及的核心元素。

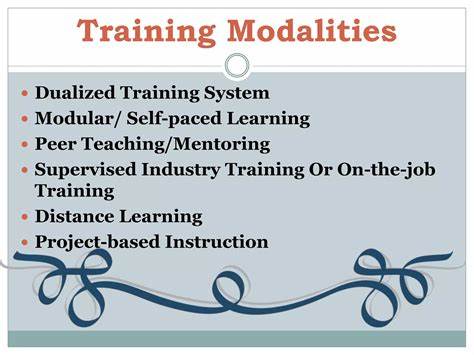

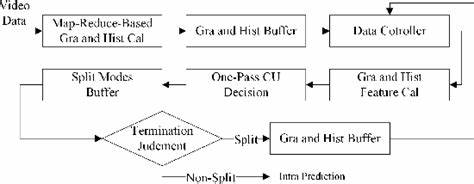

这种能力使得大型语言模型成为唯一能够接近人类智能的数字系统,其他类型的AI技术尚无模型在广泛领域实现类似的跨任务表现。尽管此前人工智能领域有许多不同的研究路径和技术方向,包括计算机视觉、强化学习、无监督学习以及机器人技术等,但这些领域多数依赖于特定任务和应用场景,难以实现通用的智能水平。相比之下,LLMs通过对语言这一信息载体的全面理解,连接了人类知识的方方面面,使它们成为实现通用智能的最佳候选者。大规模预训练语言模型的成功依赖于数据的丰富性和训练方法的创新。通过在互联网上爬取和整理海量文本,模型得以学习语法、语义、上下文关联,甚至间接获得世界知识。结合微调技术和多轮对话策略,这些模型越来越接近具备现实世界理解和推理能力的人工智能系统。

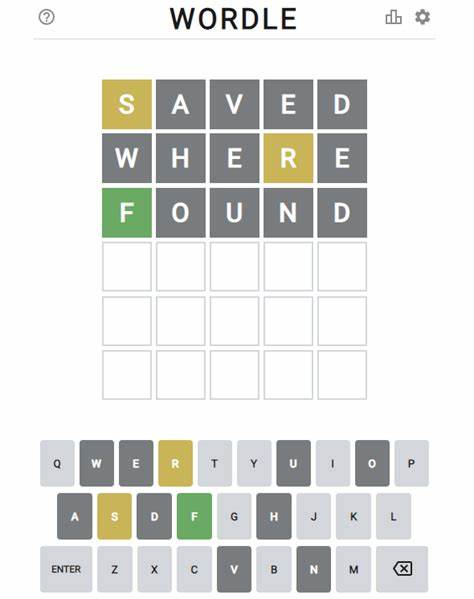

然而,尽管LLMs在许多领域表现惊艳,仍无法简单等同于人类智能。它们的“智能”更多是统计和模式识别的结果,缺乏真正的自主意识、自我反思和情感理解。这也导致了公众对LLMs创意能力和推理深度的质疑。大型语言模型通常根据训练数据中的概率分布生成答复,这在某种程度上限制了它们产生创新性和独特性的潜力。针对这一局限性,研究者们积极探索多模态融合、强化学习和基于代理的系统,试图将LLMs整合到更复杂的智能生态中,增强它们的实际应用能力和创造力。对人工智能发展史的回顾表明,人工智能最初的追求是建立类似于人脑的智能体系。

生物神经网络的结构和机制为AI算法设计提供了灵感,但完全模拟人脑的复杂度仍远未达成。相较于生物神经元间高效的信息处理和动态变化,现代神经网络的结构仍过于简化,缺乏对意识和知觉等复杂现象的解释能力。科技界对量子计算对意识形成的可能影响也展开了讨论,认为经典计算模型难以捕捉人脑神秘的运行机制,暗示目前的AI研究还有很大的认知鸿沟。因此,虽然大型语言模型目前代表了人工智能技术的主流进展,但未来通往超智能还需要突破现有方法的局限,融合更多学科知识和全新计算范式。展望未来,LLMs有望继续推动人工智能的广泛应用,包括自动写作、医疗诊断辅助、智能客服、教育辅导以及创新设计等领域。它们的发展也带来了巨大的社会影响,如劳动力市场结构变化、伦理道德挑战以及隐私保护问题。

与此同时,围绕AI安全性和可控性的研究日益得到重视,确保智能系统符合人类价值观和法律规范成为核心课题。人们期待通过多代理协同、模型解释性提升以及人机混合智能体系建设,实现人工智能向真正智能体的跨越。总之,当前的人工智能领域已由多元化技术竞争转向以大型语言模型为核心的技术集中。LLMs凭借其强大的语言理解和生成能力,不断刷新人们对AI的认知界限,成为当前智能革命的主力军。它们不仅代表了人工智能研究的最新成果,也映射出未来智能系统设计的新方向。然而,真正的超级智能还有很长的路要走,科学家和工程师需要继续探索融合跨学科知识的新方法,以解决现有模型在创造力、通用性和情感理解方面的不足。

随着研究的深入和技术的进步,LLMs有望与其他智能技术相结合,催生更加多元和强大的人工智能生态,持续推动社会进步和生产力提升。