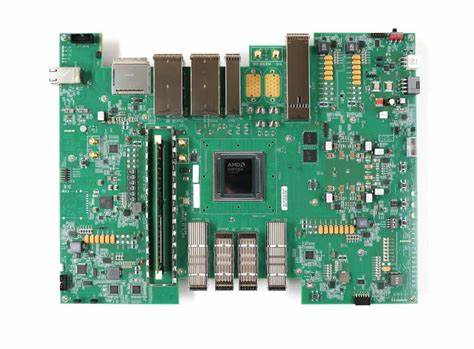

随着人工智能技术的不断发展,大型语言模型(LLMs)如ChatGPT、Claude、Gemini等在我们的日常生活和工作中发挥着越来越重要的作用。人们惊叹于它们在瞬间解决复杂问题的能力,仿佛拥有无穷的知识宝库。但当我们针对自己熟悉的领域提出问题时,出现的回答却常常令人大跌眼镜。这种体验恰恰体现了一个有趣的现象——盖尔曼失忆效应。盖尔曼失忆效应最早由科幻作家迈克尔·克赖顿提出,描述的是人们在面对自己熟悉领域的错误信息时能够识别其错误,但在阅读其他领域的报道时却会将其视作权威而完全忽视之前的认知偏差。把这一效应放在大型语言模型上,我们也能发现类似的规律。

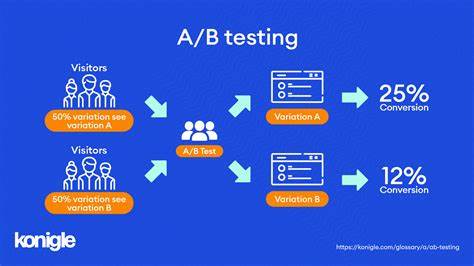

使用LLMs获取信息时,面对未知领域的咨询往往能够收获质的飞跃,解决长时间难解的问题。但当问题涉及某个专家领域或深度知识时,模型的答案有时会流露出表面化、片面甚至错误的事实。这一现象的背后原因,既与训练数据的广泛性有关,也反映了当前人工智能理解深度的局限。大型语言模型依赖于海量数据进行训练,覆盖了方方面面的知识,但它们主要基于语言模式识别和概率预测,而非真正的理解或逻辑推理。因此,在不熟悉领域它们能凭借强大的语言关联推断给出合理答案,而在专业领域却难以揣测其中细微的原理与逻辑。此外,盖尔曼失忆效应在使用场景中的影响也值得深思。

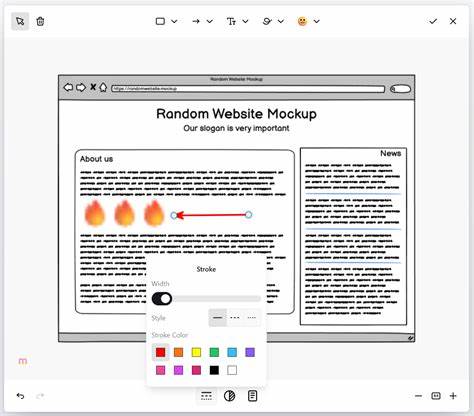

对于普通用户而言,LLMs不仅能提供快速便捷的知识获取途径,还能激发创造力和学习兴趣。然而,对于专业人员来说,盲目信任模型输出可能带来误导甚至风险。尤其是在科研、医疗、法律等领域,错误信息的后果尤为严重。有人提出了“vibe coding(氛围编码)”的观点,认为即便从未深入学习过某个领域的开发者,也能借助LLMs快速生成应用原型。但如果无法鉴别模型的偏差和错误,最终产品可能不过是“垃圾软件”的集合。反之,有经验的开发者可以利用模型提供的帮助,同时在关键环节把控质量,从而将开发效率和创新能力最大化。

这也体现了人机协同的重要性。在这一过程中,用户既是知识的消费者,更是过滤器和校验者。提高自身专业素养和批判性思维是充分发挥大型语言模型价值的关键。未来的人工智能发展方向或许将更侧重于增强模型的事实核验能力和逻辑推理深度,弥补目前仅依赖模式匹配的不足。跨领域的数据融合、多模态学习以及人类反馈机制的引入预计将提升LLMs的精准度和可靠性。同时,围绕如何教育用户正确使用和理解AI的讨论也日益重要。

社会各界需要共同构建透明、可解释和负责任的AI生态,以避免盲目崇拜和盲目信任。总体而言,将大型语言模型视作“终极盖尔曼失忆机器”,不仅让我们洞悉其强大与脆弱之处,也促使我们反思知识获取的本质和局限。它既是工具,更是镜子,映射出人类认知的盲点和偏差。正确的态度应是既欣赏它带来的便利和创新,又保持理性和谨慎,努力填补专业知识差距,推动AI技术和人类智慧的融合发展。在这个信息爆炸的时代,大型语言模型为我们打开了前所未有的知识之门,但如何走出迷雾、辨明真伪,依然需要每个人持续的学习和洞察。只有如此,人工智能才能真正成为助力人类进步的利器,而非迷惑和误导的源头。

。