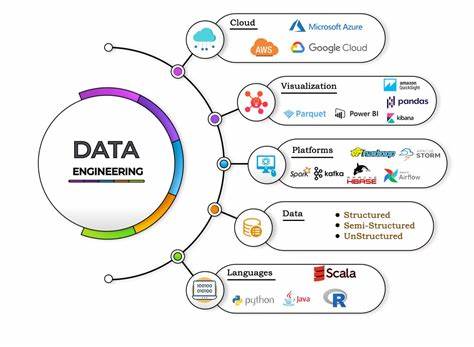

随着大数据、云计算和人工智能的快速发展,数据工程作为连接数据生成与分析的核心角色,其重要性日益提升。回顾过去二十年,数据工程经历了从传统ETL处理到现代数据流水线自动化和云原生架构的繁荣转变。如今的成功数据工程师不仅需要扎实的编程及数据库知识,还需具备系统运维、容器编排、基础设施自动化等多维技能。2025年的数据工程领域,已经成为高度技术融合的复杂生态,其工具与技术栈亦日益丰富与多样化。基于真实积累的经验与行业洞察,“数据工程工具包”应运而生,帮助从业者理清技术脉络,掌握关键技能,助力职业跃升。数据工程工具包涵盖了七十余种技术与工具,贯穿十个核心知识领域和多种编程语言,形成了全面且实用的技能体系。

首先,扎实的系统基础能力奠定了数据工程师的根基。Linux命令行的精通是每个数据工程师的起点,包括curl、rsync、bat及ripgrep等工具的熟练应用,能够极大提高数据获取和处理效率。环境变量管理、定时任务(Cron)以及Makefile的利用,促进了自动化脚本的高效管理与执行。同时,掌握Windows子系统Linux(WSL)环境,为跨平台开发与调试提供便利,极大提升开发灵活性。其次,现代开发环境与集成开发工具链是数据工程高效开发的重要引擎。VS Code、Cursor等代码编辑器的智能插件和AI辅助功能,以及GitHub Codespaces和云端笔记本(如Jupyter)等远程协作平台,让数据开发和调试更加流畅顺畅。

Git及其可视化工具Lazygit的熟练使用,保证了代码版本管理的规范与可靠。数据和SQL基础能力始终是数据工程的重中之重。熟统的SQL语言编写能力,PostgreSQL等关系型数据库管理系统的深入应用,和面向分析的DuckDB或Spark SQL等查询引擎,成为高性能数据查询和处理的底层支撑。同时Pandas、Arrow和Polars等数据框架也有效缩短数据转换和探索的时间,提升分析效率。Python作为数据工程的首选语言,拥有强大的库生态支持。从网络请求的Requests和网页解析的BeautifulSoup,到应用构建的Typer、测试框架Pytest、代码质量控制的Ruff,都覆盖了数据工程各个环节,支持从数据采集、清洗到调度执行的全流程开发需求。

数据架构及数据管线设计同样是不可或缺的核心技能。数据流建模、数据建模与数据库设计融会贯通,明确了数据生命周期与业务需求的对应关系。以ETL/ELT流程为核心的数据转换管线设计与实现,结合数据验证与质量保障机制,确保数据准确性与一致性。数据目录和业务数据血缘管理,优化了数据资源的可管理性和可追踪性。领先的调度和业务智能工具推动数据工程智能化进阶。dbt(Data Build Tool)为典型代表,通过SQL化数据转换流程实现数据建模的持续集成。

Apache Airflow和Dagster等现代工作流调度平台,支持复杂依赖管理与灵活扩展,提升数据管道的可靠性和可维护性。商业智能工具和数据分析平台的巧妙结合,也为业务决策提供了实时且精准的支持。在基础设施层面,Docker容器技术与Kubernetes编排成为现代数据工程不二法门。通过容器化,数据工程环境实现标准化,避免环境差异导致的兼容问题。Kubernetes及其命令行工具kubectl则实现了容器集群的高效管理与弹性调度。配合Helm、Kustomize等配置工具,实现基础设施即代码的思路,基础设施部署与版本管理得以自动化和可追溯。

Terraform作为基础设施编排利器,助力跨云环境资源自动申请和生命周期管理。这一切组合赋能数据工程团队实现持续交付(CI/CD),并轻松集成安全加密管理如SOPS和PGP。此外,最新的存储技术和工具也极大丰富了数据工程的技术栈。MinIO和S3兼容对象存储提供了弹性、可靠的海量数据存储解决方案。列式存储格式Parquet因其高效压缩和查询规划能力,广泛应用于大数据场景中。同时,命令行工具tmux、Vim快捷键 motions、Lazydocker和k9s等辅助工具提升了运维的生产力和用户体验。

引入开放表格格式和数据目录,强化了数据治理和互操作性,为现代数据湖架构提供坚实基础。随着人工智能技术的兴起,数据工程亦迎来了全新发展机遇。融合大语言模型(LLM)的AI工作流集成,生成式BI工具GenBI带来了自动化报告和洞察发现的新范式。使用向量数据库和Embedding技术,实现了语义搜索与情境感知搜索的场景突破。Model Context Protocol(MCP)和RAG(Retrieval-Augmented Generation)等新兴技术,则帮助数据工程师更加轻松地构建智能知识库和增强型推荐系统。数据质量管控与可观察性成为保障数据价值的重要环节。

Great Expectations和Pandera等开源框架,提供了结构化的数据验证与质量检测手段。OpenLineage标准和Data Contracts,协助在复杂数据管道中实现可靠的血缘追踪与治理。模式演进(Schema Evolution)与注册(Schema Registry)技术有效应对数据模式变更风险,防止数据漂移带来业务中断。结合实时监控与告警机制,极大提升数据团队对异常状态的响应速度和处理能力。纵观这一切,现代数据工程师的角色早已超越传统的ETL技术范畴,成为集开发、运维与数据治理于一体的多面手。DevOps概念的深入融合,使得一切基于代码的工具链和自动化成为常态,持续交付和基础设施自动化是日常工作的核心。

二十年的积累证明,技术广度与深度的双重提升,是数据工程职业成长的关键。努力掌握和应用这些技术,不仅能够应对复杂多变的业务需求,还能让数据工程的价值最大化。在未来,数据工程将继续朝着云原生、自动化以及智能化方向发展,掌握今天的工具和知识,就是赢得明天竞争的资本。任何数据工程师,不论是初学者还是资深人士,都能从这套经过验证的工具包中汲取力量,迈向更加卓越的职业发展。