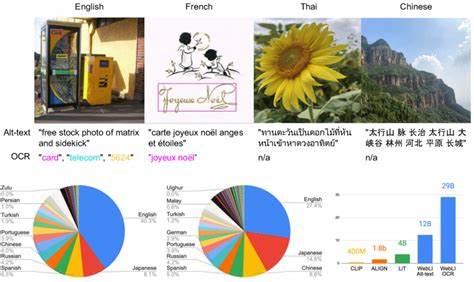

近年来,随着人工智能特别是大型语言模型(LLM)的迅猛发展,数据的重要性愈加凸显。优质且充足的训练数据是提升模型表现的基础,尤其是在多语言领域,这一挑战尤为突出。英文学术界和工业界已经积累了包括英文在内的多种高质量大规模预训练数据集,但对于其他语言,数据匮乏、不均衡的问题依然制约着更强大、更普适的多语言模型的发展。近期,来自Guilherme Penedo及其团队发布的FineWeb2项目,突破性地建立了一个覆盖互联网全域,体量达20TB、包含超过50亿文档、跨越超过1000种语言的多语言预训练数据集,重新定义了多语言模型的预训练标准与未来方向。 传统的数据处理管线难以高效适配众多语言,尤其是许多资源匮乏的语言不仅文本质量参差,且存在独特的语言结构,使得统一的数据清洗、过滤与去重流程异常复杂。FineWeb2项目创新性地设计了一套基于FineWeb的自动化数据处理管线,该管线能够针对各类语言灵活调整策略,有效提升了数据集的质量与多样性。

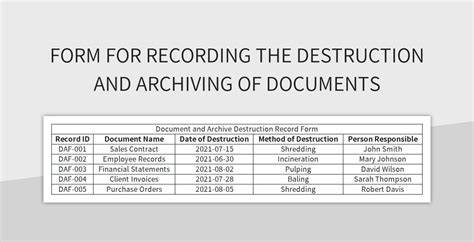

研究团队通过对九种语言展开广泛的消融实验,结合一套科学的评估任务体系,从语言多样性、文本质量、重复率等多个维度优化管线设计,确保收录的文本既丰富又具代表性。 此外,FineWeb2中提出了全新的数据重平衡方案,该方案综合考虑重复内容数量及对应文本质量,能够动态调整样本权重,避免部分语言或重复高的内容过度主导模型训练,提升训练效率与模型泛化能力。该方案为多语言数据集构建树立了新的方法论,有助于开发更公平且表现均衡的大型语言模型。 使用近100份来自Common Crawl的网络快照,FineWeb2的数据规模达到了惊人的20TB,覆盖了超过1000种语言。如此大规模且语种广泛的组合,为训练具备全球适应性的语言模型提供了坚实基础,同时也为低资源和隐晦语言的建模开启了新可能。研究团队不仅开源了数据集,更是同步发布了相关的数据处理管线、训练代码以及评估工具,为学界和工业界提供了极大便利,推动多语言NLP领域的生态建设。

FineWeb2的发布将多语言预训练从以前的实验室规模跃升到了工业级实用层面,提升了多语言模型在翻译、文本生成、语义理解等多项下游任务中的表现。它为解决长久以来的自然语言处理语言鸿沟提供了现实可行的路径。无论是多语种搜索引擎、跨文化内容生产,还是全球化的语音助手和智能客服,FineWeb2都将为这些技术的进步提供战略支持。 未来,基于FineWeb2规模和方法的扩展,预计更先进的语言模型将能够处理更多罕见语言的细节,理解更广泛的文化背景,进而实现更为精准和个性化的自然语言处理服务。随着模型与数据的不断推进,跨语言交流障碍将逐渐消融,人工智能的全球普及将迎来新篇章。 总而言之,FineWeb2项目是多语言大规模数据集领域的里程碑。

它不仅展示了自动化、可适配预训练数据处理管线的巨大潜能,更以宏大的数据规模和全球化语言覆盖,标志着多语言预训练进入了一个全新阶段。致力于为全球用户及开发者提供更强大、更具包容性的语言技术解决方案,这一成果无疑将在未来的人工智能发展航程中起到关键推动作用。