随着人工智能技术的飞速发展,计算硬件的性能和效率需求不断攀升。在此背景下,NVIDIA最新发布的Blackwell架构GPU凭借其对低精度计算的原生支持,特别是对4位和6位子字节浮点格式的优化,为深度学习模型的训练与推理带来了全新的可能性。Cutlass作为NVIDIA提供的高性能矩阵乘法库,通过多年的发展积累了丰富的低精度运算经验,在Blackwell架构下更是将子字节GEMM(通用矩阵乘法)推向了新高度。本文将深入剖析Cutlass在Blackwell GPU上的子字节GEMM实现,涵盖其底层硬件支持、PTX指令编码、内存布局以及软件抽象层的设计,助力开发者充分利用低精度计算优势。首先,需要理解为何当前AI领域愈发重视低精度计算。传统的32位浮点(FP32)因其较高的计算和存储开销,难以满足大型模型或实时推理系统的高效需求。

相比之下,减少数据位宽不仅显著降低模型所需存储空间,还能极大提升吞吐量和节能效果。NVIDIA从其Volta架构开始支持半精度浮点(FP16),随后引入BF16、TF32以及整数量化技术。Blackwell架构则首创性地支持子字节精度,包括6位和4位浮点格式,为AI量化推理带来范式级的变革。Blackwell GPU的子字节浮点类型包括E3M2(6位,3指数及2尾数位)、E2M3(6位,2指数及3尾数位)及E2M1(4位,2指数及1尾数位)等,这些格式在保持模型表达能力的同时,有效降低了量化引起的数值精度损失。值得一提的是,子字节浮点格式不包含NaN和∞,在硬件设计上为简化逻辑电路提供了便利。硬件层面,Blackwell架构引入了专用的张量核UMMA(统一矩阵乘法加速器)指令集,其中tcgen05.mma指令支持.f8f6f4类模糊数据类型,允许混合使用8位、6位和4位浮点数操作。

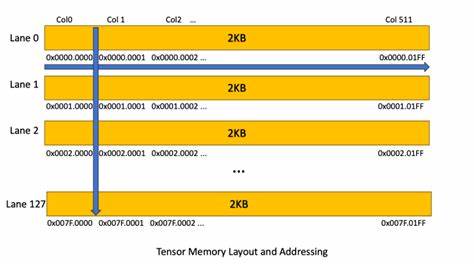

这种灵活的数据类型支持使得开发者可以根据场景需求,灵活调整输入权重或激活的位宽以平衡精度与效率。值得强调的是,为确保数据传输和计算的正确性,UMMA对于GEMM卷积的K方向长度固定为32,且子字节操作数在内存中被填充到了字节(8位)对齐的格式。这种内存策略虽然牺牲了部分存储密度,但保证了硬件指令的高效执行。为了最大限度减少内存带宽的浪费,Blackwell引入了Tensor Memory Accelerator(TMA)机制,支持将全局显存(GMEM)中的紧凑子字节数据格式,自动转换成SMEM(共享显存)中16字节对齐且填充的数据形式。相应的,TMA提供了CU_TENSOR_MAP_DATA_TYPE_16U4_ALIGN16B和CU_TENSOR_MAP_DATA_TYPE_16U6_ALIGN16B两种专门的子字节加载类型,分别应对4位和6位紧凑数据的展开。这些操作保证了GEMM核在访问数据时的对齐性和一致性,进而避免因非对齐访问带来的性能损失。

同时,Blackwell架构对TMA内存访问设置了更严格的对齐和大小限制,比如TMA请求基地址需32字节对齐,且加载张量的行主维度大小需是128元素的整数倍。这些规范虽对数据预处理提出了额外要求,但确保了硬件流水线的最优表现。Cutlass库以对这一底层硬件细节的深刻理解为基础,构建了丰富的API和数据结构来简化子字节GEMM核的开发。cutlass/float_subbyte.h文件中定义了多种子字节数据类型,例如float_e3m2_t、float_e2m3_t以及float_e2m1_t等,这些均继承自基本浮点基类,支持基础数学运算(尽管子字节运算最终在软件层面通过FP32模拟完成)。Cutlass中进一步为UMMA与TMA准备了专用的_unpacksmem_t版本,如float_e3m2_unpacksmem_t,指示采用SMEM中16字节填充的内存格式。这样设计保证了TMA默认使用的16字节对齐加载能与UMMA指令无缝匹配。

开发者在调度GEMM计算时可利用CUTLASS的collective builder API基于上述数据类型构造适当的计算流水线,同时利用sm1xx系列的辅助函数检查GMEM与SMEM对齐情况,避免潜在的内存访问错误。值得注意的是,CUTLASS支持运行时动态指定各输入操作数的数据类型,而不必为每种组合单独编译二进制。在PTX级别,通过修改tcgen05.mma指令的kind参数和描述符中的a_format_、b_format_字段,程序可以灵活切换混合精度运算。例如,可在同一内核中使用权重的4位表达与激活的6位表达,实现存储带宽与运算精度的权衡。关于内存层级的细节,UMMA的operand A支持来自TMEM(张量共享存储器)和SMEM两种数据源,其中TMEM中的子字节数据需以1字节对齐格式存放,且通过tcgen05.cp指令提供从16字节填充SMEM数据向TMEM压缩映射的能力。SMEM层面,所有子字节数据通常以与8位数据同样大小的uint8_t类型分配,以确保数据访问的简洁和高效。

同时,为应对混合精度带来的数据格式复杂度,CUTLASS在布局选择和swizzling策略上提供灵活方案,通过内部工具函数选择最优存储分布,助力开发者兼顾存储空间与性能要求。除了数据格式与内存优化,Blackwell架构还引入了block-scaling量化技术,允许以组为单位为子字节数据设计独立的缩放因子,显著缓解低位宽数据的数值溢出与精度损失问题。虽然block-scaling的实现复杂度较高,但其对AI模型推理精度提升有显著贡献。Cutlass将于系列后文详细介绍这一功能。总结来看,NVIDIA Blackwell平台在硬件级别对子字节低精度GEMM的支持,通过创新的张量核心设计、内存访问协同和动态数据类型管理,实现了前所未有的计算效率和灵活性。Cutlass作为NVIDIA官方打造的矩阵乘法库,充分抽象了底层复杂性,为开发者提供了开箱即用的高性能接口。

通过合理使用浮点子字节格式、精细设计内存布局及利用TMA解压缩机制,能够显著提升大规模神经网络的推理速度和存储利用率。展望未来,子字节GEMM与block-scaling等量化技术的结合将引领人工智能硬件算力发展的潮流,推动更多创新应用落地。针对黑科技层面的深入研究和对开源库的不断完善,将持续为AI开发者带来强大助力,促进行业不断向前。