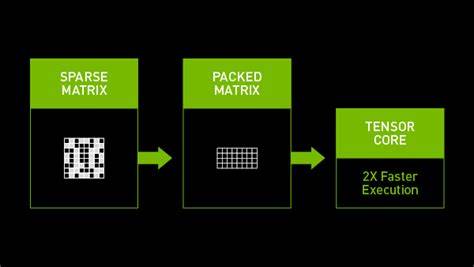

随着人工智能技术的迅猛发展,模型规模越来越庞大,计算资源需求也随之攀升。面对这一挑战,稀疏性(Sparsity)作为优化机器学习模型的一种重要技术手段,逐渐成为业界关注的焦点。稀疏性不仅能够有效减少模型的计算量,还能降低能耗,提高运行效率,特别是在硬件资源有限的设备上更具重要意义。什么是稀疏性?它为何对现代AI发展如此关键?本文将围绕这些问题展开深入探讨。 稀疏性的核心在于将神经网络中的部分元素设为零,形成所谓的稀疏模型。与密集模型(Dense Model)不同,稀疏模型包含大量的零值节点。

这些零值不是缺失数据,而是明确指定为零的数值,表示该节点或参数没有实际的计算贡献。这一点非常重要,因为它允许系统跳过对这些节点的计算,从而节省时间和算力资源。 在传统的密集模型中,每一个神经元几乎都与下一层的每一个神经元相连,形成密集而复杂的网络结构。虽然这种方式能够支持高度复杂的计算和精准的模型表达,但其代价是巨大的计算资源消耗和较低的处理速度。相比之下,稀疏模型通过有意识地“剪枝”非关键信息,保持模型整体功能的完整性,同时大幅提升运行的效率。 一个形象的比喻是玩叠积木游戏Jenga。

叠积木的过程中,尽管可以移除部分积木块,结构依然稳固不倒。类似地,稀疏模型删除或置零了神经网络中不必要的连接,但模型性能仍然得以保持。这样的优化策略使得人工智能模型更轻量化,运行更快,消耗更低。 近年来,随着技术进步和开源模型的涌现,稀疏性技术获得了更多的应用和验证。例如DeepSeek模型利用自主研发的原生稀疏注意力机制(Native Sparse Attention),通过动态关闭不必要的网络部分,实现了模型计算需求降低40%至60%,而性能基本不受影响。此举不仅显著减少了算力消耗,也带来了显著的成本节约,这对于推动AI普及具备深远意义。

此外,通过稀疏性优化后的模型,对于显存和内存带宽的需求也大幅降低。DeepSeek团队数据显示,经过稀疏技术处理后的模型,显存消耗降低了三倍,意味着在资源受限的设备上也能流畅运行人工智能应用,这对于推动AI在移动端、远程医疗、在线教育等领域的普及具有重要推动力。 稀疏性不仅在计算层面有明显优势,还对环境保护产生积极影响。现代大型AI模型通常需要消耗大量电力资源,使得AI系统面临着高能耗和碳排放问题。通过稀疏优化,减少不必要计算的同时,也减少了总体能耗,进而实现了更绿色、更可持续的AI发展路径。 稀疏性的应用还推动了AI软硬件协同设计的发展。

设计专门支持稀疏计算的芯片和硬件,可以进一步发挥稀疏模型的效能,使得边缘设备具备承担复杂AI任务的能力,从而推动智能物联网和智慧城市的构建。 需要指出的是,稀疏性并非万能,密集模型仍在高性能、高复杂度的任务中占据主导地位。两者更多呈现互补关系,稀疏模型适合在计算资源受限、实时性要求较高的场景应用,而密集模型则适合需要极致准确度和精细表达的复杂任务。未来的AI发展趋势,将是结合两种模型优点,适应不同应用需求的多样化场景。 总的来看,稀疏性作为AI模型优化的重要策略,正在不断革新人工智能的计算模式。它不仅提升了模型运行效率,降低了成本和能耗,还推动了AI技术向更多领域和设备扩展。

面对日益增长的AI应用需求,稀疏性技术的深化和普及无疑是推动AI走向高效、绿色和广泛普及的关键一环。随着技术的不断进步与创新,相信未来稀疏性将在AI领域发挥更加不可替代的重要作用,助力构建更加智能和可持续的数字未来。