近年来,随着大型语言模型(LLMs)在自然语言处理和人工智能领域的广泛应用,强化学习(Reinforcement Learning, RL)技术愈发成为推动其能力提升的重要手段。传统的强化学习多用于游戏AI或机器人领域,而如今其结合大型语言模型的趋势,催生出一批功能强大且具有灵活性的开源RL库。这些库帮助开发者不仅能进行RLHF(基于人类反馈的强化学习),还能展开具备多步骤、多轮交互特性的代理式训练,促进LLMs向更智能、更具自主性的方向发展。随着预训练数据趋于稀缺,通过强化学习基于可验证的奖励信号对模型进行后续训练,被视为提升模型推理能力和任务完成度的有效路径。强化学习在LLM中的重要性日益凸显,结合开放源代码的思想,产生了丰富的RL开源生态。本篇内容将深入剖析当前主流的开源RL库,从技术架构、系统性能、应用场景等多个维度进行解析,为读者呈现一幅全景式的开发者工具地图。

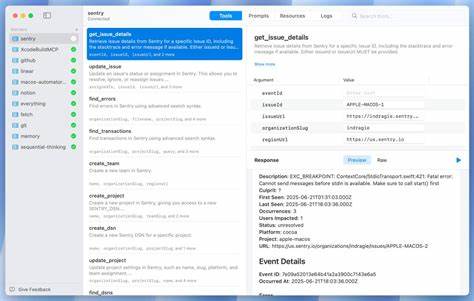

强化学习库的选择不仅关乎技术实现,也影响着模型训练的效率与效果。首先,强化学习库普遍拥有两个核心组成部分:生成器和训练器。生成器负责驱动LLM与环境交互、执行动作并收集数据和奖励反馈,训练器则依据这些数据不断优化模型策略。不同库在功能设计与接口实现上存在差异,有的侧重灵活性,方便研究人员快速迭代算法;有的则强调高性能与大规模部署能力,更适合企业级应用场景。例如,TRL是由Hugging Face推出的开源库,紧密融入其生态,擅长文本为基础的RLHF和推理模型训练,适合注重快速部署和生态整合的开发者。而由字节跳动开发的Verl则以卓越的性能和可扩展性著称,支持深度分布式训练和多种主流算法,更适合在大规模GPU集群上高效训练复杂模型。

值得关注的还有基于Verl扩展开源的RAGEN,它扩充了对多轮交互与多样化环境的支持,显著提升了多步骤代理训练的可行性。近年来,阿里巴巴发布的ROLL以及NVIDIA的NeMo-RL也投入到RLHF与多轮代理领域,强调模块化设计和高性能计算,满足了大型模型训练的多样化需求。针对异步训练与提升训练吞吐量,Ant Group的AReaL引入了中断式轨迹采样和算法调整以缓解数据陈旧问题,从而提高训练效率。学术界的新星SkyRL则突出灵活性与简单设计,支持多种权重同步策略,并适配多样化推理引擎和环境实现路径。中国学界中,清华大学联合Z.ai开发的slime库以简洁高效见长,标准化数据缓冲管理流程,专注于异步分离的训练生成模式,对于需求自定义数据生成的用户极具吸引力。开源RL库的异同也体现在推理引擎的支持范围及部署模式上。

vLLM、SGLang、Hugging Face transformers等均为主流推理引擎,各库在推理与训练部署的耦合程度不同,有的实现推理训练同节点协同以降低GPU使用率,有的则实现解耦部署以提升整体调度灵活性。异步训练的支持是另一个重要维度,能够让生成与训练过程并行进行,有助于提升硬件资源利用率,但也带来了同步复杂性和潜在的学习不稳定风险。环境抽象及其易用性也深刻影响了库的适用范围。一些库以无环境设计为主,适合单步奖励与简单RLHF应用;另一些则支持类似OpenAI gym的环境接口,允许复杂的工具调用、多步骤任务执行和多回合交互。环境的解耦也方便开发者轻松集成自定义远程或本地环境实例,增强了库对不同应用的适应力。为了协调训练、推理和环境多进程运行,诸多开源项目均选用Ray作为底层编排框架,发挥其分布式调度与容错机制优势,方便规模化部署和异构计算资源管理。

多方面的设计权衡使得各个RL库在功能定位上呈现差异化趋势。选择合适的库时,用户首先应明确自身需求,是优先考虑性能与大模型训练,还是追求接口灵活与算法创新。具体而言,性能和扩展性需求较高者可以首选Verl或NeMo-RL;需要细粒度环境和多轮对话支持则可关注RAGEN、SkyRL和ROLL;而倾向于简单易用且高灵活性的研究者,Verifiers与slime是极具吸引力的选择。强化学习在LLM领域的应用涵盖了多个使用场景,包括基于人类偏好的RLHF、以数理推理和科学任务为导向的单步推理模型训练,以及更为复杂的多步骤代理训练。RLHF通过挖掘人类反馈数据,定制奖励模型强化模型输出的偏好对齐;推理训练则助力模型进行严谨的逻辑推演和问题分解;代理训练则使得LLM能够在动态环境中自主决策和完成复杂操作任务。每种场景对库底层架构和接口设计提出不同挑战,尤其是代理训练对环境交互与生成器灵活度要求极高,促生了丰富的环境接口设计与高级采样策略。

总的来看,开源RL库的快速发展有效助力了LLM后续训练能力的提升。借助社区贡献和持续迭代,这些工具不仅在功能完整性上不断丰富,还在性能优化、用户体验及跨平台兼容性方面取得显著进展。未来,随着多模态学习、复杂任务代理的兴起以及训练算法的创新,这一领域还将迎来更多开源项目的涌现与融合。同时,针对算法稳定性、资源节约和训练效率的研究也将推动库设计进一步优化。对研究人员和工程师而言,深入理解各RL开源库的设计理念及技术特点,有助于更高效地开展LLM强化学习实验和产品落地。结合自身业务需求和资源条件,灵活选择定制合适的工具链,将实现训练与推理的最佳平衡,推动智能应用不断迈上新台阶。

。