近年来,随着人工智能技术的飞速进步,大型语言模型(LLM)在自然语言处理、文本生成等多个领域展现出强大的能力。与此同时,随着模型种类和服务提供商的不断增多,开发者在调用这些模型时面临的选择和整合问题也愈发复杂。LLM路由技术由此应运而生,成为连接不同模型资源并实现智能调用的关键技术手段。LLM路由,顾名思义,是指根据任务需求、模型特性以及外部环境自动或半自动地选择合适的语言模型进行请求处理的机制。该技术不仅能够提高调用效率,还能最大程度发挥各模型的优势,提升最终输出质量。究竟开发者需要怎样的路由功能成为业界热议的焦点。

面向开发者的需求,可以从两种典型定位展开讨论。一种是追求简化操作,期望通过一个统一的API接口自动路由到最优模型,实现无缝调用和基本工具集成,诸如网络爬虫、网络搜索等辅助功能。这类方案最大优势是降低了接入门槛,方便开发者快速上线并专注于业务逻辑,无需深入模型内部细节,适合初学者或希望快速构建应用的团队。另一种则是强调高度自定义和灵活性的路线,类似于LangChain或AI SDK的框架。开发者在此架构下可以自主设计模型调用链条,自由切换模型,构建复杂的推理流程和插件集成。虽然门槛相对较高,但给出的自由度和扩展能力显著提升,适合希望精细控制模型流程或进行深度创新的研发团队。

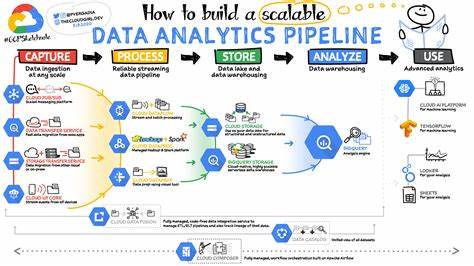

两者之间的选择实际上体现了技术成熟度与用户需求的平衡。统一API的自动路由方案在便捷性上占优,有利于推进行业普及和标准化建设,但可能在复杂场景下存在灵活性不足的瓶颈。而基于框架的自定义路由则能够满足多样化复杂需求,却要求开发者具备更深厚的技术积累。此外,LLM路由的发展还涉及多项关键技术。模型性能评估机制是基础,通过实时监控响应速度、准确率和上下文适应能力等指标,实现智能调度。再者,集成辅助工具如网络爬虫、搜索引擎及知识库的能力,可以丰富模型的输入信息,提高回答的时效性与准确性。

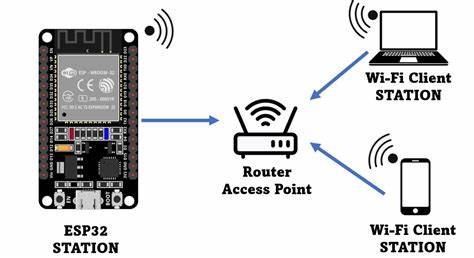

安全性和隐私保护亦不可忽视,特别是在数据敏感行业,如何确保调用过程中数据不被滥用,成为路由系统设计的重要考量。技术实现上,云端服务与本地部署的结合趋势逐渐明显。云端提供强大算力支持及模型更新迭代优势,本地部署则在数据安全和响应时间上具有优势。未来的LLM路由方案,可能更侧重于混合架构,灵活适配不同需求场景。此外,从商业应用角度,LLM路由能够极大提高多模型生态的协同效应,推动各类语言模型和平竞争、协作共进。平台可以通过路由集中管理不同供应商资源,实现资源利用最大化,减少重复开发,降低运营成本。

对于开发者而言,这种机制为构建跨模型、跨任务的智能应用提供了有力保障,助力实现多样化创新。尽管目前LLM路由仍处于萌芽阶段,但其市场潜力已被广泛看好。随着AI应用需求的不断深化,下游行业对定制化和高效调用的渴望愈加强烈,推动技术不断演进。可预见,未来的路由技术将在智能决策、自动优化及安全保护方面迈出更大步伐,赋能更广泛的应用场景。从技术生态角度出发,社区力量和开源项目的推动亦不可忽视。聚焦于模型互操作性、协议标准化以及开发者体验的改进,将促进LLM路由形成更健全、开放的生态体系。

参与者包括模型提供商、平台运营商、开发者及终端用户,协同创新将成为行业可持续发展的关键。总结来看,LLM路由技术代表了人工智能服务调用迈向智能化、多样化管理的重要一步。无论是希望快速集成的简单API方案,还是追求自由构建的AI SDK框架,都各有其市场定位和应用价值。未来路由技术的发展,将深刻影响AI应用的构建方式和行业格局。发展之路虽充满挑战,但也意味着巨大机遇,值得从业者、研究者及企业持续关注和积极投入。随着技术不断成熟,LLM路由或将助推大型语言模型在更多领域实现更智能、高效的应用,开启人工智能新时代的新篇章。

。