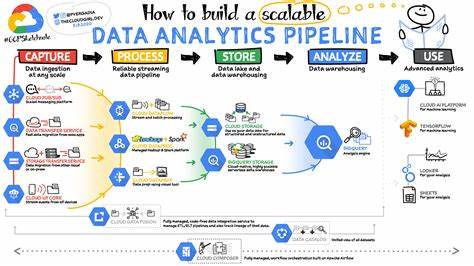

随着互联网用户规模爆炸式增长,游戏和社交平台面临的数据分析挑战也日益严峻。作为全球领先的多人在线游戏平台,Roblox每日需要处理高达2万亿条的分析事件数据,这一庞大的数据量对分析数据摄取基础设施提出了极高的性能、可扩展性和成本控制要求。为了满足这些需求,Roblox通过自主设计和迭代,构建了先进的分析事件摄取系统,不仅显著提升了数据处理速度和准确性,也为未来的实时应用奠定了坚实基础。本文将详细解析该系统的架构设计理念、技术选型、优化经验及未来展望,帮助读者理解如何搭建高效且可持续发展的大规模数据摄取平台。 Roblox的用户基础庞大,每天有近亿活跃用户在平台上交流创作和游戏互动,这些行为会产生海量的分析事件数据。过去,Roblox依赖云端队列服务将这些事件统一写入名为events_hourly的逻辑表中。

该表通过日期、小时以及若干自定义标签进行分区,但随着数据规模不断扩大,基于单表的批处理分析面临效率瓶颈,且服务延迟较高,最高达24小时的处理延迟极大影响了数据管道的实时性和可靠性。同时,单表多批处理的权限管理、数据保留策略和异常告警难度增加,事件的元信息缺失也导致数据追溯困难,带来了诸多负面影响。 为解决这些挑战,Roblox团队聚焦于消除传统批处理模式,打造实时、高效且低成本的事件摄取方案。重构后的方案基于定义良好的事件模式,实现了事件上游即确立结构化模式和目标存储表的设计理念。通过选用Google Protobuf作为事件的统一模式语言,Roblox不仅利用proto与gRPC在服务框架的天然协同性,还为事件元数据的管理提供了丰富的扩展空间,包括所有权、数据保留时长及事件历史追踪等多维度信息。在新体系中,事件需预先定义Schema,极大提升了数据的可用性和可维护性,降低了后续ETL开发的复杂度。

为了兼顾工程敏捷性与模式管理的规范性,Roblox构建了完整的Schema管理生态。中央Schema仓库配合自动化工具链,实现从Schema规则校验、格式转换到Hive表结构同步的全流程自动化。开发者仅需通过合并代码的方式完成Schema更新,系统自动检查是否符合公司规范,并生成相应的Hive数据定义语言,有效避免了数据不一致和因Schema错误带来的运行时异常。此外,为减少事件生产端的改动风险,摄取系统在后台完成事件的Proto序列化转换,采用Parquet格式存储并在分布式存储中管理,实现了数据格式和存储的统一标准。 成本优化方面,Roblox慎重考虑了消息队列服务的持续费用和性能瓶颈。传统云队列服务虽然提供了灵活的弹性扩展能力,但其昂贵的带宽成本和对多种流处理任务的不友好,限制了系统整体效率。

为此,Roblox引入了自行研发并内部托管的Queue-as-a-Service(QaaS)。该平台基于开源分布式事件流技术,支持按顺序保留事件,短期内自动删除,极大降低了存储和传输负担。通过为每个事件类型创建专属Topic并合理划分分区数,QaaS高效处理大规模事件流。配合同步生成Parquet文件的专用服务,Roblox实现了从事件落地到持久化存储的全链路优化,且系统经多月灰度试点,保证了数据完整性和系统稳定性。 这一系列改进使得Roblox的数据延迟大幅缩短,从原先的3小时服务级别协议(SLA)下降至平均仅需15分钟,显著提升了分析数据的时效性。同时,去除了传统云服务费用,且系统设计的扩展性极强,使平台能够轻松支撑每日2万亿事件的摄取需求。

基于此基础架构,Roblox将持续探索流计算服务,提供实时安全监控和个性化推荐功能,实现数据驱动的业务创新。 此外,Roblox还在不断完善事件的元数据管理,涵盖变更捕获机制(CDC)和事件监控能力。借助统一的Proto模式和QaaS管道,Roblox几乎消除了传统数据库全量导出过程,极大提高了数据同步效率和准确性。从实时分析、流处理到新业务场景的快速落地,Roblox的摄取基础设施正向更智能、高效和低成本的方向演进,成为行业内大规模分析系统建设的典范。 综上所述,Roblox通过明确的架构转型和底层技术创新,在保障海量用户数据高效、安全摄取的同时,实现了显著的运营成本优化和数据处理时延缩短。其采用Protobuf模式化事件设计、内部托管QaaS消息系统配合自动化Schema管理的策略,为大规模实时分析场景树立了标杆。

未来,随着技术的不断演进和业务需求的不断提升,Roblox在多团队协作、多数据源融合和智能实时分析方面将持续深耕,推动产业技术升级和数字化变革。对于寻求构建可扩展分析摄取基础设施的企业和开发者来说,Roblox的实践案例提供了宝贵的经验和启示。