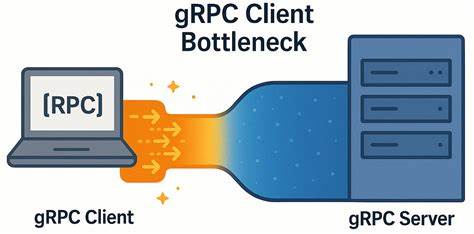

随着软件开发流程的不断演进,人工智能(AI)技术开始被深度整合至持续集成与持续交付(CI/CD)流水线,极大地提升了开发自动化与效率。以GitHub Actions为代表的平台,因其与GitHub生态的紧密结合,为AI编码代理提供了理想的运行环境,使得这些智能代理能够自动化生成代码、测试以及部署。然而,这种发展趋势也带来了不可忽视的安全隐患,成为攻击者设计新型攻击手段的温床。AI编码代理作为流水线中的活跃角色,其操控的权限和自动化决策链条增加了攻击面,并且传统的端点检测与响应(EDR)工具难以有效识别从AI代理发起的异常行为,造成了一道难以逾越的“可见性鸿沟”。AI编码代理不仅拥有读取仓库内容、分析拉取请求、自动创建分支和提交代码的能力,而且还可以通过GitHub API获得高级权限,例如使用GITHUB_TOKEN进行各种操作。攻击者能够通过恶意操纵代理的行为,使其生成潜藏恶意代码的拉取请求,或触发包含恶意逻辑的工作流执行,从而间接渗透到主分支代码库,引发供应链攻击风险。

传统安全工具主要依赖于已知威胁特征检测,面对利用合法GitHub资源发起的隐藏攻击束手无策。以近期的tj-actions案例为例,攻击者通过Github自有的可信域名下载恶意代码,绕过了传统的域名信誉检测机制。与此同时,安全产品未能识别出AI代理背后的执行语义与上下文,难以区分正常的编程辅助行为和恶意利用行为,导致安全防护存在盲点。除权限滥用外,AI代理生成的代码在流水线中自动执行且过程不透明,多数企业难以实时审查每一次代理的决策过程和运行时行为。这种“黑箱效应”扩大了潜在风险,攻击者可在无人察觉的情况下注入恶意代码,甚至通过代码片段中的细微信息触发钓鱼、权限提升或持久化攻击。为弥补这一可见性缺失,新一代安全解决方案开始强调实时监控和上下文感知,助力企业全面了解AI代理在CI/CD流水线中的细节行为。

像Harden-Runner这样的专用工具能够捕捉代理代码访问的文件、产生的进程及网络连接,并将每项行为与具体流水线步骤绑定,迅速识别异常事件并即时报警。通过行为基线分析与异常检测,有效防止代码和工件遭篡改、阻断未授权网络请求,提升整体安全态势。与此同时,加强代码审查流程、严格管理GitHub令牌权限和整合安全策略至流水线设计中,也成为遏制AI编码代理潜在威胁的关键举措。安全团队需与开发和运维紧密协作,推动文化变革,将安全意识贯穿于AI辅助开发的每个环节,避免机械信任AI生成的代码。未来,随着AI技术在软件开发中的深层次融合,对流水线安全的挑战将日益严峻。只有借助具备CI/CD感知能力和高度自动化特征的安全防护体系,企业才能在享受AI带来生产力提升的同时,有效防范新兴攻击手段的威胁。

加强对AI编码代理的行为监控和权限管理,完善运行时安全检测,是塑造安全可靠的AI驱动软件开发生态的必由之路。诠释AI与软件安全协同发展,在保障源代码供应链完整性和系统可信度方面发挥着不可替代的作用,助力企业构建面向未来的安全防线。