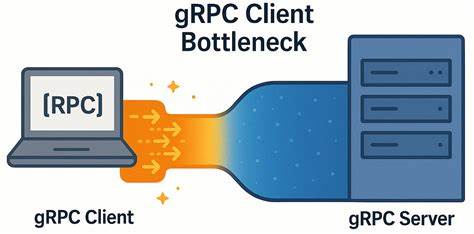

随着分布式系统和微服务架构的广泛应用,gRPC作为一种高性能的远程过程调用框架,越来越多地被选用来实现服务之间的通信。gRPC基于HTTP/2协议,在设计上支持多路复用、流控和二进制数据传输,被普遍认为是一套高效且稳健的通信解决方案。然而,在实际部署和测试过程中,YDB数据库团队意外发现,在低延迟的高速网络环境下,gRPC客户端却暴露出无法忽视的性能瓶颈,严重影响负载分布和查询响应速度。本文将揭示这一令人惊讶的客户端瓶颈现象,并分享经过深入研究、实验验证后得出的优化方案,旨在帮助相关技术人员更好理解gRPC性能特点及规避潜在问题。gRPC的架构和底层机制揭示了瓶颈根源gRPC的设计允许客户端创建多个通道(Channel),每个通道支持若干个RPC请求,这些请求在单个HTTP/2连接中被多路复用。理论上,HTTP/2的多路复用机制能够极大地提升连接复用率,减少网络开销,并支持大量并发请求。

按gRPC官方最佳实践,通道的数量与连接资源应该根据负载合理分配。官方文档中建议,在高并发场景或者长连接流式RPC的情况下,要么为不同的热点负载区域单独创建通道,要么对通道进行池化管理以避免RPC请求在连接上的排队现象。YDB团队的研究发现,在他们使用默认参数的情况下,多条gRPC通道意外共享了同一条TCP连接,导致大量并发请求被限制在单个连接的最大并发流数(默认100)以内,形成了客户端的吞吐瓶颈。更关键的是,网络质量极为优越,带宽高达50Gbps,往返时延仅有几十微秒,但客户端请求的响应时间却远超预期,这一现象将注意力直接指向了gRPC客户端内部的调度与资源争用。深入测试:微基准实验揭示性能瓶颈为了精准定位问题,开发团队设计了一个轻量级的gRPC ping微基准程序,利用最新gRPC版本同时支持C++和Java客户端,并在物理隔离的两台具备高性能计算能力的服务器之间运行。通过调整客户端worker数和每个worker的并发请求数,能完整模拟多种高并发传输场景。

实验结果令人吃惊,单连接情况下,尽管提升并发请求数,系统整体吞吐增长远低于线性预期,延迟随负载激增以千万分之一秒计量,而且不同worker之间的请求响应几乎被序列化,显示出严重的客户端排队和延迟积累。另一方面,网络层面诊断证实TCP连接没有发生拥塞,关闭Nagle算法避免了发送延迟,且往返时延和丢包率均保持极低,完整排除了网络中断和带宽限制的可能。这些迹象表明,瓶颈源自gRPC客户端的流量调度机制及连接管理逻辑,而非物理网络限制。突破瓶颈:分离通道与本地子通道池优化方案为突破客户端瓶颈,YDB团队尝试两种思路。第一种是为每个worker创建独立的gRPC通道,且保证这些通道具有不同的配置参数,迫使gRPC底层建立独立TCP连接,从而绕开单连接流并发受限问题。第二种是在客户端启用GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL参数,允许底层为每个通道使用本地的子通道池,实现通道到连接的更灵活映射,避免请求在单一连接内排队。

测试表明,这两种做法本质上是同一策略的不同切入点,即通过多连接分发RPC压力,显著提升了系统的并发处理能力和吞吐量。优化后吞吐率提升了约6倍,响应延迟增长大幅放缓,表现更接近网络物理极限。不同网络延迟条件的表现差异值得关注在进一步测试中,YDB团队将同一基准程序部署于模拟5000微秒延迟的网络环境,该环境远高于原本微秒级的网络时延。此时,无论是否启用多连接优化,客户端性能表现差异不大,说明在高延迟网络中,网络本身的时延成为主导因素,gRPC客户端的瓶颈对整体性能影响较小。该对比揭示出,客户端瓶颈尤为显著于超低延迟、高带宽的网络环境,这与云内网或数据中心内互联环境高度吻合。应用启示与实践建议gRPC的多路复用设计为跨网络远程调用提供了弹性和便利,但在极端性能要求和细粒度延迟控制的应用场景中,默认的连接复用可能限制系统扩展性。

基于YDB团队的发现,开发者应关注客户端的通道管理策略,特别是在性能敏感的数据库、实时系统及大规模微服务通信中,合理拆分或池化通道,确保每个通道对应独立连接,可有效规避流控和队列引发的额外延迟。此外,线程亲和性和NUMA节点绑定等系统级调优同样不可忽视,这些底层细节对性能表现有实质性影响。社区和未来发展趋势值得期待的方面是,gRPC及HTTP/2协议自身仍在持续演进,未来优化可能涉及增加更灵活的流调度机制,或引入QUIC协议以替代TCP,进一步减少连接管理开销。此外,面向云环境的服务网格和Sidecar代理的发展,也可能影响应用层和传输层的性能协作。研究者和开发者可以借助此类微基准工具,深入测试并个性化优化自身系统,推动gRPC的广泛适用和性能极限。总结gRPC作为现代分布式通信的重要技术,具备高性能和灵活性优势,但其客户端实现细节隐藏的性能瓶颈不容忽视。

YDB团队通过系统的基准测试发现,默认多路复用模式下单连接多流限制可能导致客户端吞吐受限和延迟攀升。在极低延迟网络里,这一问题尤为突出。通过采取为每个工作线程分配独立通道并启用本地子通道池选项,有效绕开TCP连接瓶颈,极大提升了系统整体性能。这一实践经验为使用gRPC的大规模分布式系统开发提供了宝贵的参考,有助于构建更高效、低延迟的RPC通信架构。希望更多开发者能够关注细节,结合自身需求深度调优,充分发挥gRPC的技术潜力。