随着人工智能和自然语言处理技术的迅猛发展,文本嵌入技术在搜索引擎、推荐系统、语义匹配等领域扮演着不可或缺的角色。Sentence-Transformers作为一种将句子和文本片段映射到高维向量空间的重要工具,近年来广受关注。虽然Python生态中Sentence-Transformers库已相对成熟,但Rust作为系统级编程语言,以其高性能和安全性优势正在吸引更多开发者的目光。本文将深入探讨Rust语言中基于Candle框架的Sentence-Transformers实现,帮助读者全面了解其架构、支持的模型以及使用场景。 Sentence-Transformers库的核心目标是将文本转换为向量表示,使得语义相似度计算更加高效和准确。Rust语言的高性能特性尤其适合这一计算密集型任务,而Candle框架则承担起深度学习推理和张量运算的基石作用。

这种结合不仅提升了运算速度,还保证了更低的资源消耗和更强的系统稳定性。 目前,该Rust实现已内置支持多款主流的预训练模型,包括 sentence-transformers/all-MiniLM-L6-v2、sentence-transformers/all-mpnet-base-v2、sentence-transformers/paraphrase-multilingual-MiniLM-L12-v2 以及 intfloat/multilingual-e5-large 等。这些模型涵盖了多语言、多语义表示和多任务适应能力,能够满足大多数文本嵌入场景需求。借助统一API,开发者可以轻松调用预训练模型进行推断,无需关心底层复杂细节。 在Rust环境中使用该库的过程简洁且灵活。开发者首先需要选择合适的设备环境,如支持CUDA的GPU或者通用CPU。

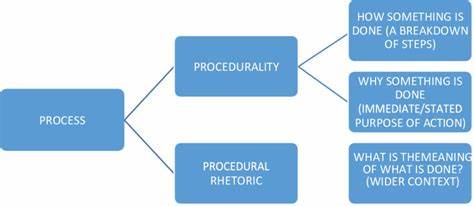

通过 SentenceTransformerBuilder 构建模型时,可以指定模型名称、批量大小、设备类型等参数,同时还支持加载safetensors格式的模型文件,这在提升加载效率和内存安全方面尤为重要。完成模型构建后,调用 embed 方法即可获得给定句子的向量表示。 随后,利用utils模块中的余弦相似度计算函数,用户能够迅速得到两段文本的相似度分数,帮助实现文本聚类、语义匹配和搜索增强等功能。这样的操作简化了机器学习模型集成的门槛,为业务线开发提供了极大便利。 除了上述默认支持的模型,Rust库还允许用户加载基于BertModel、XLMRobertaModel、DistilBertModel或MPNetModel架构的自定义模型。通过灵活配置池化层、归一化方式及密集层等模块,开发者可以根据业务需求微调模型细节,进一步优化文本表示效果。

作为一款开源项目,该库计划未来支持更多主流模型架构,如T5EncoderModel、RobertaModel、AlbertModel等。这些扩展将极大丰富Rust语言在自然语言处理领域的生态,推动更多高性能文本理解应用的诞生。从长远来看,Rust版Sentence-Transformers结合Candle框架或将成为构建轻量级、易扩展、适用多场景文本表示工具的重要选择。 除技术优势外,Rust语言因其内存安全、并发友好等特质,天然适合部署在复杂生产环境。结合Candle的计算加速能力,使推理部署更具可靠性与效率。相较传统Python实现,Rust提供了更低延迟和更高吞吐量,显著提升了资源利用率和服务性能。

开发者在实际应用时,还需关注模型选择与适配,确保所用模型与文本数据分布相符,以发挥最大性能。此外,由于Rust生态仍在快速发展,社区贡献者不断优化代码库,完善功能。因此保持关注项目动态,有助于获取最新特性和最佳实践。 总结来说,Rust语言在文本嵌入领域的崭新尝试,通过Sentence-Transformers和Candle框架的有机结合,实现了高效、灵活且可扩展的解决方案。它不仅弥补了Python等传统方案在性能和安全上的不足,还为开发者提供了丰富的模型支持和友好的使用体验。随着生态不断完善,Rust版Sentence-Transformers无疑将在自然语言处理领域展现更广阔的应用前景和商业价值。

。