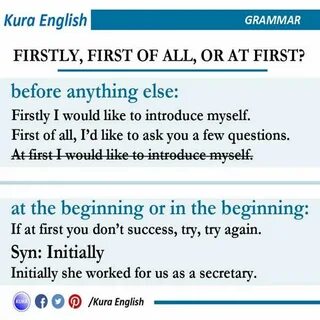

在许多数据库管理操作中,修改表结构是经常执行的任务之一,其中添加和删除列十分常见。尤其是在Postgres数据库中,这些操作看似简单,但如果重复进行,比如多达2000次,将会产生意想不到的问题与限制。理解这些背后的工作机制,对于保证数据库性能、避免结构限制以及确保合规性具有重要意义。 起初,我们可能会认为,添加一列然后立刻删除它,若持续2000次,最终表结构仍应回到最初状态。换句话说,原本两列的表,经过如此频繁的操作后,依然只有这两列。然而事实与预期背道而驰,执行过程中竟然出现了表列数超过限制的错误,提示“表最多只能有1600列”——而实际上,我们的表列数远远没有达到这个上限,这一结果令人疑惑。

这种现象的根源在于Postgres的列删除机制。在许多关系型数据库系统中,删除列意味着数据和元数据的彻底清理,而Postgres采用了更加高效且避免全表重新写入的方法。为了提高操作效率,Postgres并不立即物理删除被删除列的数据,而是采用标记方式,将列的状态置为“已删除”(dropped)。此时数据依然存在于磁盘文件中,但数据库引擎在执行查询和操作时会忽略这些被标记为删除的列。 数据文件在Postgres中以页(默认大小8KB)为单位存储,每个页包含若干行以及相应的元数据。当删除列时,如果真的物理删除该列,数据库需要遍历所有页中所有行的数据,这将是一项极其耗时且资源密集的操作。

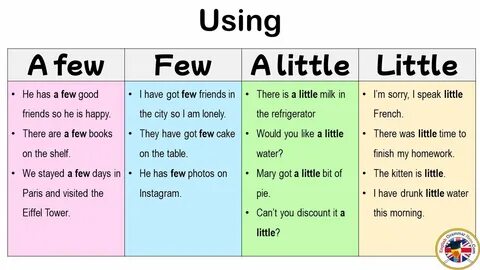

为了避免这种昂贵的代价,Postgres采取“懒删除”策略,仅在系统元数据中将列标记为已删除,数据块依旧保留原状。 通过查询系统目录表pg_attribute,我们可以清楚地看到那些被删除但数据仍存的列。表中对应的列的attisdropped字段被设置为真(t),且该列名称被替换为伪名,比如“........pg.dropped.2........”,表示该列为删除状态,但尚未物理清理。查询和插入操作将忽略它们,但它们依然占据列编号和数据库的列数限制。 多次重复添加和删除列后,虽然表结构中只有少量的“活跃”列,但系统内部实际上存在大量“已删除”的虚拟列,这些已删除列仍被计入总列数之中。Postgres对每个表的列数有限制,最大值为1600列,当总列数加上这些已被标记但未清理的列数超过限制时,系统会拒绝继续添加新列,抛出错误。

这种机制虽然保证了结构修改的效率,但也带来了管理上的隐患。被无限制地积累的已删除列会造成表结构“臃肿”,影响数据库维护和扩展能力。此时清理这些已删除列的数据成为必须。 执行VACUUM FULL操作是Postgres中清理已删除列的主要方式之一。VACUUM FULL不仅回收死行,重新整理存储空间,还会彻底重写整个表,将那些标记为已删除的列真正移除,使表结构和数据文件回归干净状态。尽管如此,VACUUM FULL并不会改变pg_attribute中列的存在状态(依然显示已删除列),但它会清理物理数据占用,大幅度降低文件大小。

在重要的结构维护阶段,这一步骤不可或缺。 对于一些复杂的表结构,如果VACUUM FULL不能满足需求,开发者可通过新建表并从旧表中选择需要的列复制数据的方式,实现彻底的结构重建。此类方法灵活,但实施相对复杂,尤其涉及索引、约束、外键及触发器等相关对象时,需谨慎处理,确保相关约束及业务逻辑完整迁移。 除了对数据库性能和结构的影响外,重复添加和删除列还带来数据合规性方面的思考。部分开发者关心GDPR中“被遗忘权”的实现,担忧旧列数据即使标记为删除,也可能残留在系统中,无法从物理层彻底抹除。实际上,这种担忧过于夸大了问题。

在数据库中,个人数据根据设计通常以行而非列为单位管理和删除。满足删除请求的关键是删除包含个人数据的行,而非简单地删除列。即使Postgres的MVCC模型导致删除的行不会立即被物理清理,只要经过合适的真空操作,数据会随着时间被回收处理。同时,磁盘级别的数据清理如覆盖或销毁,属于更高级的系统管理范畴,数据库操作本身不能独立完成所有合规要求。 此外,考虑备份、复制及存储层面的数据残留,也是确保数据合规的必要环节。企业需要将数据库删除、真空、备份策略和物理存储安全结合起来,构成合理有效的数据保护和隐私合规体系。

仅依赖数据库架构层面的列删除,不足以满足法规中的深度数据清理需求。 通过对Postgres添加与删除列2000次的实验和解析,可进一步认知数据库结构变更对系统的潜在影响和限制。对于架构设计者、数据库管理员以及开发者而言,理解这一流程有助于合理规划表结构变更频率,避免不必要的性能损耗和结构臃肿。同时,可及时应用VACUUM FULL等维护机制,防止因积累大量已删除列而触发系统限制。 总结而言,Postgres在处理删除列时采取了高效但复杂的标记策略,以平衡性能和操作代价,但也带来了列数量增长和物理文件不清理的副作用。面对高频率的添加删除操作,数据库管理员应保持警觉,利用提供的重写工具维护表健康,确保数据库在结构变化频繁的环境下依旧稳定和高效运行。

理解此机制也有助于正确评估数据隐私法规中的数据删除需求,从容应对合规压力,构筑科学合理的数据管理流程。