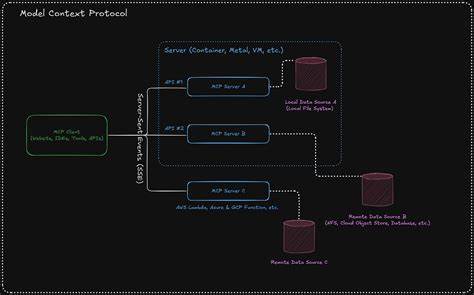

随着人工智能技术的迅猛发展,如何让AI智能体更便捷地调用多种工具成为开发者关注的焦点。Model Context Protocol(简称MCP)正是在此背景下诞生的一种通用协议,旨在为AI智能体暴露一组预定义工具,简化工具调用流程,提升智能体的工作效率。本文将深入介绍MCP的基本原理、实际使用方法及开发过程中应注意的重点,帮助读者理清如何高效接入MCP服务器,打造功能强大的AI工具。MCP的核心理念是统一管理和调用多个工具,不再需要针对每个独立工具单独编写调用逻辑,而是通过“握手”与服务器建立连接后,自动获取工具列表,转换成模型推理所需格式,进而让模型能够自由调用这些工具,极大地简化了AI与外部服务的集成。使用MCP的第一步是通过官方或自定义的MCP服务器完成握手过程。在代码实现中,开发者通常会使用相应的SDK或HTTP传输客户端,向服务器发送带有身份验证(如Token)的请求。

以GitHub MCP服务器为例,该过程包括创建传输客户端,设置请求头中的授权信息,随后建立连接并调用listTools接口获取所有可用工具。取得工具列表后,需要将来自MCP的工具描述转换成所用LLM推理框架所支持的工具格式,这样模型在推理时才能正确识别和调用这些功能。转换时,必须兼顾工具的名称、描述以及输入参数结构,确保语义明确且符合推理API的规范。完成工具准备后,开发者即可进入推理调用阶段。整体流程采用循环调用机制,模型根据输入提示与上下文生成回复。如果模型请求调用工具(通过特定字段如tool_calls表现),程序调用对应MCP工具执行操作,并将结果回传给模型,模型据此继续做出更精准的推断。

该机制体现了agentic推理模式,即模型与工具交互形成闭环,持续迭代直至获得最终答案或满足终止条件。虽然看似简单,MCP的实操中存在一些挑战。服务器连接的效率和稳定性需要保障,循环调用时要限制最大迭代次数以防死循环。此外,安全性尤为重要,切忌采用权限过高的Token,避免外部操作者滥用工具权限引发风险。采用多用户分级授权是常见策略,确保每个用户仅能调用其权限范围内的MCP工具。值得一提的是,目前MCP的生态和开发工具仍在成长阶段,尚未实现完全即插即用的无缝集成接口。

开发者需理解MCP协议的设计理念,手工实现客户端逻辑与推理API的对接,方能最大限度发挥MCP的优势。代码示例清晰展示了如何在GitHub Actions环境中以TypeScript实现上述流程,包含初始化MCP客户端、请求工具列表和多轮推理循环调用工具,极具参考价值。未来,随着标准完善以及工具链丰富,MCP有望成为连接多种服务与AI模型的关键中间件,使智能助理能够更灵活高效地完成复杂任务。总而言之,Model Context Protocol带来了AI技术与多工具协同工作的全新范式。掌握其接入流程与核心实现细节是开发现代智能Agent的关键。通过理解握手连接、工具格式转换、循环推理调用的原理,开发者可设计出支持多工具交互的智能系统,有效提升自动化程度与任务完成质量。

部署MCP时务必重视安全策略,防范权限滥用风险。在此基础上,结合具体应用场景和业务需求,不断迭代优化,方能最大化发挥MCP的巨大潜力,为AI赋能开辟更广阔的道路。随着更多开发者和平台加入,MCP生态将更加成熟多样,推动AI从单一工具调用走向多功能复合智能协作新时代。期待在不远的将来,Model Context Protocol能成为AI工具集成的行业标准,为智能化创新注入强劲动力。