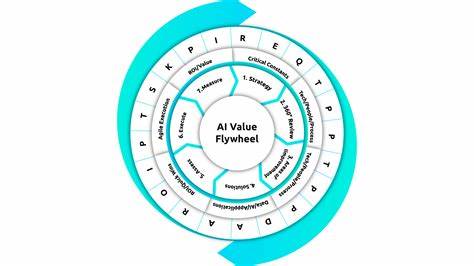

随着人工智能技术的迅猛发展,AI功能的开发和优化已成为科技公司竞争的关键领域。如何科学有效地评估AI模型的表现成为行业关注的焦点,而“AI评估飞轮”作为一种系统化的办法,为AI特性的持续改进提供了坚实基础。本文将详细解析这一飞轮中的核心元素——评分系统、数据集管理、生产环境的实际应用以及快速迭代过程,带领读者全面理解AI功能开发背后的技术逻辑与实践智慧。 传统的AI功能开发过程中,没有标准化的评估机制,开发者往往凭借直觉和少量的测试样例来判断模型的优劣。这样的方式虽然在早期验证想法时具有一定灵活性,但面对从模型更新到边界情况不断涌现的复杂局面,显得尤为力不从心。尤其是非确定性系统输出多变,很难通过简单的人工体验来维持评估的准确性和连贯性。

因此,依靠系统化的“评估(eval)”机制,能够将开发工作从“随感觉试探”转变为“数据驱动、结构化”的科学管理。 “评估”在AI特性开发中分为大E和小e两种含义。小e是指对单次模型输出结果的系统性评分,评分标准往往基于多个特征指标的加权汇总,从而对结果进行量化判定。大E则涵盖了整体评估流程,涉及输入数据的组织、评分器的设定、结合生产实际使用情况的反馈采集,以及基于这一系列数据进行的功能迭代和优化。大E体现了评估作为持续改进驱动力的全貌。 在评分体系设计方面,业界领先企业如谷歌展现了深厚的经验积累。

谷歌对搜索结果的质量评估涉及300多个具体信号,包括页面速度、外链权重、内容质量、页面设计以及对查询意图的贴合度等多维度因素。这些信号由代码自动检测或者由基于大语言模型(LLM)的智能评分器辅助评定,最终通过加权求和生成单个结果分值,从而指导搜索结果排序。这种分解信号、自动评审的模式被许多科技公司模仿,并拓展到更广泛的AI产品评估环节。 当前的AI评估面临独特的挑战,因为模型响应具有一定的随机性和多样性,这需要评估机制能够兼顾准确和灵活。为此,通常采用两种评分方法相结合的思路:代码驱动的硬指标评分和LLM判断的软性评分。代码驱动适合那些明确、可度量的属性,如格式正确性、响应时间等;而LLM评判则适用于自然语言质量、表达风格等更主观、更复杂的维度。

结合这两者能够构建多维且科学的评分体系,帮助开发团队在自动化环境下实现对模型输出更精细的把控。 评分器的效果如何验证也是评估体系的重要环节。业界普遍做法是通过专业人工评审样本作为“金标准”,开发人员基于这些专家评定的结果,调整和优化自动评分系统,这也形成了评估的迭代过程——“对评估的评估”。这一过程确保评分体系与人类主观判断保持高度一致,从而提升自动评估的可信度和实用性。 输入数据的管理同样是AI评估飞轮中不可或缺的一环。设计良好的数据集能够充分反映功能覆盖的广度和难度,帮助模型在多样场景中表现稳定。

一般来说,数据集分为人工精选和合成生成两大类。人工精选数据集由团队精心挑选,涵盖基础用例、边缘难题以及未来期望达成的高难度用例,确保覆盖不同层次的测试需求。合成数据集则借助大型语言模型生成示例,可以基于信号评分标准生成合格或不合格的样本,提升测试的广度和针对性。 评估的应用场景分为离线和在线两种模式。离线评估主要用于开发阶段,团队使用预先构建的数据集对模型功能进行验证和优化。而在线评估更强调实时性和反馈,直接利用生产环境中的用户输入作为测试样本。

在线评估具有不可替代的优势,因为它能够反映模型在真实场景下的运行表现,帮助及时捕捉模型回退和潜在缺陷。 在线评估的价值还体现在对用户行为的深度挖掘上。除了明确的用户反馈(如点赞或点踩),隐含的行为信号如内容保存、复制、分享或使用频率的变化,同样是评价模型表现的重要维度。这些反馈不仅验证了评估体系的有效性,同时也为未来数据集的完善和评估标准的丰富提供了真实依据。 快速迭代是AI评估飞轮最终追求的核心目标。基于结构化的输入和输出评估,结合用户反馈形成闭环,开发团队可以实现无缝的循环更新。

快速、多次迭代能够显著提升AI功能的精准度和用户满意度,实现功能的持续进化。为降低迭代的技术门槛,各大厂商和服务平台逐渐提供专门的沙盒环境或“游乐场”,让开发者无需复杂代码修改即可调整模型参数、替换服务提供商或优化提示语,极大地加快了实验效率。 综上所述,AI评估飞轮从评分系统的多信号解构,到数据集的科学管理,再到生产环境中在线评估的实时反馈以及快速迭代的高效闭环,共同形成了现代AI开发的标杆流程。这不仅使机器人学习和人机交互更加精准,也推动了整个AI应用生态的成熟和繁荣。面向未来,随着评估工具的智能化升级和自动化程度提升,AI评估飞轮必将在更多细分领域发挥巨大价值,助力企业在激烈的市场竞争中赢得先机。