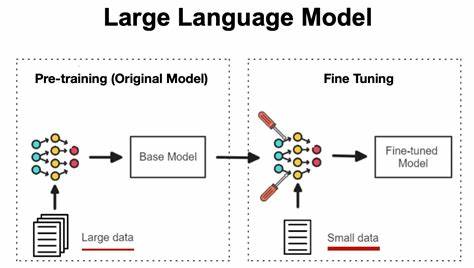

在人工智能领域,Transformer模型凭借强大的表现能力,成为自然语言处理和生成的主流选择。然而,如何有效且高效地对这些模型进行微调,成为众多开发者面临的挑战。传统微调流程繁琐,代码冗长,且对新手并不友好。针对这一痛点,Python生态中涌现出一款名为Tuna的开源库,专注于简化Transformer模型的微调流程。通过少量代码和丰富功能,Tuna让复杂的训练过程变得轻松,从而极大地缩短了项目开发周期。本文将详细介绍Tuna的核心价值、功能特点以及实际应用方法,带你深入了解如何利用这款工具高效完成模型微调。

传统Transformer微调流程通常需要开发者编写数十行甚至上百行代码,涵盖模型加载、数据预处理、训练参数配置及训练循环等多个环节。许多步骤不仅重复且复杂,尤其是对于包含LoRA(低秩适配)、P-tuning(提示调优)等先进微调技术时,更显繁琐。针对该状况,Tuna以先进的架构设计,抽象封装了各类流程,用户只需调用简单接口,即可完成复杂微调任务,显著降低了上手门槛和开发成本。 Tuna的最大特色之一是支持多种微调方式,包括LoRA、监督微调(Supervised Fine-Tuning)、提示调优(P-tuning)以及领域自适应微调(Domain-Adaptive Fine-Tuning, DAFT)等。LoRA作为当前最热门的参数高效调整技术,允许用户通过调整模型较小的子空间,减少显存占用,同时保持优秀性能。利用Tuna,用户可以轻松配置LoRA相关参数,无需关注细节,只需传递简单字典形式的参数,几行代码即可实现微调。

P-tuning为少样本学习场景提供强力支持,能够快速适配新任务。DAFT则方便开发者针对特定领域数据,如医疗、金融领域的专业文本,快速进行定制化训练,提升模型的领域表现。 与传统方法相比,Tuna的另一个优势是具备链式调优能力。也就是说,用户可以灵活组合多种微调方法,先利用LoRA进行低成本微调,再基于该模型进行全参数的监督微调,最终形成性能卓越的复合模型。此设计不仅提升了调优效率,也满足了复杂应用场景中对模型质量的高要求。通过内置的智能加载与检查点管理,用户不用担心训练中断或数据丢失,自动保存机制确保进度稳定持续。

除了多样的功能支持,Tuna还特别注重用户体验。整个系统采用极简API设计,避免了繁琐的配置细节。对于模型和数据的加载,Tuna自动处理Tokenizer的填充标记设置,兼容各种数据格式,开发者只需关注业务逻辑。另外,内置的日志模块可对训练过程进行详细跟踪,方便调试和优化。配合Python 3.8以上版本及主流深度学习框架PyTorch和Transformers,保证了工具运行的稳定性和扩展性。 具体使用上,Tuna显著缩短了从数据准备到模型训练的代码量。

举例来说,传统使用Transformers与PEFT(参数高效微调库)耗费50多行代码才能启动训练,而Tuna仅用几行代码就能完成相同操作。用户只需定义基础模型名称,传入数据集及训练参数,就能一键启动微调流程,大大降低学习成本和失误风险。针对需要灵活调参的用户,Tuna支持通过简单的字典参数进行全面配置,满足不同训练需求。 Tuna的开源性质及活跃社区也为其发展提供了强大助力。开发团队不断迭代更新,计划逐步支持更多微调技术与模型类型。社区贡献的代码和文档,使得工具生态丰富,使用场景不断扩展。

用户可以方便地参与源码提交,提出改进建议,推动功能完善。未来Tuna有望成为Transformer微调领域的标准库,推动人工智能技术更快普及。 从应用角度看,Tuna适合科研人员、AI工程师以及创业团队使用,无论是快速验证模型效果,还是针对实际业务部署定制模型,都能发挥巨大优势。在聊天机器人、文本摘要、内容生成等多个NLP任务中,借助Tuna的高效微调能力,模型可更好地满足特定场景需求,提升用户体验和系统性能。尤其是在资源有限环境下,LoRA等技术结合Tuna的易用性,为开发者提供了理想的解决方案。 未来,随着大型语言模型规模不断增长,传统全模型微调的成本和时间压力日益突出。

像Tuna这样专注于简化微调流程的工具将扮演关键角色。它不仅降低了微调门槛,还通过支持多种优化方法,实现灵活组合训练,协助开发者打造高效、精准的AI系统。此外,Tuna计划支持更多优化算法、自动调参和多阶段训练功能,将持续引领微调技术创新。 总结来说,Tuna作为一款开源的Python库,以简洁的代码、强大的适配能力和灵活的配置框架,为Transformer模型的微调注入了新活力。它解决了传统训练流程中的复杂与低效,让开发者能够专注于模型表现的提升,而不是繁琐的实现细节。随着社区不断壮大和功能拓展,Tuna势必成为人工智能开发者提升生产力的重要利器。

无论是初学者还是资深专家,借助Tuna都能轻松驾驭复杂的Transformer微调,快速构建更智能的AI应用,推动产业智能化升级。