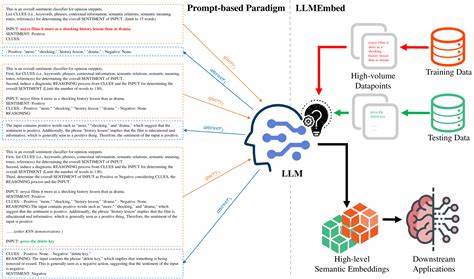

随着人工智能技术的快速发展,文本分类作为自然语言处理中的基础任务,应用范围日益广泛,从客户反馈分析到社交媒体监控,再到智能助手的语言理解,文本分类技术的重要性不言而喻。然而,传统的文本分类模型通常依赖大量标注数据和强大的计算资源,这在数据隐私、成本预算以及边缘设备部署方面都带来了诸多挑战。WhiteLightning项目应运而生,为文本分类带来了革命性的解决方案,让人工智能的普及更加便捷与高效。 WhiteLightning是一个超轻量级的文本分类器训练框架,其核心创新点在于不依赖真实的训练数据,而是通过调用大型语言模型(LLMs)自动生成合成训练数据,然后利用这些数据快速训练占用资源极低的ONNX格式模型。这样的设计使得用户无需担忧数据隐私问题,也无需花费大量时间收集和标注数据,极大降低了文本分类模型开发的门槛。用户仅需一条命令即可自动完成数据生成、模型训练与导出,方便快捷,适合各种技术背景的开发者使用。

ONNX格式是当前业界标准的高效模型交换格式,具备跨平台性和高兼容性。WhiteLightning训练出的模型体积小巧,能够在无GPU的环境下实现高速推理,完美契合资源受限的边缘设备需求。无论是老旧笔记本、树莓派,甚至是性能极低的微控制器,都能流畅运行这些模型,为边缘AI的落地提供了坚实技术保障。 在使用WhiteLightning时,用户只需指定分类任务和类别标签,系统便会调用配置的LLM,如OpenAI的GPT-4-mini版本,自动生成目标领域的合成训练样本。模型训练过程集成了先进的TensorFlow策略,经过多轮优化后,模型精准度可以达到几乎完美的水平。训练完成的模型被导出为ONNX格式,用户随时可以在本地部署,无需依赖云端API服务,避免了高昂的API调用费用和潜在的隐私泄露风险。

WhiteLightning的最大优势在于“无数据训练”的理念。现实应用中,数据获取常受限制,尤其是涉及用户隐私的领域。借助LLM作为数据合成引擎,WhiteLightning无疑为企业和开发者提供了突破传统数据瓶颈的新思路。在数据稀缺或敏感场景下,依然能够开发功能强大的文本分类器,助力智能决策和自动化处理,提高业务效率。 此外,WhiteLightning强调完全控制数据权属和使用方式,没有任何隐蔽的遥测或外部依赖,保证用户数据始终只在设备本地流转。没有供应商绑定,也意味着模型可长期维护和迭代,避免被单一生态锁死,为企业级应用提供了灵活的部署方案和安全保障。

技术实现方面,WhiteLightning采用了多阶段的自动化流程,首先基于用户提供的分类描述,生成边缘案例和核心样本,从而覆盖任务中可能遇到的复杂语义和极端情境。接着,利用这些合成数据进行迭代训练,逐步提升模型的泛化能力。整个过程高度自动化,无需人工干预即可完成,极大提升了开发效率。 WhiteLightning不仅适合传统文本分类场景,例如情感分析、话题分类、垃圾邮件过滤等,也为新兴的物联网和嵌入式设备打开了智能化应用的大门。越来越多的智能终端需要即时处理文本信息,但硬件性能和网络环境有限,WhiteLightning的轻量与高效特性为其赋能,推动边缘计算在实际应用中的落地。 总体来看,WhiteLightning项目代表了未来AI模型训练与部署的重要发展方向。

通过融合大型语言模型的数据生成能力与ONNX高效推理框架,实现了从无数据到模型部署的一站式流程,显著降低了技术门槛和成本。在追求隐私保护、高度可控和普适部署的时代背景下,这种创新的文本分类解决方案无疑具备广阔的应用前景和市场潜力。 未来,随着大型语言模型的不断演进和硬件算力的提升,WhiteLightning有望支持更多复杂的文本处理任务和更丰富的模型结构,进一步推动AI向边缘智能的深度渗透。同时,社区生态和开源力量的积极参与也将催生更多个性化和行业定制化的解决方案,拓展WhiteLightning的应用边界。 对于开发者和企业来说,WhiteLightning不仅仅是一个工具,更是打造自主智能数据处理能力的重要途径。拥抱这样的技术变革,意味着拥抱更加高效、隐私、安全和普适的人工智能未来。

现在便可以通过简单的命令行启动,从零开始创造专属于自己的文本分类模型,体验尖端AI技术带来的便捷与强大。 在全球数据隐私法规日益严格、边缘计算日渐普及的趋势下,WhiteLightning的出现恰逢其时。它将改变我们构建和部署AI模型的方式,让人工智能真正成为人人可用、随时可用的生产力工具。无论是科技爱好者、创业公司,还是大型企业,WhiteLightning都提供了强大且灵活的解决方案,开启边缘AI应用的新纪元。