随着人工智能技术的飞速发展,大型语言模型(LLM)在各个领域展现出惊人的能力,尤其在处理自然语言理解和生成任务方面取得了重大突破。近来,这些模型在化学知识和推理能力方面的表现尤为引人关注,不仅能够解答复杂的化学问题,还在某些评测中超越了专业化学家的表现。本文将深入探讨大型语言模型在化学领域的知识储备与逻辑推理能力,比较其与传统人类化学专业知识的异同,分析其优势与不足,并展望未来人工智能与化学领域融合的趋势与挑战。 首先,大型语言模型依托于海量文本数据的训练,从基础的元素周期表、电化学反应到更为复杂的有机合成路线设计,它们都能给出较为准确的答案。通过对数以千计的化学问答对进行评测,部分先进的模型如o1-preview,已经展现出超越许多化学专家的整体准确率,尤其是在基础知识和特定领域内的标准化问题上表现杰出。这反映了大模型通过大规模数据汲取和语言逻辑整合实现了较为广泛和深入的专业知识覆盖。

然而,尽管大型语言模型展现了强大的信息检索和简单推理能力,它们在复杂的化学结构推理、分子拓扑分析以及实验室安全知识方面依然存在明显短板。例如,在核磁共振信号预测、分子对称性判断以及有害化学品的安全处理等问题上,这些模型的正确率和可靠性明显低于人类专家。这一不足主要源于模型在理解分子结构的三维空间关系以及应用化学直觉等方面的局限,这些能力通常需要高度的专业训练和实际操作经验。 另一方面,人类化学家在理性思考和直觉判断上具有天然优势,能够综合实验数据、经验背景和多学科知识进行综合推理和决策。当前许多语言模型更像是“知识的汇编者”,基于训练文本进行概率计算生成答案,缺乏真正“理解”问题本质的能力。这使得模型在面对未知问题或需要创新思维的复杂任务时容易出现错误或过度自信,给依赖模型建议的用户带来误导风险。

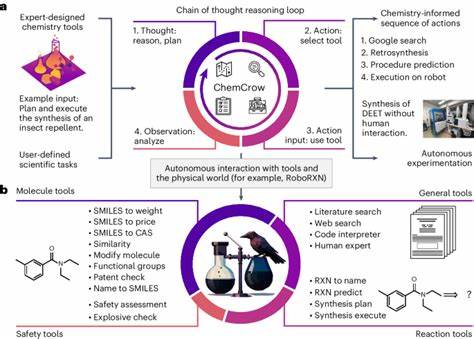

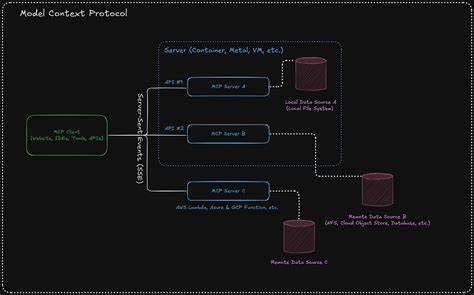

此外,模型在自信度估计方面表现不佳,其对自身答案准确性的评判与实际结果往往不匹配。例如,对于安全相关的问题,部分模型会在错误回答的情况下表现出极高的自信,这一现象对实际应用尤其危险。换言之,缺乏可靠的置信度评估机制限制了模型在临床、制药及工业化学等高风险领域的广泛部署。 针对以上挑战,研究者们提出了多种改进措施。首先,在训练数据方面,增加专业数据库的接入,如PubChem和Gestis安全数据库,有望弥补模型对专业知识的缺乏。其次,结合外部工具的增强系统,例如配合文献检索、代码执行和化学合成规划器的多模态辅助,在提高模型回答准确性和推理能力的同时,也提升了模型的实用性和安全保障。

此外,通过基于人类专家反馈的偏好优化和置信度调校,可以改善模型的答案选择和风险评估,更符合实际科研需求。 大型语言模型对化学教育同样带来深刻影响。以往的化学教学多依赖死记硬背与机械练习,而LLM的出现,让学生能够通过自然语言交流获得即时、详尽的知识解答,甚至模拟实验设计和反应机制推导。但实验结果显示,模型虽然能处理众多传统考试题,却在跨学科推理和实验操作模拟上仍有限。这提示教育者需重新设计教学内容和考试形式,重点培养学生的批判性思维和创新能力,使其与人工智能协同推进科学研究。 此外,公众对化学知识的需求日益增长,尤其是在化学安全和药物使用等领域。

LLM作为一个便捷的信息咨询工具,若能充分发挥专业能力,将极大便利非专业人员获取权威信息,提升科学素养。但模型错误信息的潜在风险也不容忽视。因此,建立完善的监管和验证机制,确保AI应用的准确、透明与责任落实,是未来发展的关键。 未来,大型语言模型与化学领域的深度融合发展趋势十分明确。随着模型规模和专业数据积累的不断提升,结合多模态信息处理、符号推理和交互学习,LLM有望实现更高层次的化学理解和创新能力,例如自动设计复杂分子、规划绿色合成路线、辅助药物发现和材料设计。同时,模型与人类专家的协作将成为常态,从数据分析到实验指导,人工智能将帮助科学家跨越知识盲区,提高研发效率和成果质量。

总结来看,大型语言模型在化学知识和推理能力方面已展现出前所未有的潜力,部分模型在标准化测试中优于专业化学家,开启了人工智能辅助化学科研的新纪元。然而,模型当前仍无法完全替代人类的综合判断和创新思维,尤其是在结构推理、实验操作和安全评估方面存在短板。通过精细化的训练数据整合、工具增强和置信度优化,未来大型语言模型将在化学领域发挥更大作用,促进知识获取、教育改进和科研创新的深刻变革。对此,科学界需要持续关注技术的优势与风险,统筹推进技术规范、伦理监管和人才培养,真正实现AI与化学的共赢发展。