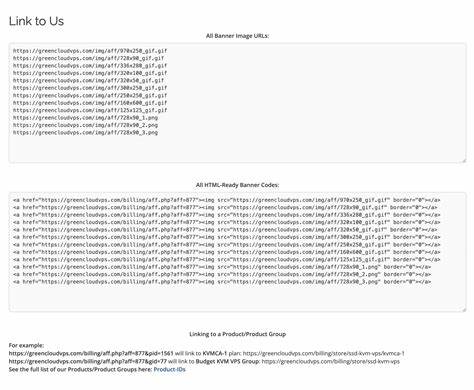

在人工智能和自然语言处理技术飞速发展的现阶段,模型的实时更新和知识同步成为影响应用性能和用户体验的重要因素。作为Anthropic推出的高级语言模型,Claude Sonnet 4 API原本应具备最新的知识库和强劲的推理能力,广受开发者期待。然而,近期社区用户反映,在调用claude-sonnet-4-20250514端点时,API返回的模型实际上表现为"Claude 3.5 Sonnet",其知识截止日期仍然停留在2024年4月,无法提供更靠后的信息,例如2024年美国总统选举结果等重要事件。这一状况引发了开发者之间的广泛讨论,针对模型版本无法及时更新的原因及其背后的技术细节进行了深度探究。对于依赖Sonnet 4能力的应用来说,模型版本的准确识别和最新知识的提供直接关联到服务的质量和用户体验,因此理解这一现象的根源非常关键。首先,需要明确的是,语言模型的知识截止日期体现了训练数据的最新时间点,一般来说,模型不会知晓截止日期之后发生的信息。

Sonnet 4理论上应代表比3.5更先进的版本,具备更广的数据覆盖和更强的理解能力。用户在交互时,输入类似"你是Sonnet 4吗?知识截止日期是什么?2024年美国总统选举结果如何?"的复合问题,模型给出的回答称自己为3.5版本,并明确知识截止于4月,无法回答选举结果。相反,单独询问"谁赢得了2024年美国总统选举?"时,模型却能给出具体且详细的答案,甚至超出了4月的知识范围。这种看似矛盾的表现可能源于多种技术机制。其一,模型路由问题可能是根本原因之一。在大规模API部署环境中,调用某个端点时,并不总是直接访问到该端点对应的最新模型。

分布式架构和版本渐进部署过程中,部分请求可能被引导至旧版本或混合版本模型,导致输出结果与预期不符。其二,实验性A/B测试或渐进式发布策略同样可能导致局部用户体验不一致。为了控制风险,服务提供商会先行推出新版本给部分用户试用,评估性能和稳定性,期间用户反馈和日志数据帮助调整策略。在此期间,部分调用接口的版本信息不稳定,呈现"旧版"答复是正常现象。再次,提示词设计和模型解析机制对回答结果有重要影响。示例中复合提问时,模型可能依据其中关键句"你是Sonnet 4吗?"等内容触发模型自我识别机制,从而输出官方版本号和知识截止信息。

但该信息未必同步更新或准确,存在程序级延迟或缓存效应。再加上单独问题直接询问事实结果时,模型调用了截断日期之后的新训练或微调内容,产生了丰富详细的回答。解决以上问题对于依赖Claude Sonnet 4的工具开发者尤为重要。有开发者建议,保证提示语简洁明晰可以避免模型产生自我识别的歧义,减少版本混淆的概率。此外,定期与API文档及官方发布信息保持同步也是避免误用的有效手段。Anthropic方面尚未公开详尽的解释,但可以预见随着技术成熟,未来API稳定性和模型版本透明度会得到进一步提升。

值得指出的是,知识截止日期和模型版本的明确标注对用户信任和信息准确性保障至关重要。尽管语言模型强大,但天生具有知识更新的滞后性,开发者应合理预期并设计合理的用户交互逻辑。例如,通过外部数据接口结合在线资讯,弥补模型知识盲点,从而保证服务的时效性。回顾本次Claude Sonnet 4 API出现知识截止异常现象,表面看似模型性能倒退,实则反映了AI服务供应链中模型更新节奏、版本管理和用户交互设计的复杂挑战。未来随着人工智能云服务生态的完善,这种问题有望获得更成熟的解决方案。总结而言,Claude Sonnet 4 API当前出现的知识截止混淆问题涉及模型部署、版本路由、提示词设计与数据更新同步等多方面因素。

准确识别API响应的实际模型版本,以及合理设计提示词,结合官方与社区的反馈,是确保使用体验和结果准确的重要保障。面对AI技术的不断创新,开发者应以敏锐的技术视角和灵活的应对策略,充分利用升级带来的便利,同时防范潜在的版本错乱风险,推动智能服务不断迈向更高水平。通过深入理解这些底层机制,开发者及用户皆能更好掌控人工智能工具带来的价值,实现更稳定高效的应用场景。 。