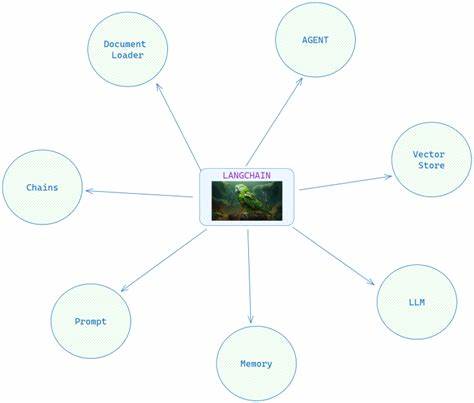

近年来,随着人工智能技术的不断发展,尤其是大型语言模型(LLM)的广泛应用,开发者们越来越需要高效、稳定且安全的解决方案来管理这些强大工具的接入和使用。BorgLLM作为一款创新性项目,通过零配置的LangChain客户端,完美实现了简化开发流程,同时内置的API密钥轮换和速率限制管理功能,极大提升了系统的安全性和可控性。本文将围绕BorgLLM的核心技术进行全面剖析,帮助读者理解其底层原理及实际应用价值。 BorgLLM的最大亮点在于提供了零配置的LangChain客户端。传统上,开发者在接入语言模型时需进行繁琐的配置,包括环境变量设置、密钥管理、接口路径调整等一系列步骤,这不仅增加了开发成本,也易导致配置错误和安全隐患。BorgLLM通过内置的智能检测和自动适配机制,几乎无需任何手动设置就能完美接入多种大型语言模型接口,极大降低了项目启动门槛。

借助这一功能,开发者可以将更多精力投入到业务逻辑和创新的开发之中,而不是纠结于繁杂的配置细节。 零配置的优势主要体现在简化部署流程和提升开发效率。对于初创团队或独立开发者而言,BorgLLM帮助他们无需具备深厚的系统集成经验,也能快速构建基于语言模型的应用。此外,BorgLLM的设计充分考虑了多样化的使用场景,其自动化适配不仅支持主流的API平台,还能够根据用户的环境动态调整参数,实现了智能化的连接管理。这种灵活性使得BorgLLM在跨平台和多项目协作中表现优异,兼具稳定性与扩展性。 在安全管理方面,API密钥的轮换是BorgLLM不可或缺的功能。

API密钥作为访问大型语言模型的唯一凭证,其安全性直接关系到数据隐私与系统安全。传统的密钥管理往往依赖人工定期更换,容易出现密钥泄露或失效的风险,而BorgLLM引入了自动轮换机制,通过后台定时更新密钥和并发检测密钥有效性,最大限度地降低了管理负担和潜在安全漏洞。自动化的密钥轮换还能够配合身份验证机制,确保只有授权用户或系统能够访问相应的接口资源,进一步强化了整体安全体系。 除了密钥的自动管理,速率限制(rate limit)也是保障系统稳定性和避免过载的重要手段。大型语言模型的调用往往存在单接口并发请求数量和总体请求频率的限制,超出限制会导致服务中断或额外费用。BorgLLM内置的速率限制管理功能能够智能监控请求流量,动态调整调用频率,避免因流量激增导致的接口拒绝服务问题。

同时,该功能也支持自定义策略,开发者可以根据实际场景设置调用阈值,实现灵活的流控管理。 借助速率限制管理,BorgLLM不仅确保了应用的连续稳定运行,还有效控制了使用成本,避免了因无效请求或攻击导致的过度计费。此外,通过对请求日志的实时分析,BorgLLM能够帮助开发者及时识别异常流量和潜在风险,为系统安全防护提供重要依据。综合来看,速率限制管理不仅是保障服务质量的技术保障,更是优化资源利用和提升用户体验的关键环节。 技术上,BorgLLM采用模块化设计,具备高度的扩展能力。其核心组件包括自动配置层、密钥管理层和流量控制层,各层协同工作,实现了功能的模块化与解耦。

开发者可以根据需求裁剪或增强各模块功能,支持定制化开发。此外,BorgLLM还支持跨语言调用接口,兼容Python、JavaScript等主流编程语言,方便不同技术背景的人员集成和使用。 从应用场景来看,BorgLLM适用于各类依赖大型语言模型的场景,如智能客服、内容生成、数据分析辅助、自然语言理解等。零配置特性让快速原型开发变得可能,自动化的密钥轮换和速率限制管理保障了生产环境的安全和稳定。尤其是在企业级应用中,BorgLLM通过降低技术门槛和运维成本,加速了AI解决方案的落地创新。除此之外,开源友好的设计也使其在社区中拥有较高的活跃度,有利于持续迭代和功能完善。

总结而言,BorgLLM作为零配置LangChain客户端,凭借自动化的配置系统、密钥安全管理和高效流量控制,为开发者和企业提供了一套成熟且易用的语言模型接入解决方案。在未来,随着AI技术和应用不断深化,如何保持系统的安全性和可扩展性将成为重点,BorgLLM的这些核心优势无疑对推动行业标准化和普及应用起到积极推动作用。展望未来,结合更多智能化管理手段与跨平台兼容能力,BorgLLM有望成为大型语言模型基础设施领域的重要利器,助力开发者在创新蓝海中抢占先机。