随着人工智能(AI)技术的飞速进步,互联网世界正经历一场前所未有的变革。然而,这场变革背后也隐藏着严峻的挑战——人工智能滥用问题。所谓“AI Slop”,指的是因人工智能模型生成的低质量、不真实甚至具有误导性的内容泛滥,进而影响互联网的信息生态和用户体验。越来越多的声音开始关注,人工智能滥用是否会杀死互联网,毁掉我们赖以交流和获取信息的数字世界。的确,互联网作为全球信息传播的核心平台,其安全、透明和可信赖性至关重要。面对人工智能滥用带来的冲击,互联网能否挺过风暴,迎来更加繁荣和健康的未来,成为了业界和公众热议的话题。

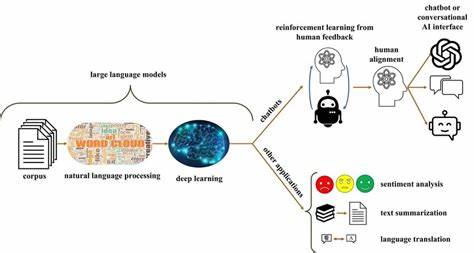

人工智能技术赋能互联网的同时,也带来了巨大的内容生产变革。传统的信息发布依赖人类创作者,而AI生成内容则使得信息产出成本大幅下降,速度显著提升。ChatGPT、图像生成模型等先进AI工具使得文章、视频、图片等数字内容快速涌现。这表面看似互联网内容更加丰富和多样,实则潜藏风险。大量自动化生成的低质量内容充斥网络,容易导致信息重复、虚假内容激增,乃至出现所谓的“内容垃圾场”。用户在面对海量信息时难以甄别真假,信息筛选变得更为复杂,影响整体信息传播的有效性和用户信任度。

更严重的是,人工智能滥用可能助长网络欺诈、虚假新闻和操纵舆论的行为。一些黑灰产利用AI生成伪造身份、操纵评论区,制造舆论风暴,或是通过虚假内容欺骗用户,谋取不法利益。信息的真实性和可靠性遭受威胁,公众对互联网平台的信任进一步受损。这种恶性循环不仅危及互联网生态,也影响社会稳定和公共舆论的健康发展。 然而,面对AI滥用带来的挑战,互联网并非束手无策。首先,技术层面不断革新,人工智能的发展本身也提供了解决方案。

AI驱动的内容检测技术日趋成熟,能够识别异常流量、恶意内容,自动标记和过滤潜在垃圾信息。数据分析和行为监测手段帮助平台识别虚假账号和异常操作,提升安全防护能力。同时,去中心化技术和区块链应用也为信息溯源和真实性验证提供了新思路,增加了内容生成和发布的透明度。 其次,政策和监管层面也在积极跟进。各国政府纷纷出台相关法规,规范人工智能的使用范围和方式,强调个人隐私保护和平台责任。互联网企业作为关键责任主体,承担着维护信息环境健康的重要角色。

主动建立内容审核机制和用户举报机制,加强算法透明度和公正性,将有效抑制AI滥用的蔓延。行业自律与政府监管结合,构建多层次、多方协同的治理体系,是实现互联网长期可持续发展的必由之路。 此外,用户教育和素养提升同样关键。让公众了解人工智能的优势与潜在风险,培养其信息辨别能力和网络安全意识,有助于形成良好的网络生态文明。网络社区应鼓励正面交流和创意内容生产,支持原创作者,减少对自动生成内容的依赖,从根本上改善内容质量。消费者的理性选择和监督,也为抑制信息垃圾化提供了重要支撑。

人工智能的迅猛发展带来了互联网内容创作和传播方式的根本转变。尽管AI滥用现象引发诸多担忧,但只要各方共同努力,合理运用技术优势、强化法规监管、提升用户素养,互联网依然能够朝着更加健康、安全和多元的方向发展。对人工智能的担忧,不应成为阻止技术进步的借口,而应激励我们积极探索解决路径,让AI成为互联网的助力者而非破坏者。未来的互联网,可能比我们想象的更加智能、包容且具有人文关怀。 综上所述,人工智能滥用确实给互联网带来了严峻挑战,但它并非“杀死”互联网的终点。相反,这种挑战推动我们重新思考和优化互联网的治理体系、技术方案和用户体验。

正视问题并主动应对,才能让人工智能与互联网协同共生,实现数字时代的可持续繁荣。互联网的未来掌握在我们每个人的手中,不容忽视也不可轻言放弃。