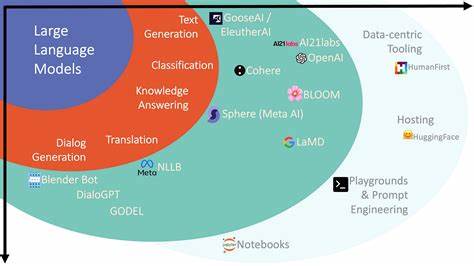

人工智能技术的发展正以前所未有的速度改变着我们的生活,而大型语言模型(LLMs)的出现无疑是近年来最令人瞩目的革命性突破之一。这些复杂的AI系统以其强大的自然语言处理能力,在多个领域展现出近似人类的理解和表达能力。与此同时,如何解释和理解这些日益复杂的模型成为一个亟需解决的问题,尤其是当它们开始自主引导对话并帮助用户理解自身内部机制时,智能代理可解释性的概念应运而生。智能代理可解释性指的是通过与大型语言模型的互动对话,促使模型主动协助人类构建对其工作原理的心理模型,实现人与机器之间信息的双向和共生。这种方法突破了传统的“黑盒”观测思路,不再仅仅依赖静态、被动的分析手段,而是通过引导、教学及解释,使人类能够更好地掌握模型的决策过程和深层含义。代理式交互不仅仅是对模型输出的解读,更强调模型与用户之间动态的认知协作,如同一位耐心且知识渊博的教师,旨在让学习者真正理解而非单纯接受,从而提升透明度和信任度。

智能代理可解释性的出现正值大型语言模型在语义理解、对话生成等任务上接近甚至达到人类水平的关键时期,其潜力不仅体现在促进技术本身的安全性与可控性,还可帮助人类学习模型中的超人类概念和逻辑体系,拓展人类认知边界。在实际应用中,利用智能代理进行可解释性交互有助于发现模型潜藏的创新思维路径和新颖解决方案,这对于科研、技术创新甚至艺术创作均意义深远。尽管智能代理可解释性带来了前所未有的优势,但也伴随着一系列挑战。首先,这种方法依赖于人机的双向互动,使得评估和量化解释效果变得复杂且主观。人类反应成为算法流程中不可或缺的一部分,导致传统的自动化评估手段难以适用。因此,设计科学合理的评价指标和实验范式成为推动该领域发展的重要课题。

其次,由于模型具备一定的自主性和“意图”,在安全敏感场景下存在被误导甚至欺骗的风险。因此,目前智能代理可解释性在高风险环境中的应用仍需慎重,必须同步加强安全保障机制和伦理规范建设。未来智能代理可解释性有望与多模态学习、知识图谱等技术深度融合,进一步丰富交互内容与形式,提升解释的深度和广度。此外,随着人工智能系统日益嵌入关键社会基础设施,人们对透明性和可追溯性的需求将愈加迫切,代理式解释体系将成为连接人类与AI的桥梁,推动社会对于AI认知的整体升级。从教育角度来看,智能代理可解释性为个性化教学提供了新路径。通过持续的互动对话,模型可以识别学习者的理解瓶颈并针对性讲解,同时引导学习者构建对模型的认知框架。

这不仅提升了学习效率,也助力培养对复杂系统的跨学科思考能力。随着模型能力的不断提升,这种以对话为核心的教学习惯将在更多领域普及,如医学诊断辅助、法律咨询乃至日常生活中的智能助理,推动人机协作进入新阶段。综上所述,智能代理可解释性代表了人工智能可解释性领域的一个重要创新方向。它发挥大型语言模型对话能力的独特优势,转变了传统的黑盒分析模式,推动人类与智能算法的深度融合。虽然现阶段仍面临评估、可靠性和安全性等诸多挑战,但其带来的潜在价值不可忽视。未来,随着技术的不断完善,智能代理可解释性将不仅提升AI系统的透明度和信任度,更将促进人类认知边界的拓展,为构建更加智能、安全和可控的未来社会奠定坚实基础。

。