随着人工智能技术的飞速发展,越来越多的企业和开发者依赖于大型语言模型(LLM)来完成复杂的任务和自动化操作。OpenAI、Anthropic以及Google的Gemini系列模型因其出色的自然语言理解和生成能力,成为如今应用范围极广的代表。然而,在实际应用中,模型调用外部工具或API时,错误率偏高的现象却频频出现,严重影响了用户体验和业务的稳定性。如何有效降低这些工具调用过程中的错误率,成为业内关注的焦点。本文将深入分析当前主流模型工具调用常见问题,探讨开发者通过Mastra代理框架打造的创新兼容层如何帮助将错误率从15%降低至3%,并分享优化思路与实践经验。理解工具调用错误的根源构建高效大模型系统,工具调用的准确性是保证任务顺利完成的关键。

大多数模型调用工具时,会依据预设的输入数据格式和约束条件对输入进行校验,一旦格式不符合模型理解范围或者违反了约束,调用失败或产生错误便不可避免。OpenAI模型往往会在遇到不支持的属性时直接抛出错误提示,例如“invalid schema for tool X”,这种硬性错误极大影响了调用的流畅度。相比之下,Google Gemini模型在面临类似问题时,更多采取静默处理的方式,忽略部分属性如字符串长度或数组最小长度的约束,虽然表面不报错,但实际行为可能偏离预期,导致调用结果不理想。Anthropic系列模型表现则相对较好,大多数测试的版本能够较准确地遵守输入约束,错误发生概率较低。然而,其他例如DeepSeek和Meta Llama模型偶尔会因极其明确的提示依旧拒绝工具调用,甚至返回不符合规范的值,表明在工具调用的支持和执行层面尚有较大改进空间。针对这一问题,开发者需要深入调查模型表现差异及工具调用失败机制,以便采取更有效的对策。

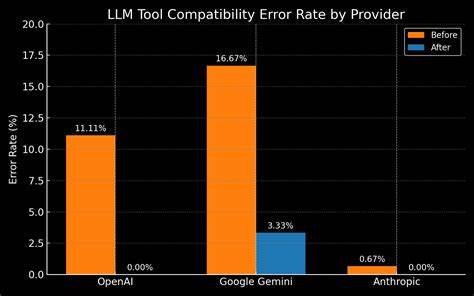

Mastra的优势与工具调用兼容层Mastra作为一款基于TypeScript的代理框架,专注于提升工具调用的规范性和互操作性。传统情境下,用户在调用工具时需传入符合Zod或者JSON Schema规范的输入结构定义。Mastra将Zod schema自动转换为JSON schema,再传递给模型以指导其理解输入要求,但由于各模型对JSON Schema标准的支持存在差异,导致调用失败或错误频发。为解决这一难题,Mastra团队设计并实现了一个“工具兼容层”,其核心目标是屏蔽不同模型对输入schema支持不一致的细节,使调用过程更为鲁棒。该兼容层通过细致分析不同模型对诸如nullable、union或数组长度等多种约束的处理表现,针对性地调整输入schema格式,确保在不影响工具实际功能的前提下 最大限度地兼容模型的解析范围。兼容层上线后,便在覆盖12款主流模型和30种属性约束的测试中将调用错误率从起初的15%降至3%,显著提升了调用可靠性和用户体验。

解决方案的探索实践Mastra团队为找出最佳兼容策略,进行了大量系统性的测试。起初尝试通过调整输入schema的具体定义来适配不同模型。例如,将nullable字段转换为optional以提升符合度,或者选择不同版本的JSON Schema规范以匹配某些模型的解析习惯。这些改动虽在若干边缘场景生效,但整体提升有限。紧接着,开发者尝试在模型提示(prompt)里直接注入详细的工具schema约束信息。这种方法通过将约束细节放入模型上下文,显著改善了调用成功率,尤其是在OpenAI、Google和Anthropic主流模型中表现突出。

虽然这种prompt注入方式有效,但从架构设计角度来看,将约束写入提示会导致提示长度增长,影响模型响应效率,也使得维护过程变得复杂,有种不自然的“阻抗不匹配”的感觉。于是,团队进一步将约束信息嵌入到工具说明(tool instructions)中,这类似于代理提示注入,兼顾了结构组织与调用成功率,测试结果显示整套测试方案全部通过。最终,团队深入挖掘,将约束直接加入到各属性的description字段中。这一创新做法尤为优雅且实用,比如原本在JSON Schema中用于定义字符串必须是URL格式的format字段,在许多模型中都会被忽略或导致错误。将验证信息放入description中,不但避免了模型的格式判断冲突,还使得约束信息紧密封装在属性定义内,不会扩散至工具或代理的整体结构。这种局部嵌入使兼容层更加模块化和易于扩展,也有利于各种后续的调试和兼容策略升级。

影响力与未来展望降低工具调用错误率不仅提升了模型的实用性,也间接推动了整个生态的稳定发展。正如网页开发历史上浏览器兼容性问题所带来的困扰一样,AI模型间调用兼容性的现状同样急需一个灵活且统一的中间层方案。Mastra工具兼容层的实践表明,通过框架层的适配和输入格式细化处理,无需改动底层模型或大幅重构应用代码,就可以实现跨供应商的无缝过渡和测试。该方案不仅与现有的MCP(模型调用协议)服务器兼容,更对任何依赖工具调用的工作流具备适用性。在对DeepSeek和Meta Llama等模型进行测试时发现,其表现不够稳定,增加调用重试次数可以明显改善整体成功率,表明兼容层与调用管理相结合的策略值得进一步发展。随着Mastra兼容层的持续迭代,更多模型支持将陆续完善,用户和开发团队能够轻松地在不同模型之间切换测试,保障应用的持续优化。

总结Mastra通过构建工具兼容层,有效缓解了OpenAI、Anthropic和Google Gemini等主流大模型在工具调用过程中的兼容性问题。详细测试和多次策略尝试,最终确定将schema约束嵌入属性描述的创新实践,不仅提高了调用的成功率,还优化了架构设计的合理性。对开发者而言,采用Mastra框架和兼容层能够显著降低工具调用错误,提升模型使用效率和应用稳定性。未来随着模型和工具生态的进一步成熟,期待更多类似的框架层创新,推动AI技术在各类业务场景中实现更广泛的落地与应用。相关资源和加入社区讨论可在Mastra官方GitHub和Discord中获取。