随着人工智能技术的迅猛发展,AI在我们生活中的角色日益重要。从智能助手到自动驾驶,从医疗诊断到金融分析,人工智能的应用无处不在。然而,随着AI的智能水平不断提升,人类在某些领域的认知能力却有可能受到挑战。由此引发了一个引人深思的问题:是否应让人工智能故意制造错误,从而促使人类保持思维的敏锐与活跃? 人工智能的优势主要体现在高效处理大量数据和提供精准答案上。很多时候,AI的高准确性让人们习惯了依赖技术解决问题,甚至在某些领域变得不再积极思考。长此以往,人类的某些认知能力或深度思考的习惯可能受到影响。

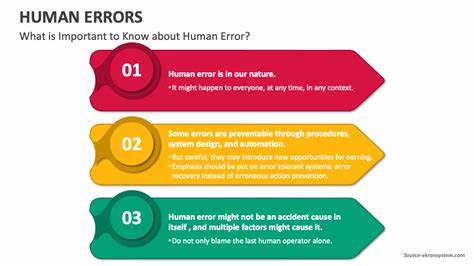

于是,有学者和技术工作者提出,或许人工智能偶尔制造一些“有意错误”,可以激发人类的警觉性和批判性思维能力。这种思考方式从一定角度来看,类似于教育中的“测试效应”,即让学习者面对一定难度的挑战,从而更好地巩固知识。 支持此观点的人认为,经过长时间依赖AI,人类可能会逐渐失去必要的质疑能力和分析能力。让AI偶尔犯错,能够提醒用户不能全盘信任机器,必须保持自主思考。这不仅有助于保持认知健康,还可以降低因盲目信任技术而引发的错误决策风险。尤其是在医疗、法律等关键领域,人类专家通过与AI结果的比对、思考,确保最终决策的正确性,是保证安全的重要环节。

然而,人工智能故意制造错误这一设想也存在着明显的风险和伦理问题。首要的担忧是,错误信息的传播可能造成误导,尤其是在没有明确告知用户AI可能会犯错的情况下。大量用户并非每时每刻都保持对结果的怀疑态度,信息一旦被误认为是真实的,其产生的影响有可能是灾难性的。例如,错误的医疗建议可能导致错过最佳治疗时机,错误的金融建议可能导致巨大的经济损失。 另一大挑战是如何设计并告知用户这一“错误机制”。有提议认为,AI可以明确告知用户每天会故意犯一次错误,从而激发用户警惕心与批判性思维。

然而,实际应用中,这一做法很难普遍推行。用户的认知水平、应用场景和使用目的千差万别,对错误的接受度也各不相同。如何在不降低信任度的前提下引入“有意错误”,是设计师必须权衡的问题。 此外,还存在着关于责任与信任的深刻讨论。人工智能作为辅助工具,其首要目标应是为用户提供准确、可靠的信息。故意制造错误似乎违背了这一宗旨,甚至可能引发用户对AI整体系统的信任危机。

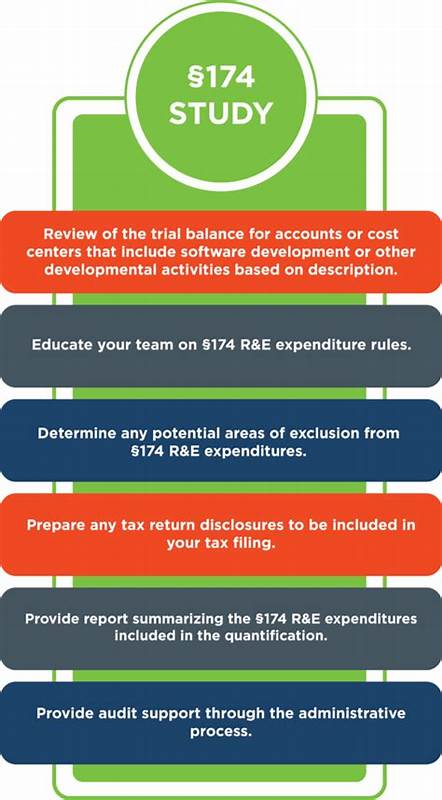

在商业环境中,错误信息可能导致品牌声誉受损,损害用户利益。如何在提升人类认知能力与维护AI系统诚信之间实现平衡,是技术开发者亟需解决的难题。 从心理学角度来看,人类的大脑确实需要适度的挑战和认知负荷才能保持灵活性和敏锐度。AI的高度便捷性虽然解放了部分认知资源,但也可能降低了人类主动思考的机会。促使人们在使用AI时保持一定的怀疑精神和独立思考,无疑有益于认知健康。或许,替代方案是教育用户如何更好地与AI互动,通过提升信息素养和批判性思考训练,实现人与机器的有效协同。

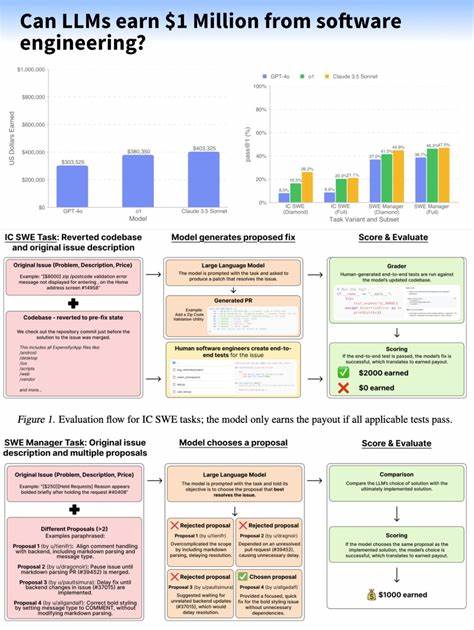

未来的发展可能会集中在如何构建一种“可监督的错误机制”,即AI在特定权限和环境下,通过透明的方式引导用户辨别和纠正错误。例如,在培训和学习软件中,AI故意设置难题或错误,可以促进用户分析和解决问题;而在医疗诊断助手中,则需要更高的准确度和风险控制,错误机制应更加严格和有限。这样,AI的“错误”成为激发创新和学习的工具,而非失误或误导的根源。 人工智能故意制造错误的理念也引出了对未来人机关系的再思考。AI不仅是信息的提供者,更可能成为认知的催化剂,推动人类思维方式的革新。如何在保证信息安全、减少误导的同时,利用AI促使人类认知保持活跃,是科学家和工程师需要共同探讨的问题。

综上所述,人工智能是否应故意制造错误以保持人类思维敏锐,目前没有可以一概而论的答案。其潜在的益处包括促进认知参与、避免过度依赖、提升批判能力等,而风险则涵盖信息误导、信任危机、伦理责任问题等。最关键的是如何在设计上实现透明化、用户教育和场景适配,使AI既能提高效率又能激发用户的思维活力。未来,随着AI技术和人类认知科学的不断融合,这一话题将持续引发广泛关注和深入研究。