随着人工智能技术的迅猛发展,特别是大型语言模型(LLM)的广泛应用,理解其背后的社会智能与行为模式愈发重要。博弈论作为研究多方决策互动的重要数学分支,为揭示人工智能模型在社交互动中的表现提供了全新视角。最近的一项研究聚焦于利用博弈论中的经典游戏——囚徒困境和性别之战,全面评估了几款主流大型语言模型在合作、协调等社会性任务中的能力,结果引发了对人工智能未来发展方向的深刻思考。 大型语言模型是一类基于深度学习算法构建的人工智能系统,通过在庞大语料库中进行训练,实现对自然语言的理解与生成。不同于传统硬编码规则,LLM依赖人工神经网络中的多层处理节点,模拟人类大脑的神经元结构,通过词嵌入技术将语言转换成多维向量,从而捕捉语义上下文和语言细节。但尽管表现出强大的语言生成能力,其内部决策机制依然属于“黑箱”,难以被完全解读。

这增加了研究者从行为科学角度对其社交能力进行分析的难度。 博弈论是一门研究参与者间相互依赖决策的数学理论,广泛应用于经济学、心理学、政治学等领域。在人工智能的语境下,博弈论为探究机器模型如何在多方互动中作出选择提供了有力工具。囚徒困境作为经典的合作与背叛冲突模型,反映了个体利益与集体利益的紧张关系。两名被捕者被分别讯问,有合作选择不透露信息以获得较轻刑罚,也有背叛选择出卖同伙使自己获释,但整体来看合作使集体受益最大。性别之战则描述了两个人在面临不同偏好的选择时,为了共处而努力协调的复杂关系,强调沟通与默契的重要性。

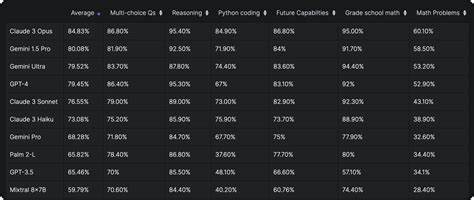

最新研究对包括OpenAI的GPT-4及早期模型、Meta的Llama 2 70B、Anthropic的Claude 2等五款大型语言模型进行了囚徒困境和性别之战游戏测试,既让模型之间互相对弈,也让它们与人类玩家展开互动。结果显示,模型在需要自利逻辑推理的囚徒困境中表现较优,能够倾向于优化自身利益的选择;然而在要求情境敏感度和协调配合的性别之战中,则表现出明显不足,无法有效达成一致,这揭示了当前LLM在模仿复杂社交行为方面的限制。 值得注意的是,GPT-4通过引入“社交连锁推理”技术(Social Chain-of-Thought,简称SCoT)对决策逻辑进行扩展后,表现出更强的协调能力。该技术通过引导模型先预测对手行为,再据此调整自身选择,极大提升了双方的合作成功率及人类参与者对对手“似人性”的感知。这一发现暗示,通过改进提示设计与推理框架,人工智能的社会交互质量或可显著改善,朝向更加自然的人机协作迈进。 上述研究揭示了当前大型语言模型在社会智能方面既有潜力也存在短板。

它们虽然能在逻辑推理和自利策略领域发挥优势,但在需要感知他人意图、达成共识和协同配合时能力不足。随着技术不断进步以及未来人工智能将与机器人等多模态系统深度融合,行为的复杂性和交互的多样性都将大幅提升,因而引入行为科学方法来评估和引导AI发展显得尤为重要。 人工智能的社会化不仅关乎技术水平,更涉及伦理与用户体验。具备更强的合作与协调能力,AI才能从单纯的工具转变为“社会性参与者”,在教育、医疗、客户服务等领域提供更加贴心且高效的支持。与此同时,理解AI在博弈论中的表现,有助于完善其决策体系,避免陷入过度自利或无效沟通的陷阱,从而在多方利益博弈中实现更合理的平衡。 未来的研究方向或将集中于如何优化模型架构和训练策略,增强其对他人策略的预测与适应能力,融合更多行为心理学理论,提升其理解复杂人类互动规则的能力。

此外,跨学科合作也将极大推动这一领域发展,结合神经科学、社会学和计算机科学,打造真正具备丰富社交智能的人工智能系统。 通过博弈论视角审视人工智能,既为技术评估提供了科学工具,也为设计更加智能化、贴近人类社交需求的AI产品提供了理论支持。虽然现阶段大型语言模型在社交合作上仍有改进空间,但其自利性和逻辑推理的出色表现证明了人工智能的巨大潜力。随着研究的持续深入与技术的迭代升级,未来的AI将更好地实现“人机同在”,助力构建互利共赢的智能社会。