在数字化时代,数据已成为驱动商业创新和竞争力提升的核心资产。Cloudflare作为全球领先的互联网安全与性能服务商,其业务规模的快速扩展也带来了对数据处理能力的极致需求。面对每天高达千亿行级别的数据摄入和处理压力,传统的数据集成与抽取加载转化(Extract, Load, Transform,简称ELT)解决方案日益暴露出性能瓶颈和扩展困难。基于此,Cloudflare自主设计并开发了Jetflow框架,打造出一套灵活且高效的数据管道体系,重新定义了海量数据处理的新标准。 Cloudflare商业智能团队管理着一个规模达数百兆字节的数据湖,每日从Postgres、ClickHouse等内部数据库以及Salesforce等外部SaaS应用采集成千上万张数据表,新数据规模庞大,达数十亿至数百亿行不等。原有的ELT工具在性能和资源利用率方面已无法满足不断增长的数据量和业务复杂性。

为此,Jetflow诞生,旨在打造一个针对云计算环境优化的、具备高度扩展性且高性能的数据摄取框架,同时保有良好的兼容性与易用性。 Jetflow在性能上的提升尤为显著。面对曾经耗时48小时处理190亿行数据的作业,Jetflow通过内存和并发策略优化,将运行时间压缩到仅5.5小时,且内存占用量从300GB降低至4GB,效率提升逾百倍。同时,通过优化数据库连接性能,实现单连接每秒摄取200万至500万行数据,是传统解决方案的十倍以上。这种性能不仅体现在速度,更体现为资源使用的极致节约,极大降低了云上数据处理的成本。估算50TB数据的摄取成本不足100美元,大幅控制了企业运营预算。

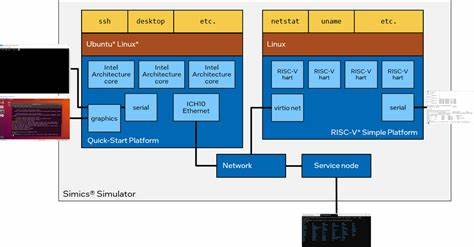

性能优化的背后,是Jetflow对数据流细致入微的架构设计。团队首先明确了关键设计需求:性能卓越,内存和计算资源消耗低;具备向后兼容性,支持单表渐进迁移;便于用户操作,尽量以配置驱动实现,无需大量编码;具备高度定制化能力,满足不同作业需求的调优;最后保证完整的测试能力,实现全栈可测试管道。基于这些需求,Jetflow构建了模块化、阶段化的数据处理体系。 核心设计理念将整个数据处理流程拆解成消费者(Consumer)、转换器(Transformer)和加载器(Loader)三个阶段。消费者负责从数据源实时抓取数据流,转换器对数据进行清洗、验证及格式转换,加载器则负责将数据持久化写入目标存储系统。整个流水线通过YAML配置文件编排,配置简单直观,确保业务用户无须编写复杂代码即可实现多样化场景的配置和自动化执行。

同时,模块间通过统一的数据流接口解耦,保证新增自定义模块时的兼容性和稳定性。 在数据分区设计上,Jetflow实现了多层处理粒度。从业务角度制定运行实例(RunInstance),对应单次管道执行的时间窗口或业务单元,细分后的分区(Partition)保证了数据分片的确定性和重试的幂等性,进一步划分为批次(Batch)以进行流水线并发优化。此细粒度划分不仅优化了流水线的并行度,还确保了错误回滚和重试时数据完整性及一致性大大提升。 技术细节上,Jetflow摈弃传统以行存储为核心的数据处理模式,全面采用Apache Arrow列式内存格式作为内部数据交互标准。Arrow格式支持跨语言的高效数据传输,极大降低了序列化带来的性能损耗。

同时,基于Go语言开发的Jetflow通过大批量预分配内存,减少垃圾回收占用,实现低延迟内存管理。列式存储匹配Parquet文件格式,使得读取源数据至写出过程的转化环节大幅简化,提升了整体吞吐量。 Jetflow在主流数据库的适配上也做了精细化优化。针对ClickHouse,团队舍弃了常规驱动的行级处理,转而采用专门的ch-go库直接处理ClickHouse原生的列块(Block)格式,最大化利用数据库层的批量读取能力,单连接吞吐量跃升至百万行每秒级别。Postgres方面,采用jackc/pgx驱动跳过传统反射扫描接口,直接解析字节码实现零分配读取,极大降低CPU和内存压力,保证了高效且稳定的数据摄入。显然,深入底层驱动的定制提升是Jetflow性能提升的关键因素之一。

除了性能和技术的突破,Jetflow同样注重用户体验和运维便捷。配置即代码的模式让团队成员能够轻松管理大量管道定义,配合内置状态追踪与错误处理机制,有效降低运维门槛。此外,容器化的本地运行环境支持开发者进行全链路测试,极大缩短故障排查时间,加快新用例的上线速度。 当前,Jetflow已经实现每日数据摄入77亿行,随着剩余系统逐步迁移完成,预计每日处理量将达到1410亿行,彻底满足Cloudflare在数据驱动决策、产品优化、安全监控等多个关键业务领域的需求。该框架稳定性和灵活性的体现,使得Cloudflare能够支持更为复杂多变的业务场景,降低云计算资源消耗,提升核心竞争力。 展望未来,Cloudflare计划将Jetflow开源,让更多企业和开发者受益于高性能数据管道的创新。

同时,公司也持续招聘有志于打造下一代数据基础设施的技术人才,推动数据生态的创新与发展。 总结而言,Jetflow不仅是Cloudflare应对海量数据处理挑战的利器,更代表了未来数据工程领域性能与灵活性并重的发展趋势。通过架构创新、底层驱动深度优化和工程设计的完美结合,Jetflow为大规模数据摄入与处理树立了全新的行业标杆,为企业如何高效构建弹性数据管道提供了宝贵借鉴。随着数据价值愈加凸显,掌握高效且安全的数据处理框架将成为企业赢得竞争优势的重要基石。