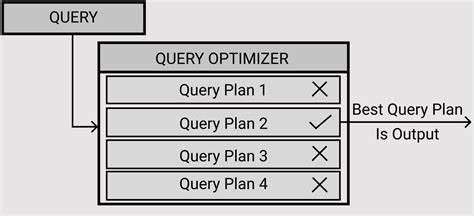

在现代数据库系统中,查询优化是保证数据访问高效性的关键环节。然而,尽管优化器致力于选择最佳查询计划,现实中往往出现未能选中真正最优方案的情况。Postgres数据库作为开源领域经典代表,其查询优化器设计及行为为业界所广泛研究和借鉴。本文围绕为何查询优化器无法总是挑选最优计划展开深入分析,结合随机页面访问成本(random_page_cost)参数的调整探讨其对查询策略选择的影响,并对解决该难题的潜在技术路径进行展望。首先理解查询计划的选取要从优化器评估不同扫描方式的成本模型说起。Postgres优化器主要通过成本估算机制权衡顺序扫描、索引扫描以及位图扫描三种主要访问路径。

成本计算中,数据访问的随机和顺序I/O开销是核心要素。随机页面访问成本参数用以体现随机访问相对顺序访问的额外资源消耗,是影响索引扫描成本估算的关键变量。其默认值自设定以来长达数十年并未有重大调整,仍然沿用着最初针对机械硬盘的经验值,通常定为4.0。与之对应的是,顺序扫描成本不随该参数变动,而位图扫描成本也较为稳定。随机页面访问成本的高低决定了优化器对索引扫描的偏好程度,较高的值使得优化器在数据选择性较低时更倾向于使用顺序扫描或位图扫描;而较低值则倾向选择随机访问频繁但理论成本更低的索引扫描。通过调整random_page_cost参数,实际观察到优化器计划选择的显著变化,尤其在数据选择性介于10%至100%之间尤为明显。

调整到较低的值,加强了索引扫描的“吸引力”,令其成为默认选方案,然而实际执行性能却反而变差,显示优化器的成本估算与现实执行存在偏差。探究这一现象背后的深层原因,主要在于优化器的成本模型对现代硬件以及系统预取机制的体现不足。现代固态硬盘(SSD)及NVMe存储极大缩小了随机和顺序I/O的性能差距,使得传统基于机械硬盘设计的成本参数不再适用。尤其是在热缓存环境下,访问延迟更低,更倾向于影响查询等待时间而非I/O开销。但即便如此,随机I/O依然比顺序I/O耗费更多系统资源,完善的成本建模需综合考虑这一现实。优化器未充分考虑位图扫描所隐含的预取优势也是关键因素之一。

位图扫描通过批量访问数据页,借助预取机制顺序读取内存页,显著减少了磁盘寻址次数和I/O延迟,而索引扫描则频繁进行随机访问,缺少预取优化。在Postgres 18版本中,effective_io_concurrency参数默认从1调整到16,强化了位图扫描的并发I/O能力,进一步拉大了两种扫描策略的性能差异。当优化器未能将这些机制准确建模,导致索引扫描估算成本被低估,间接导致选出非最优计划。性能评测实验显示,当数据完全冷启动时,即缓存空置,索引扫描计划反而出现明显的慢速执行表现,尤其是在设置较低random_page_cost后。相较之下,顺序扫描或位图扫描对于冷数据读取表现更为稳定且高效。热数据场景中差异减小,因缓存层降低了I/O瓶颈。

但总体来看,优化器单纯依赖静态成本指标,而非动态实时反馈,导致无法自适应复杂多变的硬件环境及数据特性。排查是否受此影响的难点在于,查询执行时间表现常常是单一且稳定的,缺少显著的性能跳变或异常波动导致难以察觉潜在非最优选择。有时只有处于临界点,性能表现出现明显两极分化,才能快速锁定问题区域。日常工作中,则需要结合禁用某些扫描方式(enable_开关)进行强制测试,评估不同执行路径的实际性能差异,从中识别改进方向。然而,这种测试方法在面对复杂查询和多样 workloads时极为耗时,难以批量自动化。面向未来,对解决查询计划选择非最优问题的思路主要聚焦于两大方面。

一是重新校准random_page_cost默认值,适应现代存储环境。已有建议将该参数调降至1.1至2.0,甚至更低以适配SSD,但存在过于激进导致误判的风险。理想中,数据库应提供自动调优工具,通过实际I/O基准测试动态确定最合适的成本比值,类似pg_test_fsync的机制,但这一方案面临着成本模型复杂性及多维依赖关系带来的巨大挑战。再者,应深化成本模型对系统预取及并发I/O的认知,将预取行为纳入扫描策略估计。借助索引扫描预取技术研发,可以弥补传统索引扫描在随机I/O上的劣势,提升其实际性能,使性能体现与成本估算更加一致。同时,也促进带宽和I/O资源的更合理利用,减少与位图扫描的性能鸿沟。

此外,更加智能的查询优化策略已成为研究热点。改进统计信息采集、实时反馈结合的自适应查询优化、以及机器学习辅助的优化决策,都为提升查询计划选择的准确度提供了新的可能。优化器不必单纯依赖预估数据,而是根据历史执行数据调整模型,动态适应不断变化的负载与数据特点。不可忽视的是,完美的查询优化器或许只是理论理想。复杂多变的业务场景、数据分布以及底层硬件特性共同制约着单一模型的泛用性。现阶段的更切实方向是构建鲁棒执行器,具备应对计划误判的容错机制和自我调整能力。

通过执行时动态切换策略、资源分配调优以及渐进式查询处理,确保即使误选计划也能将执行时间和资源浪费降到最低。在深入理解查询计划未必最优的背景下,我们应意识到这是数据库优化领域固有的挑战。调整参数、增强模型、改进执行策略三者缺一不可。Postgres社区的持续探索与实践正推动该领域走向更智能、更高效的未来。最终目标在于实现兼顾准确性与适应性的优化体系,让用户在处理海量且复杂数据时,获得稳定且优质的性能体验。