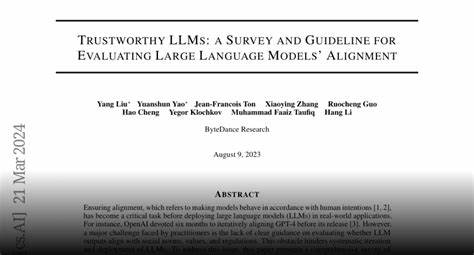

随着人工智能技术的不断进步,大型语言模型(LLMs)已经成为推动自然语言处理领域革新的关键力量。尤其是链式推理(Chain-of-Thought, CoT)技术的发展,显著提升了模型的推理能力,使其在语言理解、复杂问题解决以及代码生成等任务中表现出色。链式推理通过引导模型生成中间推理步骤,不仅提升了输出结果的准确率,还增强了解释性,帮助用户更好地理解模型决策过程。然而,在技术进步带来便利的同时,如何确保推理过程的可信性成为学术界和工业界共同关注的重要议题。本文综合分析了当前关于大型语言模型推理可信性的研究进展,重点聚焦于真实性、安全性、鲁棒性、公平性和隐私保护五大核心维度,力求为AI安全社区及相关从业者提供系统且深刻的洞见。真实性是推理可信性的基石。

尽管CoT技术能减少模型生成中的谬误,但LLMs仍面临幻觉(hallucination)问题,即模型可能生成与事实不符的内容。当前研究致力于通过引入事实验证机制、结合外部知识库以及设计更合理的训练目标,降低幻觉现象的发生率。此外,强化学习和人类反馈也在提升模型真实性方面发挥了重要作用。安全性方面,推理模型需要避免输出有害内容或被恶意利用制造误导信息。虽然链式推理为内容审查和异常检测提供了更多线索,但新的攻击手段仍层出不穷。例如,模型可能被引导生成偏激、歧视或虚假信息,造成信息环境污染。

研究者探索通过多层次防护机制、模型调优策略以及跨模态验证手段提升整体安全水平。鲁棒性是模型在面对噪声、攻击或数据分布变化时依旧保持稳定表现的能力。CoT推理在一定程度上增强了模型对复杂任务的适应性,但在面对对抗样本或系统输入异常时,LLMs依然表现出脆弱特性。为此,研究者们尝试结合多视角推理、多样性生成策略以及强化模型自我校正能力,以增强其在实际环境中的稳定性和可靠性。公平性问题日益受到关注,尤其是在模型推理过程中,偏见可能通过训练数据或推理路径被放大,导致特定人群受到不公待遇。一些研究聚焦于去偏算法,力图消除模型对敏感属性的偏见,同时引入多元化评价指标,确保推理结果在道德和法律层面均符合社会期望。

隐私保护是另一个不容忽视的方面。大型语言模型在训练和推理过程中,可能无意中泄露用户敏感信息,带来隐私风险。基于差分隐私、联邦学习以及加密计算的技术方案被广泛探讨,用于在保障推理效果的同时防止数据泄露。此外,合理的数据治理和合规框架同样非常关键。综合来看,尽管链式推理技术为提升模型可信性提供了强大工具,但它本身也面临安全漏洞、鲁棒性不足等多重挑战。未来的研究应致力于构建更为稳健、透明且可控的推理体系,融合跨领域知识、优化模型训练机制,并加强人机协作,促进人工智能系统的健康发展。

与此同时,推动国际合作与标准制定亦是保障推理可信性不可或缺的环节。人工智能技术的快速发展使得可信推理成为实现安全、可靠智能系统的核心,唯有持续深化理论研究与实践创新,才能有效应对技术带来的全球性挑战,为社会创造更大价值。 。