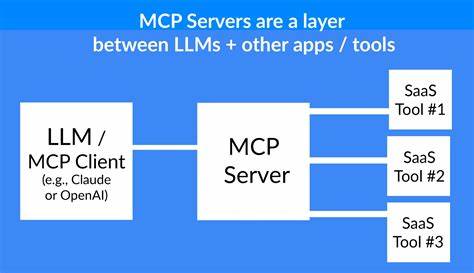

随着人工智能技术的迅猛发展,Model Context Protocol(简称MCP)作为连接AI模型与外部数据系统的重要协议,正逐步成为行业标准。MCP服务器作为承载这一协议的核心组件,承担着复杂的数据交互和多任务处理,其性能优化直接关系到AI应用的响应速度和用户体验。本文将深入分析MCP服务器独特的性能特点,探讨实际优化路径,为相关开发者和技术团队提供切实可行的指导。 在传统的客户端-服务器架构中,人类用户发起请求,服务器依据请求处理数据并反馈结果,这种模式下请求量和复杂性相对可控。而MCP服务器的环境明显不同,主要为AI模型服务。AI模型能在短时间内发起成百上千个并行请求,涉及数据库查询、API调用、文件系统操作等多种资源访问场景。

请求模式的高速并发与数据庞大规模对服务器性能提出了前所未有的挑战。 MCP服务器的请求不仅频繁,且请求类型和所需返回数据的结构复杂多变,这让传统的性能优化方法—诸如缓存机制、连接池管理和负载均衡—虽依然重要,却不足以全面应对。更为关键的是响应数据的体积和结构直接影响AI模型的“上下文窗口”,也就是模型能一次性处理的有效信息量。 上下文窗口是大型语言模型处理对话和任务的关键资源。每一次从MCP服务器返回的数据都会消耗一定的“tokens”,即模型内的语义单元。虽然现代AI模型如Anthropic的Claude支持极大规模的上下文窗口(可超20万token),但实际上多轮对话、复杂任务过程中的多次高频调用很容易快速耗尽这一资源,导致模型不得不“丢弃”先前的有用信息,直接影响模型理解连贯性和响应准确度。

因此,从服务器端进行严格的响应优化,减少无用或冗余数据的返回,成为提升整个AI系统性能的直接路径。首要策略便是精简JSON响应结构。普遍存在的数据返回往往包含大量对当前任务无关紧要的字段,例如完整地址信息中详细的经纬度、时间戳、国家代码等,均可能被省略。将数据萃取为只包含任务核心信息的最简形式,能大幅缩减数据体积,节省带宽与模型上下文token消耗。例如,将包含完整地址信息的JSON对象压缩成简明的地址字符串,响应大小可降低60%-80%。 除了手动筛选精简字段,最佳实践还包括提供动态字段选择接口,让调用方根据实际需求请求特定属性,或设计专门针对AI应用场景优化的接口,从源头减少无效数据传输。

此外,一些特殊情境下,完全跳过JSON格式,采用纯文本返回同样可显著减少token消耗。纯文本去除了JSON的语法结构开销,语言模型在面对规则清晰且格式固定的文本表达时,解析能力强大且效率高。此种方式非常适用于文件目录、日志条目、简单表格数据、搜索结果和状态报告等数据类型。 不过,采用文本替代JSON也带来了机器可解析性的下降,可能对后续自动化处理产生障碍。因此,文本响应需保证格式统一,同时配备详尽文档说明以辅助AI模型和后端系统正确理解数据。 除了响应数据体积,另一个经常被忽视的性能“隐形杀手”是工具定义的上下文代价。

在传统API设计中,接口文档和定义通常与请求分离,而在MCP框架下,工具定义必须包含在AI模型的上下文中,每次会话都占用极为宝贵的token资源。这包括函数描述、参数结构、验证规则和示例。尤其是企业级复杂工具,定义部分往往庞大,动辄数百乃至上千token,加之多工具集成时,这部分开销可能轻松达到甚至超越上万token,显著挤压有效作业数据空间。 针对工具定义代价,优化策略集中在简化描述语言、剔除多余示例和结构,采用对外链接取代内嵌冗长说明,以及动态加载工具定义。通过上下文感知只加载当前对话实际所需的工具,避免一次性全量装入,大幅降低token负担。同时,将功能相关的工具合并到“工具包”中,可减少定义重复和数量,从而进一步节省资源。

物理服务器位置的选择也依旧影响MCP服务器的性能表现。由于Anthropic等AI基础设施主要集中在北美,尤其是美国东部地区,MCP服务器若部署在靠近这些数据中心的位置,能实现更低的网络延迟和更快的请求响应速度。延迟降低100毫秒到300毫秒虽看似微小,却能在AI多轮请求的链式调用中产生乘数效应,显著提升整体交互流畅度和任务处理效率。 随着OpenAI和其他AI服务商扩展全球基础设施,欧洲、亚洲等地区的性能优势将日渐显现。对此,跨区域多地部署MCP服务器并结合地理负载均衡策略,是面向多AI平台、多用户群体的理想解决方案。尽管增加了基础设施复杂性,但通过合理架构设计,这种策略在提升响应速度的同时,降低因延迟和网络不稳定带来的token额外消耗,长远看助力整体成本优化。

总体来看,MCP服务器性能优化是AI时代性能工程的新方向。传统web服务性能改善方法仍是基础,但AI特有的高并发请求密度、庞大数据吞吐量和上下文窗口限制,要求开发者采用更为细致和针对的优化策略。控制传输数据量、合理设计工具定义、注重服务器部署地理优势,是构建高效MCP服务的关键脉络。 未来,随着MCP协议及其实现技术的持续演进,这些性能挑战只会更加突出。开发团队应密切关注AI技术和基础架构变化,持续迭代优化方案,才能在竞争激烈的AI市场中保持领先。低延迟、高效响应和极致的数据精简,将成为优质MCP服务的标配,也是AI应用实现智能化突破的重要保障。

作为专业的网络性能咨询机构,Catch Metrics期待与各行业MCP服务器开发和运营者分享优化经验,携手攻克性能瓶颈,打造更加卓越的AI智能生态。欢迎有相关需求的技术团队联系我们,共同探讨如何提升您的MCP服务器表现,释放AI潜力。