随着人工智能技术的飞速发展,基于大规模语言模型(LLM)的智能体正在成为推动自动化和智能化应用的重要力量。在这一背景下,如何让智能体不仅具备理解和执行复杂任务的能力,还能通过自我优化不断提升表现,成为业内关注的热点。遗传算法(GA)和强化学习(RL)作为两种强有力的优化和学习方法,其结合在提示驱动智能体中的应用,激发了诸多探索与创新。本文将深入剖析GA与RL如何协同工作,助力提示驱动智能体的进化发展,并探讨其架构设计、实际可行性和潜在挑战。基于提示的智能体,尤其是在编程辅助、需求工程等领域,展现出强大的适应性和创造力。然而,传统强化学习往往依赖有限且明确的动作集合,而语言模型中的提示设计却极为复杂且开放,这在一定程度上限制了RL的直接应用。

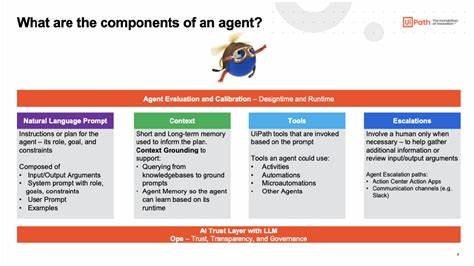

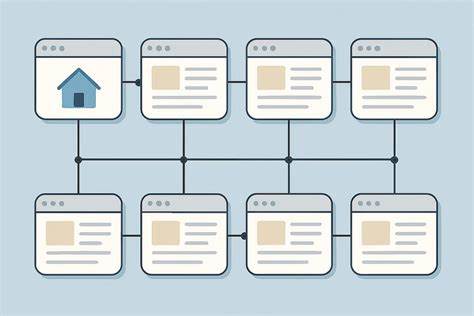

为解决这一矛盾,遗传算法的引入提供了新思路。通过将提示视作“染色体”,每条染色体包含多个可变的“短语”,如激励表达、行为规范或思考指令,GA能够模拟生物进化过程中的选择、交叉与变异,使提示逐代优化。这种表征方式既保证了提示的灵活多样,也使其优化路径更加明确。结合强化学习的核心机制,GA不仅能探索复杂的提示空间,还能在智能体的反馈中不断调整进化方向。值得关注的是,一种两层架构的设计理念被提了出来:元智能体与子智能体的协同配合。元智能体肩负总体任务规划、分析与评估的职责,同时监督子智能体的进化过程。

子智能体则专注于具体的任务执行,如代码生成、需求细化与测试工作。每完成一个进化周期后,多个子智能体实例被激活,经过性能评估后选出表现最佳的种群继续留存。这种分层架构不仅提升了智能体系统的扩展能力,也使得演化过程更加系统化和定向。从实际应用角度看,基于GA和RL的提示驱动智能体能够显著提升自动化辅助工作的效率与质量。例如,在软件开发过程中,提示进化促使代码生成更加精准,需求理解更为深入,甚至测试覆盖率和代码质量也得到有效提升。在更广泛的行业应用中,这种智能体的自我优化能力可实现更智能的客服交互、个性化内容创作和复杂任务自动执行。

不过,这种技术路径并非没有挑战。首先,提示的无限可能性带来了搜索空间极其庞大的问题,GA在这一空间中的收敛速度和全局最优保证仍需进一步研究。其次,如何设计合理的适应度函数以准确衡量任务成功与输出质量,是体系性能的关键。此外,元智能体与子智能体之间的协调机制需高度可靠,以防止演化方向偏离预期目标。尽管如此,目前已有部分研究尝试将GA应用于提示优化领域,诸如2025年发表的论文《GAAPO:遗传算法应用于提示优化》为这一方向提供了理论支撑与实证分析。结合现有强化学习框架,未来完全有可能形成一种融合GA和RL优势的复合型智能体架构,推动人工智能应用迈上新台阶。

展望未来,跨学科的融合创新将成为智能体进化的关键驱动力。基于提示的智能代理借助先进的进化算法与学习规则,既能保持灵活开放的表达方式,又能通过数据驱动的优化不断提升能力,实现真正的自适应智能。开发者和研究者应关注这一领域的最新进展,积极尝试多模态、多层次的智能体设计方案,切实解决搜索空间庞大、评估指标多样化等现实难题。综合来看,遗传算法与强化学习在提示驱动智能体中的应用不仅具备理论上的可行性,更具备广泛的实践潜力。伴随着算力提升和算法优化,未来的智能体将能够更加自主高效地完成多样化任务,推动人工智能走向更智能、更具创造力的阶段。