近年来,人工智能技术的快速演进正在深刻改变各行各业的运作方式。微软作为全球领先的科技公司,积极推动云端AI服务的普及与创新,尤其是在Azure平台和OpenAI技术的结合运用方面成绩斐然。然而,随着技术的不断革新,相关的网络安全问题也日益凸显。2025年初,微软首次公开了一起针对其云端AI模型的复杂网络攻击事件,提醒全球企业和开发者必须提升对AI安全风险的重视。该事件揭示了黑客通过非法获取Azure云服务用户的登录凭据,进而利用特殊编写的程序绕过微软对其AI模型设定的“保护屏障”,以生成具有攻击性或恶意内容的图像。微软在公开的诉讼材料中指出,这种攻击不仅违反了《计算机欺诈和滥用法案》及《数字千年版权法》,也涉嫌构成敲诈勒索性质的犯罪行为。

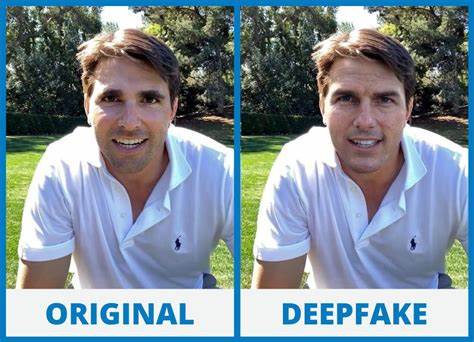

此次侵袭主要针对微软基于OpenAI技术研发的DALL-E图像生成AI,其本应内嵌严格的管控机制,防止用户生成暴力、色情、仇恨及政治敏感等不当内容。然而,黑客通过破解技术手段,成功禁用这些保护措施,让AI生成非法或有害图像的风险大幅上升。这类安全漏洞的存在,彰显了AI系统固有的双刃剑属性:一方面其强大的创造力推动了内容生产的革新,另一方面若被不法分子利用,也可能在社交媒体、虚假信息传播、甚至恶意政治宣传等领域引发严重后果。类似的安全事件并非微软独享。去年,谷歌旗下的Gemini AI因误判生成种族和文化敏感图片,迫使谷歌紧急暂停该功能并公开道歉,显示各大科技巨头在保护AI内容安全方面仍面临巨大挑战。微软针对本次攻击的快速反击,展现了其技术实力和法律手段的双重保障。

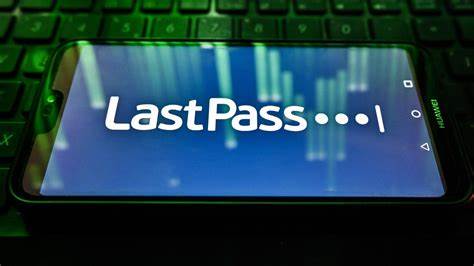

法院授权微软查封了被认为是此次黑客攻击关键工具的相关网站,并在Azure平台上部署了新型反制技术,以防范今后同类安全隐患重演。微软还强调,保障登录认证信息的安全是防范此类攻击的根本方向。黑客往往通过窃取合法用户的凭证获得入侵通路,因而提醒企业和个人用户务必强化密码管理、加强多因素认证部署,避免简单密码或账号信息泄漏。对于中小企业而言,虽然在人力和资金上难以与微软等科技巨头相抗衡,但有望借助AI自身的智能安全防护工具提高安全防御水平。越来越多的安全公司开发了基于AI的威胁检测和响应平台,可以实时监控异常登录行为、发现潜在漏洞和攻击企图,降低人类安保专家的负担。同时,客户数据的隐私保护和合规要求也必须纳入AI应用的风险评估范畴。

尤其是在涉及生成式AI制造内容的场景中,企业需要建立明确的伦理准则,杜绝助长有害、不实信息的风险。值得关注的是,针对自由言论与内容管理之间的平衡问题,各方观点迥异。以埃隆·马斯克旗下的社交平台X为代表的倡导者倾向于减少AI“护栏”的限制,强调言论自由的重要性。然而,这也无疑为恶意利用AI技术制造仇恨、谣言和虚假资讯提供了空间,增添了网络治理的复杂度。未来,随着AI技术的广泛应用,网络攻击手法必将更加隐秘和多样化。企业与监管机构需密切合作,加强跨境信息共享、技术研发及法律法规制定,全面构筑涵盖技术、管理和法律多层面的安全防线。

微软此次揭示的新的攻击事件有助于全球业界增强风险意识,推动生态系统加快完善AI产品的安全设计和准入机制。作为AI时代的参与者,企业应该从微软的案例中吸取教训,强化自身的账户安全管理,加强对AI模型使用风险的监控,同时投资于先进的安全技术。唯有如此,才能在享受人工智能带来便利和创新的同时,最大限度地降低潜在的威胁。未来,人工智能必将成为数字经济的核心驱动力,安全问题绝不能被忽视。只有建立稳固、安全、可信赖的AI环境,才能真正释放其变革力量,推动社会进步。