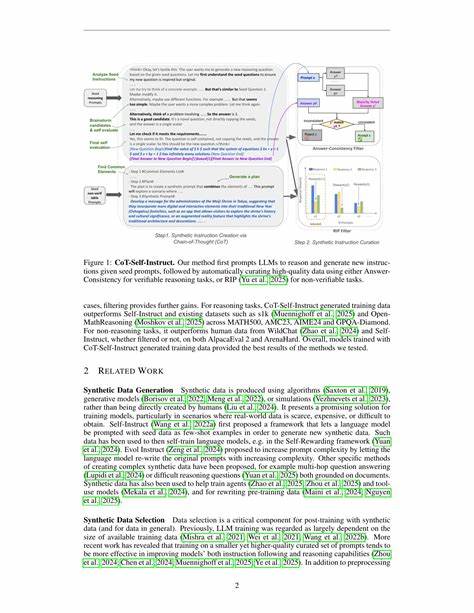

在人工智能飞速发展的时代,语言模型(Large Language Models,简称LLMs)因其卓越的自然语言处理能力而受到广泛关注。随着应用场景的不断扩展,训练数据的质量和多样性愈发成为制约模型性能提升的重要因素。CoT-Self-Instruct是一种创新的合成提示生成方法,以链式思维(Chain-of-Thought,CoT)为核心,旨在为推理和非推理任务创造高质量的合成训练数据,从而推动模型在复杂任务上的表现达到新高度。该方法不仅在理论上具有突破性意义,也在实验中展现出显著优势,成为自然语言处理领域的重要研究热点。CoT-Self-Instruct的核心理念是通过引导语言模型进行多步骤的推理和规划,使其生成的输出不仅回答问题,还展示推理过程。这种链式思维不仅提升了推理任务中的准确率,也为非推理任务提供了更具逻辑性的训练样本。

具体而言,该方法从已有的种子任务着手,首先让模型模拟思考和推导,然后依据这个推导过程生成新的合成示例,确保新数据不仅质量高,而且复杂度与原始任务相当。完成数据合成后,CoT-Self-Instruct还引入了一套自动数据筛选机制,通过一系列评估指标过滤出最佳样本,保障训练数据的纯净度和有效性。这一环节是提高模型训练效果的关键所在,避免了低质量数据对模型性能的负面影响。相比于传统的训练数据,CoT-Self-Instruct在多个验证推理任务中表现出色。在数学题集MATH500、AMC23竞赛题、AIME24测试以及GPQA-Diamond评测中,利用该方法生成的合成数据显著超越了既有的数据集如s1k和OpenMathReasoning,显示其在数学和符号推理任务上的强大优势。更令人瞩目的是,CoT-Self-Instruct对非验证类的指令跟随任务同样适用。

在诸如AlpacaEval 2.0和Arena-Hard等基准测试中,其训练出的模型表现优于依赖人工标注和传统Self-Instruct方法训练的模型,充分证明了其广泛的应用潜力和适应性。从技术角度看,CoT-Self-Instruct的创新之处在于将链式思维与自我指导训练相结合,打破了以往依赖人工大量标注的瓶颈,极大地节约了人力成本和时间成本。与此同时,这种自动化合成数据方法能够持续扩展训练集规模,满足不同复杂度任务对样本多样性的需求。该方法不仅适用于数学和推理题目领域,也潜在适合各种需要多步骤推理和逻辑分析的应用,比如法律文档分析、医学诊断推断以及复杂编程任务等,拓宽了人工智能技术的适用范围。此外,CoT-Self-Instruct体现了未来人工智能模型训练趋势,即通过内生的推理机制提升模型智能,而非简单地堆叠数据量。这种以推理为核心的训练策略,有助于开发出更加智能且具备解释能力的模型,推动人工智能从“黑箱”向“可解释”转变,促进技术更加安全和可信赖。

随着更多公开数据集和工具链的问世,CoT-Self-Instruct有望成为构建新一代智能系统的重要基石。研究人员和开发者可以基于该方法构建专属的训练数据流水线,实现对定制化任务的支持和优化,助力业务场景智能化升级。同时,社区合作和开源生态的建立,也将促进方法的迅速迭代与完善,加快技术成果转化为实际生产力。总之,CoT-Self-Instruct通过引入链式思维的自我指导合成策略,不仅提升了语言模型在复杂推理和指令执行任务中的表现,还为数据生成和训练范式带来了革新。其在真实性、复杂度和多样性上的突破,为AI模型发展注入了新的活力,推动人工智能技术迈向更加智能、高效的未来。这一创新方法不仅对学术研究具有示范意义,也对实际工业应用产生深远影响,值得从业者和研究者深入关注与探索。

。