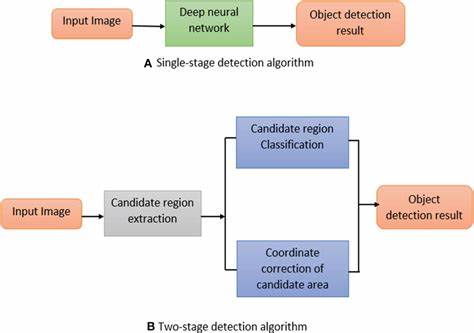

随着数字视频内容的快速增长,如何高效准确地在海量视频中寻找特定物体成为计算机视觉领域的重要挑战。2003年,Oxford大学Sivic与Zisserman提出了Video Google,一种借鉴文本检索技术实现视频中物体匹配的新颖方法,极大地推动了视频搜索与分析技术的发展。Video Google的核心思想是将视频中的物体识别问题转化为类似于文本检索的任务,通过预先计算和存储物体局部特征的向量量化表示,实现快速的物体检索和定位。传统的物体识别面临视角、照明变化和部分遮挡等复杂问题,Video Google通过采用视角不变的局部区域描述符,有效克服了这些挑战。这些局部描述符由视频帧中的多个重叠区域组成,每个区域通过其视觉特征编码成高维向量。随后,通过向量量化技术将这些高维向量映射成离散的视觉单词,构建出类似文本中的词汇表,为后续检索建立基础。

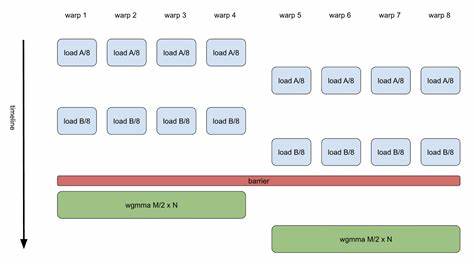

相较于传统基于最近邻匹配的物体识别方法,Video Google的显著优势在于检索效率的极大提升。它借鉴文本检索中倒排文件索引结构的优点,将视觉单词作为索引依据,快速定位包含特定视觉单词的帧或镜头。这种预先计算的索引系统使得检索过程无需实时计算距离或相似度匹配,从而实现即时响应,极大提升了应用的实时性和可扩展性。此外,Video Google利用视频中的时间连续性来追踪局部区域,剔除不稳定的区域描述符并减少噪声影响,这样不仅提高了匹配的可靠性,也保障了检索结果的准确性。通过对两个长片的实验,研究团队成功地展示了该方法在实际应用中的效果:能够快速定位视频中用户指定的物体,无论镜头角度或光线如何变化,甚至在部分遮挡情况下依然能准确匹配到目标。将文本检索的理念应用于视觉数据,Video Google不仅体现了计算机视觉与信息检索技术的跨学科融合,也为后续视频内容理解奠定了理论和实践基础。

文本检索系统通常包括文本预处理、词干提取、停用词过滤、词频统计与加权、倒排索引构建等关键步骤。Video Google巧妙地将这些步骤映射到视觉领域,定义了"视觉词汇",通过向量量化实现视觉特征的"词干化",剔除无区分力的"视觉停用词",并采用权重机制衡量视觉词汇的重要性,从而保证检索的高效与准确。这种方法的创新之处还在于它的灵活性。通过构建通用的视觉词典,可以支持对视频中任何出现过的物体进行快速检索,用户不需要事先定义目标,充分体现了系统的通用性和适应性。Video Google提出的框架具有极高的应用价值。随着视频数据急剧增加,传统的手工标注和搜索方法变得不可行,而基于内容的自动检索技术成为数字媒体管理的必然趋势。

该技术不仅可以用于智能视频监控、影视内容管理、在线教育资源检索,还为增强现实、自动驾驶等领域的视频理解提供了关键支持。尽管Video Google在视频物体匹配领域取得了开创性成果,但未来的发展仍面临诸多挑战。更复杂的场景下,物体的动态变化、部分遮挡、光照剧变以及视频质量的参差不齐都会影响匹配效果。与此同时,随着深度学习技术的兴起,如何结合深度特征和文本检索思想,进一步提升物体检索的鲁棒性和准确率,是后续研究的重要方向。此外,视频内容的时序信息与空间关系的深度挖掘也将成为提升识别效果的关键。Video Google为我们提供了一个将视觉信息转化为"文本"形式进行检索的有效范式,它通过视角不变的描述符和倒排索引技术,实现了视频物体匹配的高速与精准。

它不仅丰富了基于内容的视频检索技术体系,也为计算机视觉和信息检索的交汇研究开辟了新思路。未来,随着算法效率和硬件性能的提升,这种基于视觉词汇的检索方法有望在更多实际应用中发挥重要作用,推动智能视频分析迈向更高水平。 。