随着人工智能的不断发展,强化学习作为机器自主决策的重要方法之一,已广泛应用于自动驾驶、机器人控制、金融投资等多个领域。然而,传统强化学习模型复杂且难以解释,这不仅影响了用户对系统行为的信任,也限制了其在高风险场景中的推广应用。可解释强化学习(Explainable Reinforcement Learning,简称XRL)因此应运而生。XRL旨在通过提供人类易于理解的解释,揭示强化学习模型的决策过程与行为逻辑,从而提升系统透明度与可控性。 近年来,XRL逐渐成为人工智能研究的热点,相关文献数量持续增加,且研究内容涵盖理论、算法、应用及可视化等多个方面。一些国际顶级学术会议如AAAI、ICML、NeurIPS、IJCAI等均有丰富的XRL相关论文发布,反映了该领域活跃的研究氛围。

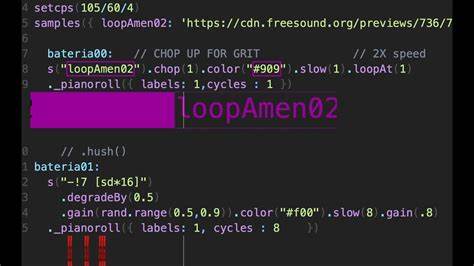

研究人员通过构建模型抽象、奖励分解、因果推断、反事实分析等多种技术手段,努力破解深度强化学习黑箱的神秘面纱。 在可解释强化学习的最新成果中,未来基于的解释技术引起关注。例如CrystalBox方法能够预测智能体未来的行为和奖励,从而直观地说明其决策依据。多智能体系统中的因果说明也在AAMAS等会议中得到深入探讨,通过揭示不同智能体间的影响关系,有助于优化协作策略。在交互式解释方面,ASQ-IT框架通过与用户的动态交流,增强了智能体行为的理解度和用户体验。 除此之外,XRL领域还重视基准测试和评价体系的建设。

XRL-Bench为该领域提供了一个统一的评测平台,有利于不同解释技术的定量比较和性能优化。该基准涵盖了多样化的任务环境和标准指标,推动XRL方法更加系统和标准化的发展。 研究还聚焦于如何将XRL应用于实际生产系统,例如制造调度中利用可解释AI技术提升决策透明度和效率。此外,建筑能源系统和智能交通等关键行业的深度强化学习控制也开始引入解释方法,旨在实现安全可靠的智能控制。 学术界对XRL的整体认知逐渐清晰,涌现出大量系统性的综述和评审文章,帮助新入门的研究人员快速掌握领域脉络。这些综述涵盖了从全局解释、局部解释到对比性解释的理论框架,细致梳理了关键算法的优势与不足,指出未来发展的挑战和趋势。

解释方法的多样性体现在策略提炼、符号逻辑结合、程序化表示等方面,旨在实现模型的可验证性和可编辑性。树状结构、注意力机制映射、原型学习等技术被广泛采用,用以将复杂的神经网络政策转化为更易理解的形式。基于奖励分解的方法也帮助揭示行为背后的动机因素,增加解释的直观性。 在多智能体强化学习中,因果关系和时序依赖的解释成为研究重点,提升了对复杂协作行为的理解能力。此类研究不但强调模型的准确性,也推崇人机交互友好的解释表达方式,促进人类监督与信任的建立。 另外,反事实解释作为XRL的新兴方向,通过构造与现实不同的情景,帮助说明如果采取不同策略可能产生的后果,这种方法更加贴近人类的思考习惯,应用潜力巨大。

结合生成式模型的技术为反事实解释提供了强大支持,使其更加具体生动。 可解释性不仅仅是算法设计的重要目标,也成为智能系统安全保障的关键环节。通过明晰策略背后的决策逻辑,可以及时发现潜在风险和漏洞,增强系统对异常情况的应对能力,保障应用环境的稳定运行。 展望未来,XRL的发展将进一步融合认知科学、因果推断及符号人工智能等多学科知识,实现更深层次的理解和交互。随着硬件性能提升和大数据积累,解释模型的实时性和适应性也将显著增强,推动智能体在更复杂动态环境中的自适应表现。 总结来看,可解释强化学习作为人工智能领域的重要前沿,不仅在理论研究层面备受关注,更因其在实际应用中的巨大潜能而快速发展。

丰富的资源和不断涌现的创新研究不断推动该领域走向成熟。通过持续探索和完善,未来XRL有望实现智能系统决策的全透明化,为构建可信赖、安全、高效的智能社会提供强大支撑。