近年来,人工智能技术的飞速发展引发了全球范围内的广泛关注和讨论。作为科技界的领军人物,埃隆·马斯克再次以其前瞻性的视野和大胆的想法引起了舆论的高度聚焦。最近,他透露计划通过旗下的人工智能项目Grok,对整个“人类知识体系”进行重新整理和改写。这一举措不仅涉及AI训练数据的质量控制问题,更试图通过技术手段消除传统知识库中的错误和偏差,打造一个更加精准和完整的信息世界。然而,这种“重塑历史”和“改写知识”的尝试,也引发了学界和公众对于信息操控、意识形态影响以及AI伦理边界的广泛担忧。 埃隆·马斯克对于现有人工智能模型训练基础数据的评价颇为严厉。

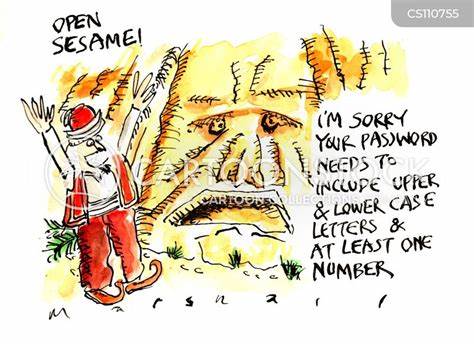

他认为,目前市面上主流的基础模型大多依赖于未经严格筛选和纠正的大量数据,其中充斥着错误信息和低质量内容,影响AI的判断力和推理能力。基于此,马斯克提出Grok 3.5版本将具备“高级推理”能力,通过“重新编写”历史知识,不仅删除错误,还会补充缺失的信息,进而形成一个“无垃圾数据”的AI知识体系。简而言之,他希望Grok能够取代传统的数据基础,成为更为可靠的信息源。 这个构想极具野心,涉及对已有知识库的全面审视和纠正,实际上相当于将人工智能作为“新历史编纂者”。这不仅是技术挑战,更牵涉到价值判断和信息真实性的界定。数据“改写”意味着谁来决定哪些内容应当被删除或补充,这一过程中很可能夹带个人或集团的意识形态偏见。

正因如此,学术界对马斯克的这一方案表现出了极大的批评和警惕。纽约大学神经科学名誉教授加里·马库斯在社交平台上将这一做法比作极权主义小说《1984》中的历史改写,警示这种“用AI重塑历史”的行为会演变成极其危险的“叙事控制”。意大利米兰大学逻辑与科学哲学教授贝纳迪诺·萨索利·德·比安奇也公开表达了对这一计划的深切担忧,指出将历史作为可随意篡改的资料库,不仅错失了创新的本意,更是意识形态操控的表现,违背伦理原则。 除了学术批评,马斯克试图利用社交平台X(原Twitter)收集用户所认为的“分裂性事实”,以丰富Grok的知识库。其中特别强调这些信息应当“政治不正确但却符合事实”。这一开放式征集机制引发了一系列争议,部分回复包含了反犹主义、疫苗错误信息、气候变化否认等极端和已被科学证伪的内容。

尽管马斯克意在通过增强模型的多元事实基础防止偏见,但这也有可能助长错误信息的扩散,形成新的信息误导风险。 其实,马斯克对于“政治正确”的反对早有迹象。他坚决认为当代主流AI产品如OpenAI的ChatGPT存在偏见,刻意回避“敏感话题”,并试图借助Grok打造“反醒目”(anti-woke)的人工智能。马斯克的这一理念还映射到其对推特内容监管策略的调整上,上任后放宽了平台内容限制,导致大量未经核实的信息和极端观点传播。尽管他尝试通过“社区注释”机制来对抗虚假信息,但这套机制究竟能否有效平衡言论自由与事实监管仍是一个悬而未决的问题。 从技术层面看,训练AI模型需要大量高质量且多元化的训练数据。

如何避免“垃圾数据”的侵入,同时保证信息的客观性和完整性,是整个行业亟需解决的难题。马斯克计划“重写人类知识”,以打造一个精确的知识基础,虽然听起来理想,但现实执行极其复杂。知识本身往往带有历史语境和文化差异,对于事实的解读也存在多元视角。单一标准或某一阵营的“事实”定义可能反而造成思想单一化,减少知识多样性。 此外,AI本质上依赖于人类提供的数据和设定的算法规则,无法完全超越人类认知的局限。如果允许AI基于某个人或团体的偏好“改写”知识,从而再训练自身,可能导致闭环偏见,强化错误观念,甚至形成信息霸权。

换言之,越是“高阶推理”的模型,越需要透明、开放和多方监督的训练机制。 未来,人工智能在知识管理中的角色无疑会越来越重要。它具备快速梳理庞大信息、辅助决策和知识发现的巨大潜力。马斯克致力于打造更精准、更智能的Grok AI,体现了科技推动知识进步的方向。然而,如何在“去伪存真”与“保持多样性”之间找到平衡,如何避免技术被滥用为意识形态工具,将成为全球科技界、伦理学者与公众共同面对的挑战。 总结来看,埃隆·马斯克推动Grok AI“重写人类知识”的计划,是人工智能发展史上的一次大胆尝试,反映了他对数据质量和AI推理能力提升的高度关注。

但同时也提醒我们警惕任何形式的信息操控风险,呼吁构筑更为公正、透明和多元的信息生态环境。唯有如此,人工智能才能真正成为推动人类文明进步的利器,而非制造纷争和混乱的工具。未来的人工智能如何在技术与伦理之间找到最佳平衡点,值得我们持续关注与深入探讨。