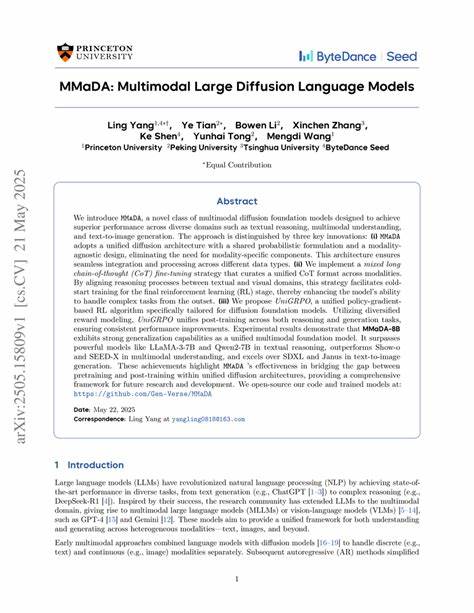

近年来,人工智能领域的语言模型和多模态模型取得了长足进步,尤其是在自然语言处理和视觉语言融合方面。传统上,绝大多数大型语言模型采用自回归(autoregressive)生成方式,令生成过程呈现序列化且逐步输出的特点,既耗费时间又限制了可控性。而离散扩散模型(Discrete Diffusion Models)的出现,为解决这些瓶颈提供了崭新的视角。离散扩散模型不同于传统的自回归模型,其核心优势在于通过多标记并行解码和全注意力机制实现基于去噪的生成策略。这种策略不仅使生成过程能够大幅提升并行度,实现推理加速,还带来了更细粒度的输出控制与动态感知能力。正是这一系列突破,让离散扩散大语言模型(dLLMs)和离散扩散多模态语言模型(dMLLMs)成为了研究界和工业界关注的热点。

研究显示,离散扩散模型在保持生成质量与准确度的同时,其推理速度可达到传统自回归模型的十倍之多,大大提高了实际应用中的响应效率。尤其在需要快速交互与复杂多模态数据融合时,这种模型展现出明显优势。除了速度优势,离散扩散模型的生成过程还具有固有的鲁棒性和灵活性。它通过从带噪声的输入逐步去噪恢复目标输出,使模型对输入的噪声和缺失信息具备较强容错性。此外,该去噪生成的机制使输出结果更容易进行细粒度控制,用户能够规范生成内容的范围和风格,提升定制化应用体验。离散扩散在多模态领域的应用亦极具潜力,尤其在视觉与语言的融合任务中表现出色。

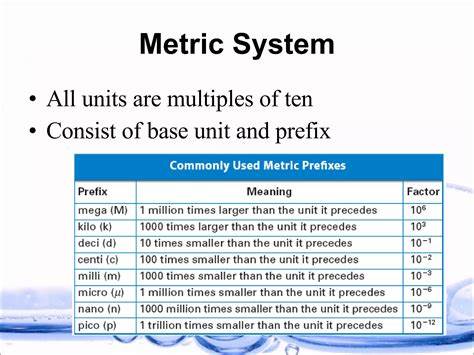

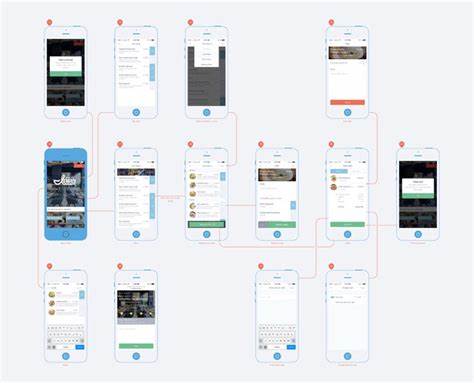

多模态模型不仅需要理解语言文本,还需解析图像、视频等多样化信息,通过离散扩散的并行化编码,模型能够更高效地处理跨模态信息,提升场景理解和生成表现。这为智能客服、虚拟助理、内容创作以及医疗诊断等领域带来了全新契机。从技术角度来看,离散扩散模型的发展经历了系统而快速的演进。研究人员在模型的数学框架构建、训练优化、推理算法以及量化技术等方面不断突破。其数学基础源于扩散概率模型,通过构造将粗糙或杂乱信号逐渐转化为清晰表达的随机过程,实现从噪声到样本的逆向生成。训练过程通常基于变分推断框架,结合多步去噪目标引导模型学习高质量映射。

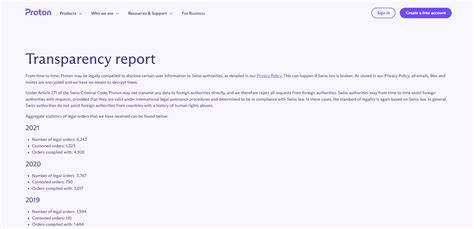

推理阶段,离散扩散模型采用全局注意力机制,使得多标记可以并行处理,显著缩短生成时间。量化技术的引入则优化了模型的存储和运算效率,保障实际部署中资源占用的可控性。与此并行的是在安全性和可信赖性方面的深入探讨。离散扩散模型因其黑盒特性,带来一定的解释难度和潜在的偏见风险。为此,研究者致力于透明度提升与偏见控制机制的设计,确保生成内容合规且符合伦理规范。同时,针对模型输出的多样性与一致性平衡,是当前的重要研究课题之一。

产业界也在积极推动离散扩散模型的应用落地,多家顶尖科技公司和研究机构已经发布了自研的工业规模dLLMs和dMLLMs开源项目。通过大规模语料库训练,这些模型呈现出媲美甚至超越部分自回归模型的性能指标,在机器翻译、文本摘要、对话系统以及图文生成等多个应用场景均取得良好效果。此外,离散扩散模型在生物信息学领域的应用日益受到关注。复杂的分子结构预测和蛋白质折叠问题,也可借助该类模型的多模态融合能力,提升计算效率和预测准确性,推动精准医疗和药物研发进程。未来,离散扩散模型有望进一步突破技术瓶颈。从模型结构设计角度,将融合更多创新的注意力机制和自监督学习策略,提升对长程依赖和语义理解的表现。

在训练算法方面,探索更加高效的优化方法,缩短训练周期,降低能耗。推理速度和鲁棒性的双重提升,将帮助离散扩散模型实现广泛工业部署。同时,伦理与法规框架的完善,将为离散扩散技术的安全应用提供保障,促进其健康发展。总结来说,离散扩散模型作为大型语言和多模态模型的关键发展方向,凭借其独特的并行解码和去噪生成机制,显著突破了传统自回归模型的性能限制。它不仅带来了效率与质量的双重提升,更为多模态融合、细粒度控制和动态感知打开了新天地。伴随着算法创新与应用扩展,离散扩散模型必将在未来人工智能技术生态中扮演愈发重要的角色,推动整个行业迈向更加智能、高效和多样化的新时代。

。