随着人工智能技术的快速进步,越来越多的科技公司纷纷推出各种基于 AI 的聊天机器人,为用户提供智能化的咨询和交流服务。Meta(前 Facebook)作为全球社交媒体巨头,也在2025年4月推出了其 AI 应用平台,尤其引人关注的是其中的“发现”功能(Discover Feed)。这一功能允许用户公开分享他们与 AI 聊天机器人的对话,为社交互动增添新维度。然而,正是这一设计引发了广泛的隐私和安全忧虑。Meta AI 应用的“发现”页汇集了大量用户查询记录,涉及医疗、法律、个人生活等敏感话题,甚至包括地理位置、电话号码和真实姓名等隐私信息。对于许多普通用户来说,他们似乎并未充分意识到自己在与 AI 互动时所分享的信息可能被公开展示并被他人看到。

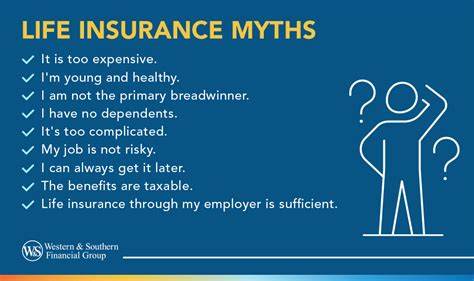

透过一个简单的滚动操作,用户即可浏览到众多原本表现为私人对话的内容。部分信息呈现出高度个人化的特质,比如有用户询问关于如何撰写租赁终止通知,另有用户讨论涉及个人家庭成员的法律纠纷,甚至有向 AI 求助撰写法庭角色陈述等内容。这些内容往往与线上公开的 Instagram 账户或资料相绑定,进一步扩大了隐私泄露的范围和风险。隐私保护团体如电子隐私信息中心(EPIC)的高级法律顾问 Calli Schroeder 指出,这类现象令人极为担忧。她透露,已有用户公开分享了医疗状况、心理健康信息、具体家庭住址,甚至与法院案件相关的细节,反映出用户对 AI 聊天平台隐私性质的误解。 她强调普通用户往往误以为与 AI 的对话是私密的,忽视了信息可能被广泛传播的现实。

虽然 Meta 官方声明“聊天内容默认不公开,用户需主动选择分享后才会出现在发现页”,但在实际操作中,许多用户似乎并未完全理解这一多步骤的分享流程,导致大量敏感内容无意间“暴露”。Meta 发言人也表示,公司已提供相关工具帮助用户管理隐私设置并且持续努力改善,但仍难以消除公众对于个人数据安全的担忧。值得注意的是,这种设计模式与其他平台的私密聊天截然不同。传统的聊天应用一般都将对话视为严密保密的信息,除非用户明确发布或转发。而 Meta AI 应用将聊天内容作为“分享品”鼓励用户展示,这种社交化与 AI 交互内容的结合,使得隐私保护难度剧增。用户在寻求法律、医疗等专业建议时,往往会在问题中透露大量详细身份信息,方便 AI 更好理解场景并给予针对性回答,但这也无形中放大了隐私风险。

Meta AI 的设计初衷是通过记忆用户先前提供的资料为后续互动提供个性化体验,这一点虽然增强了服务质量,但也可能助长个人信息的长期存储和分析。社交媒体上的信息关联问题也随之浮现,许多账号背后的公开资料可以通过对话内容快速匹配,结果是不少原本指望匿名保护的用户身份疑似被披露。与此同时,AI 应用的普及引发了更广泛的社会关注与反思。许多专家指出,公众在使用任何与人工智能相关的产品时,都需要具备更高的隐私意识和防范技能。Meta AI 应用事件成为一次典型案例,提醒人们技术便利的另一面——信息安全和个人隐私保护不可忽视。数字时代下,人们必须明白输入的信息很少是“绝对私密”的,企业如何存储、使用,甚至分享这些数据都可能存在不透明和风险。

特别是涉及医疗和法律领域的对话,若遭泄露,可能直接影响个人生活安全和社会地位。国际上,关于 AI 隐私保护的法规尚处于摸索和完善阶段,很多国家政府和监管机构已开始关注这些新兴问题,但具体执行和规范的落地仍存在时滞。Meta AI 事件无疑给相关立法和企业自律敲响了警钟。针对这一现象,用户应当理性审视人工智能平台的隐私政策,避免在公开渠道输入过多敏感信息。同时,优先选择那些隐私保护更为严格、能够清晰告知数据用途和分享规则的产品。Meta 平台若想赢得用户信任,需要加强对隐私的保护机制,简化隐私设置流程,并提高用户教育力度,帮助人们认识到分享的风险和选择。

专家建议企业应引入更多技术手段,如对敏感信息的自动识别和屏蔽机制,减少潜在泄露概率。技术层面,结合隐私计算、多方安全计算等前沿技术也或将带来突破。总之,Meta AI 应用“发现”功能暴露了当前人工智能与隐私保护领域的多重矛盾。它既展示了 AI 在用户互动体验上的优势,也暴露了对用户信息安全保护的不足。随着人工智能技术深入我们生活的方方面面,如何在方便快捷与隐私安全之间找到最佳平衡,是各方亟待解决的课题。科技公司、用户和监管机构需共同努力,提高数字素养,完善制度机制,才能真正实现数据信息的安全利用与保护,确保人工智能应用的健康可持续发展。

。