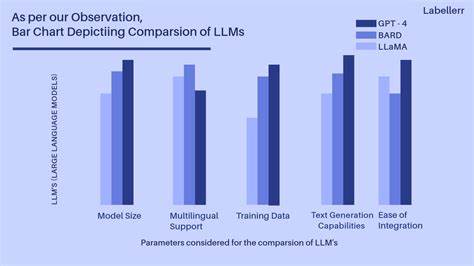

随着人工智能技术的迅猛发展,大语言模型(LLM)在各行各业的应用越来越广泛,推动着自动化、自然语言理解和生成技术的进步。然而,如何以最合理的成本获得最佳的模型性能,成为许多企业和开发者关注的焦点。面对众多服务提供商和不断变化的价格体系,选择最优方案显得尤为重要。本文将深入探讨一种创新的推理路由技术,能够在速度、延迟和价格之间实现实时竞争,从而为用户带来最优的性价比体验。如今,大语言模型服务提供商众多,每家的定价和性能表现都有差异。部分开放模型如开源框架,通常通过计算资源消耗计费,而闭源模型则可能采用固定费用策略。

传统方式下,用户需要手动评估多方供应商,难以实时调整和优化调用策略,造成资源浪费或性能瓶颈。为解决这一问题,一种名为推理路由器的创新方案应运而生。这种技术能够连接多个大语言模型服务提供商,通过智能算法实时判断每次调用的最佳方案。推理路由器不断监测各服务的处理速度、响应延迟以及调用价格,根据实际情况动态选择最优路径,从而最大程度地节省开支并提升调用体验。实现这一功能的关键在于对多家API接口的标准化处理。不同供应商的接口规范和返回数据格式存在差异,推理路由器需要对这些异构数据进行整合,确保无缝调用。

此外,针对带工具调用的复杂场景,还需设计高效的工具调用管理机制,保障多步骤推理流程顺畅执行。另一个重要特性是提示词缓存管理。由于对话模型的提示词经常重复或具有相似性,合理缓存与复用这些内容能显著降低调用次数和响应时间。推理路由器通过智能缓存策略,减少冗余计算,进一步提高执行效率。目前,这种推理路由器技术已成功集成在多种环境中运行,包括基于Roo和Cline的开源项目分支,以及支持OpenAI兼容的自行携带密钥(BYOK)应用,实现了跨平台适配。这意味着无论是使用公网API,还是内部部署环境,都能享受到实时最优的推理路径选择。

面对实际应用,推理路由器的优势尤为明显。企业在面对海量自然语言任务时,可以依据需求灵活分配硬件资源,降低运行成本;同时,用户体验得到保障,延迟降低,响应速度提升。通过动态价格与性能的比较,避免了潜在的性能瓶颈或昂贵的呼叫支出。此外,这种方案对于不断涌现的新供应商和模型体系具有良好的适应性。随着新模型的发布和价格调整,系统能够及时调整路由策略,无需人工干预,实现长期智能优化。未来,随着大语言模型技术的深化发展,推理路由器将进一步融合自动调参、任务分级和多模型协同推理,提供更为精准和灵活的调用体验。

结合边缘计算和分布式AI基础设施,用户能够在更广泛的环境下享受成本效益极高的智能服务。同时,随着隐私保护法规的日益严格,推理路由器在处理敏感数据时也将提供多层安全保障,支持私有部署和加密计算等技术,确保数据安全和合规运营。总而言之,在多样化的模型服务生态中,智能推理路由技术为获得最佳性能和合理预算提供了极具创新性的解决方案。企业和开发者应关注并探索该技术,合理整合多源模型资源,开启大语言模型应用的新篇章。通过实时竞价与性能优化,可以在激烈的市场竞争中占据优势,实现效能与成本的双重提升。这样,无论是创业团队还是大型企业,都能以最小投入获得最大回报,推动人工智能技术向更普惠、更高效的方向发展。

。