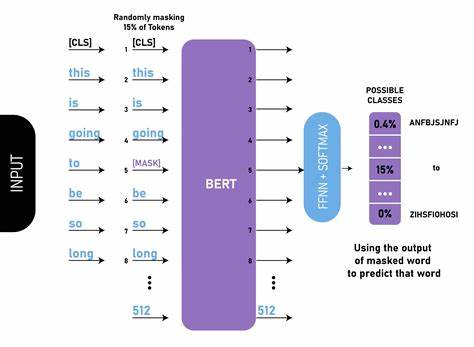

随着人工智能技术的飞速发展,Transformer架构已经成为自然语言处理领域的核心。然而,传统的自注意力机制由于计算复杂度随序列长度二次方增长,极大限制了模型对长上下文的处理能力和推理速度。为此,研究者不断探索更高效的注意力实现方式。在众多创新中,PowerRetention作为一种新兴的线性复杂度注意力机制,凭借其独特的结构和算法优势,成功成为了FlashAttention的有力替代方案。PowerRetention不仅在理论层面突破了传统注意力机制的瓶颈,同时在实际应用中展现出卓越的性能表现,尤其适配现代GPU架构,极大提升了训练与推理的效率。PowerRetention是由Manifest AI开发的PyTorch层,实现了所谓的"功率保留"(Power Retention)注意力机制。

该机制通过对历史上下文进行有效压缩和状态维护,避免了长序列处理时内存和计算资源的爆炸增长,达到了线性复杂度的目标。其核心优势在于状态大小可以独立于上下文长度和参数数量控制,大幅提高了模型的计算效率。传统的自注意力中,序列长度直接导致矩阵的二次方复杂度,长序列输入时计算量极为庞大,资源消耗和延迟显著增加。PowerRetention通过"chunked"分块算法实现线性扩展,计算流程被合理划分为可并行的小块,极大降低了资源瓶颈。这种方案不仅兼容多头注意力机制和旋转位置编码(rotary embeddings),还能利用针对NVIDIA A100 GPU优化的CUDA内核实现FP16和BF16的高性能计算。PowerRetention的安装和使用过程也非常便利。

对于Linux环境中的Python开发者而言,推荐通过pip直接安装官方包,无需复杂配置。依赖的PyTorch和Ninja构建系统会自动携带,令用户可以快速上手。在训练阶段,PowerRetention的设计保证了与常规模型端到端兼容,通过调用power_retention函数即可完成对查询(Q)、键(K)、值(V)张量的操作,同时支持可选的门控张量提升模型表达力。利用合理的power参数和chunk大小,模型在多样的FLOPs预算下都能达到更低的困惑度(perplexity),体现了更优秀的语言建模能力。推理方面,类似于Transformer的KV缓存,PowerRetention实现了常数时间的token生成机制。通过power_retention_inference函数,模型可以在不随着上下文长度增长的情况下更新状态和归一化因子,避免了推理过程中的显著性能下降。

此项技术极大促进了超长文本生成任务的速度与稳定性。在具体集成层面,PowerRetention能够作为标准自注意力层的无缝替代品嵌入各种Transformer架构。项目内置了完整的GPT样例,示范如何在前向传播函数中调用power_retention实现改写,同时保留了传统的参数定义和模型结构。对于研究者和工程师而言,这为快速验证并应用该技术提供了坚实基础。开发者社区针对PowerRetention的优化也持续进行中。项目采用开源协议,鼓励贡献代码、改进文档和性能测试。

其配套的测试套件和基准性能测试确保改动不会影响模型准确度及运算效率,同时及时反馈各类优化潜力。此外,相较于FlashAttention,PowerRetention具有更灵活的状态管理机制。FlashAttention虽然有效减少了注意力计算中的内存访问次数,但其仍受限于上下文长度增长带来的KV缓存扩展;PowerRetention通过动态状态更新和归一化处理,实现了对大型上下文的高效处理和存储管理,大幅降低了显存占用。技术原理上,PowerRetention借鉴并扩展了"Scaling Context Requires Rethinking Attention"一文提出的思想。通过对注意力矩阵的权重进行幂次保留,模型能够重点关注关键上下文信息,而非平均分配注意力权重,从而提升语义捕获能力和长程依赖效果。这种设计不仅保证了模型泛化性能,还兼顾计算经济性。

未来,PowerRetention有望广泛应用于超大规模语言模型、图像-文本融合模型以及强化学习策略网络等多个领域。在应对海量数据和复杂多样任务时,其高效扩展性和灵活状态管理能力将成为关键竞争力。同时,随着硬件生态的进化,PowerRetention的硬件适配和混合精度计算策略将进一步助推AI算力的发展。综上所述,PowerRetention以其创新的线性注意力机制和卓越的性能表现,为Transformer架构中的注意力瓶颈提供了有效解决方案。通过简洁易用的API设计和开源生态,推动了高效深度学习模型的研究和工业应用。对于追求长上下文建模能力和低延迟推理的开发者而言,PowerRetention无疑是值得关注和尝试的重要工具。

随着该技术的不断成熟,未来在AI大模型领域的影响力和普及度将持续攀升。 。