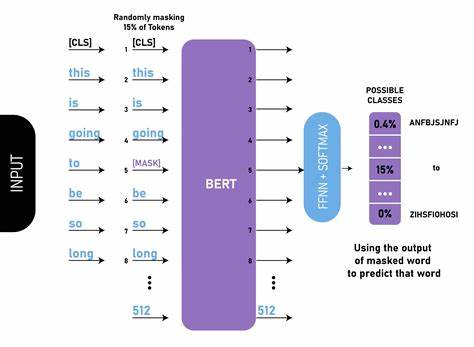

近年来,随着人工智能的快速发展,语言模型的能力得到了极大提升,尤其是在上下文学习和任务推理方面展现了出色的表现。人们惊叹这些模型能够根据指令或示例及时理解并执行全新的任务,而无需对模型权重进行额外更新。核心于这一能力的关键在于语言模型如何在处理过程中形成和演化任务表示。深入研究这些任务表示的特性,不仅有助于理解当前语言模型的工作机制,也为未来设计更高效、更智能的模型提供理论支持和实践指导。 语言模型的任务表示主要可分为两类:一种是"可迁移"的向量化任务表示,另一种是更为简化的高层任务类别表示。可迁移任务表示能够在不依赖完整提示的情况下,将任务信息传递到其他模型实例中,实现跨模型的任务理解和执行。

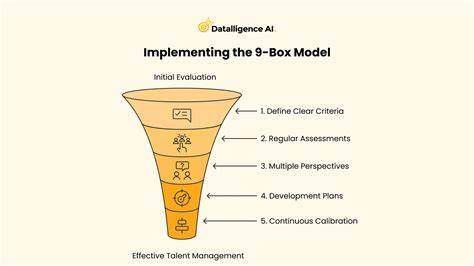

这种表示形式具有高度的抽象和紧致特性,便于模型即时调用和调整。而高层任务类别表示则反映了语言模型对任务身份的持续辨识能力,无论上下文的进展如何,这类表示始终稳定存在,确保对任务性质的持久感知。 研究显示,可迁移任务表示的演化并非线性和连续的,而是呈现非单调且间歇性的动态变化。这种变化具有双重时空局部性,首先在时间维度上表现明显:当语言模型接收更多示例时,可迁移表示往往在特定的上下文标记处"激活"或"上线",而不是均匀分布于整个输入序列中。这意味着模型并非随时随地对任务内容进行持续整合,而是在关键节点集中提炼和概括任务信息,达到信息汇聚的高效效果。 其次,在语义维度上,也能观察到任务表示的局部化趋势。

模型往往能够针对特定子任务或任务范围构建独立的语义表示,实现对复杂任务的模块化分解。这种机制类似人类在处理复杂任务时,将其拆分成若干独立且较为简单的小任务,从而逐步推进整体目标的完成。通过分布式表示,语言模型实现了对任务的灵活覆盖和精确切割,增强了在多任务环境中的应对能力。 对即时任务表示的理解与分析,揭示了语言模型如何在上下文的"即时"构建任务认知。这种即时性不仅使模型能够快速响应输入,更重要的是其展现出的策略性 - - 在必要时才激活详细的任务表征,避免无谓的计算开销,体现了计算资源的合理利用。此外,这种动态构建的过程助力模型更好地进行推理和语义整合,增强了生成结果的相关性和准确度。

语言模型中任务身份的持续表示,则提供了稳定的任务框架,使得模型始终保持对任务性质的理解,不被上下文中的噪音或偏移影响。这种持续性为复杂的上下文对话和多轮交互提供了理论保障,确保模型在长时间的对话中不会丧失对任务目标的聚焦。同时,任务身份的明确标签也为未来任务迁移和多模型协作打下基础。 在实际应用层面,这种融合了即时和分布式任务表示的机制为自然语言处理带来了诸多创新。比如在对话系统中,模型能够根据对话上下文灵活调整对任务的理解,及时处理用户的多样化请求。在文本生成和翻译领域,模型能够精准捕捉当前任务要素,优化语言流畅度与语义一致性。

在少样本学习和零样本推断中,通过有效的任务表示,模型可以实现对未知任务的快速适应和高质量输出。 随着研究的深入,未来语言模型可能会进一步强化这两类任务表示的协同工作,实现更为智能和高效的任务处理流程。如何提升可迁移任务表示的泛化能力,扩大任务表示的语义覆盖范围,同时保持任务身份的稳健性,将是关键挑战之一。同时,结合多模态信息和增强学习机制,语言模型的任务表示有望跨越单纯的文本理解,迈向更广泛的感知和决策支持领域。 此外,理解语言模型任务表示的动态特征也助力构建解释性更强的人工智能系统。通过可视化任务表示的时空演化轨迹,研究人员和开发者能够更直观地把握模型决策的逻辑,确保模型行为的透明度和可控性。

这对提升用户信任和安全使用具有重要意义。 总之,即时与分布式任务表示作为语言模型任务处理机制的核心组成部分,深刻影响了模型对新任务的感知、理解和执行方式。它们不仅是实现强大上下文学习能力的基础,也是推动自然语言处理技术迈向更高层次的重要突破点。未来,伴随着理论与实践的不断进步,语言模型将在任务表示的创新中展现出更为卓越的智能水平,助力人类在复杂信息环境中的高效沟通与协作。 。