随着人工智能和机器学习领域的飞速发展,表示学习作为构建智能系统基础的关键技术,正面临更高效、更稳定的训练需求。传统的表示学习方法虽然已经取得了诸多突破,但在处理大规模数据和复杂模型时依然存在计算资源消耗大、收敛速度慢等瓶颈。近期,研究者Anthony D. Martin提出的递归KL散度优化(RKDO)方法,凭借其独特的动态优化框架,有望彻底改变表示学习的训练范式,实现训练效率提升60%至80%的革命性飞跃。递归KL散度优化不仅在理论上扩展了现有学习目标的定义,更在实验证明了其卓越表现,为资源受限的应用场景提供了新的可能。要全面理解RKDO的创新意义,首先需要回顾表示学习和KL散度的基本概念。表示学习旨在从原始数据中自动提取有意义的特征表示,以便后续的分类、聚类或生成任务更高效地执行。

当前主流方法多基于对比学习、聚类或降维技术,而这些方法在训练过程中常借助KL散度(一种衡量两个概率分布差异的指标)来优化模型参数。现有信息对比学习(Information Contrastive Learning)等框架,更将目标转化为固定邻域条件分布之间的KL散度最小化,这一方法虽然统一了多种学习模式,但在递归性结构的表现上仍有不足。递归KL散度优化的突破之处在于将表示学习重新定义为KL散度在数据局部邻域上的动态演化过程,而非静态目标优化。这种动态框架允许模型在训练过程中递归地调整分布之间的关系,实现更高阶、更细粒度的表示对齐。换言之,RKDO能够捕捉到数据结构变化和模型适应过程中的连续动态,提升模型稳定性并促进局部适应能力。通过这种递归机制,RKDO不仅统一了对比学习、聚类和降维方法的本质,还赋予了训练过程更强的灵活性和效率。

实验结果显示,RKDO在包括图像、文本和时间序列等多种数据集上均取得了显著优势。相比传统静态优化方法,其最终损失值平均降低了约30%,而在达到相同性能标准时所需的计算资源乃至时间却减少了60%至80%。这种效率的提升对于大规模深度学习模型而言,意味着极大的成本节约和训练周期缩短,从而推动了模型研发和应用的广泛普及。在实际应用层面,RKDO的低资源需求尤其适合边缘计算、移动设备和其他算力受限的环境。随着智能设备普及,如何在有限硬件条件下实现高效、准确的表示学习成为关键。RKDO为这些场景提供了切实可行的解决方案,帮助开发者在保证模型性能的同时显著减少运算能耗。

此外,RKDO框架天然具备良好的扩展性。其递归优化机制可兼容多种数据类型和任务范式,支持未来融合更多先进技术如自监督学习、多模态融合等。可以预见,RKDO将在图像识别、自然语言处理、推荐系统及医疗诊断等领域产生深远影响。理论与实践相结合,RKDO还开启了表示学习研究的新方向。通过重新审视KL散度的动态演化过程,学界将更深入探索信息流动和知识提炼的本质机理。未来有望引入更多数学工具和优化算法,进一步提升训练效率与模型泛化能力。

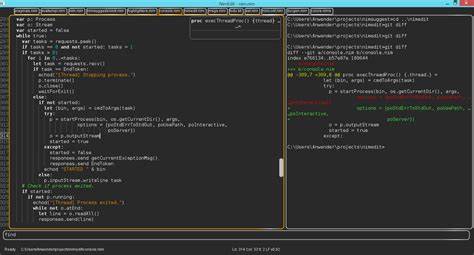

同时,RKDO的开源实现和文档在GitHub平台已积极维护,为研究人员和工程师提供了便利的使用和二次开发环境。总结来看,递归KL散度优化(RKDO)突破了传统静态优化方法的局限,凭借对数据局部条件分布KL散度的递归动态更新,实现了表示学习训练效率的质变式提升。其在降低训练资源消耗、加速模型收敛及增强适应性方面表现突出,符合未来人工智能高效、绿色发展的趋势。随着相关理论研究和应用实践不断深入,RKDO有望成为表示学习领域乃至整个机器学习社区的重要基石,助力智能技术走向更广泛和深入的应用前景。