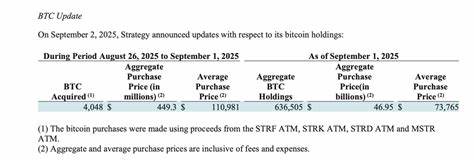

近年来,人工智能技术尤为是大规模语言模型(LLM)逐渐成为企业招聘过程中不可或缺的工具。许多企业依赖AI系统对海量简历进行快速筛选,以提高招聘效率。然而,最新研究表明,使用与招聘AI同一模型生成的简历相比,人工撰写或由其他模型生成的求职材料在筛选中处于明显劣势。同一AI模型在评估具有类似风格的文本时似乎表现出"自偏好"现象,即优先青睐来源于自身输出的简历内容。该现象不仅影响着招聘公平性,也在一定程度上加剧了数字鸿沟和就业歧视问题。根据马里兰大学、国立新加坡大学和俄亥俄州立大学学者的联合研究,通过对2245份人类撰写的简历和多款主流AI模型(包括OpenAI的GPT-4o及GPT-4o-mini、GPT-4-turbo、LLaMA 3.3-70B等)生成的简历进行模拟评估,结果显示这些语言模型对自身产出的简历表现出高达68%至88%的偏好比例,尤其在商业领域,如销售和会计行业尤为明显。

研究指出,求职者如果选用了与企业招聘AI相同的语言模型辅助制作简历,入选面试的机会可提升23%至60%,这意味着公平竞争环境被潜在破坏。简历作为第一道筛选关卡,本应公正反映候选人能力和经验,但当算法偏好自家生成内容时,便产生了无形的"算法歧视",尽管这并非刻意为之,而是系统在设计与训练过程中的隐性结果。此类偏差对求职者而言极具挑战性:一方面,普通求职者可能因缺乏使用特定AI工具的资源或能力而难以与使用先进AI工具的竞争者平起平坐;另一方面,传统人类撰写的简历反而被低估,导致隐藏许多有潜力人才。研究者提出,根治这一问题需从AI系统设计入手,具体方法包括调整模型的系统提示,迫使其忽略简历的来源,专注于内容本身的质量与相关性,这一策略可将偏好度从90%以上降至接近中性水平的50%。另外,招聘过程中引入多个不同模型的评估机制也能有效冲淡单一模型的自偏好影响,从而提升整体公正性。然而,这些调整也伴随着复杂的权衡。

在教育或新闻等领域,识别AI生成内容具有重要意义,保障透明度与责任性;而在招聘场景,降低模型自我识别能力促进公平评估。因此,针对不同应用背景应制定差异化方案。AI招聘的广泛采用,使得"AI对AI"的互动日益频繁,如何设计和部署具备环境敏感性的系统成为当务之急。企业应关注算法公平性,积极采取多模型审核、参数调校等技术手段,减少潜在偏见。监管机构和行业联盟也需加强标准制定与监督,确保AI技术在招聘中发挥积极作用,同时避免加剧社会不平等。对于求职者而言,掌握并合理利用主流AI工具已成为提升竞争力的关键。

此外,增强对AI技术及其偏差的认识,有助于避免因技术误用而产生不必要的困境。总的来看,AI在招聘领域的应用不可逆转,它既带来了前所未有的效率和规模,也带来了前所未知的公平挑战。只有通过多方协作,结合技术创新和政策引导,才能构建透明、公正且包容的数字招聘生态,真正实现技术赋能和人才公平流动的目标。 。