导语 近年来关于网络内容监管的讨论愈发激烈,从社交媒体上的仇恨言论到针对选举的虚假信息,再到生成式人工智能带来的深度伪造风险,如何管理数字公共领域成为公共政策的核心议题。多国民调显示,尽管公众普遍希望遏制虚假信息与有害内容,但大多数人更倾向于由平台公司负责制定内容政策,而非把话语权交给政府。理解这一偏好有助于设计更符合民意且具操作性的治理方案。 公众取向的实证基础与表面悖论 跨国调查表明,在美国、英国、德国、巴西、西班牙、阿根廷、日本和韩国等样本中,多数受访者认为社交网络、视频网站、搜索引擎与即时通讯工具等平台应对其内容政策负主要责任。与此同时,绝大多数人也认为平台应对用户发布的虚假信息承担更大责任。乍看之下这是矛盾的:为什么公众既不愿政府主导规则制定,又希望平台负更大责任?关键在于公众对不同治理主体的信任、对效率与偏见的权衡、以及对言论自由与公共安全之间边界的敏感。

为何公众倾向于平台自律 对政府的不信任是核心原因之一。在很多国家,公众普遍认为政府本身在信息传播、舆论引导上存在既得利益和政治动机,担心政府介入内容监管会被用于限制异见或打压政治对手。相比之下,平台作为私人主体,更容易被视为中立或至少技术性更强的管理者。其次,平台拥有即时处置能力和技术优势,从大规模数据检测到算法排序,具备比政府更高的响应速度与操作灵活性。第三,公众往往对技术解决方案抱有一定期待,认为平台能通过算法优化、事实查核与社区治理实现较为专业的内容管理。 针对新兴技术,公众偏好出现分化。

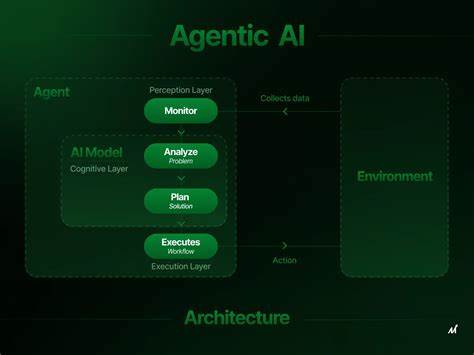

以生成式AI为例,许多人对AI生成内容的潜在风险不确定,担忧其对事实界限的冲击,因此更倾向于政府介入或制定明确规则。这反映了在技术熟悉度与风险认知不足时,公众对监管主体的偏好会变得更加谨慎。 平台自律的优势与现实局限 平台自律的主要优势包括快速反应能力、产品层面的迭代与优化空间、以及与用户互动的直接通道。平台能够部署自动化检测、自然语言处理与图像识别技术以识别并下架显性违法或明显有害的内容,还能在用户体验层面设计提示、限制转发或降低传播权重。这些技术手段在面对海量内容时,效率显著优于传统的行政执法机构。 然而,平台自律也面临多重制约。

商业利益会影响内容治理的选择,过度依赖广告与流量的商业模式可能使平台在限制吸引眼球的极端内容时犹豫。算法放大效应可能无意间加剧极端或虚假的信息传播。各平台之间缺乏统一标准,规则碎片化导致跨平台治理困难。更重要的是,私营公司的规则制定缺少透明性和公开问责机制,用户难以获得清晰的申诉与救济途径。 政府介入的利与弊 政府在保护公共利益、确保法律秩序、设定最低行为红线方面拥有不可替代的角色。通过立法可以明确界定违法内容的范畴与处罚机制,推动行业合规并提供跨域统一标准,这对打击跨国有组织的虚假信息活动尤为重要。

监管还可以通过信息公开、独立审查与司法救济加强对私人平台权力的制衡。 但政府主导内容监管存在明显风险。政治化的规制往往会被用于限制言论自由,尤其在制度不健全的国家更容易出现滥权。行政干预在技术和实施层面也经常效率低下,监管机构缺乏处理海量在线内容的能力与专业人才。此外,硬性法律禁止某些话语时可能导致过度审查,伤害公共讨论空间的多元性。 寻找平衡的治理模式 基于公众对平台自律的偏好与对平台责任的期待,现实中更可行的路径并非二选一,而是构建一种合作型的治理架构。

共治模式可以在法律框架下保留政府的基础性规则与司法救济,同时赋予平台更大的操作空间与技术责任,同时施加透明与问责机制。 首要原则是明确职责与责权对等。法律可以规定平台在识别、下架、提示与阻断明显违法或严重危害性内容时的最低义务,同时为平台提供合理的免责或责任边界,以免扼杀创新。其次是透明性要求,平台应公开内容审查政策、算法推荐规则、自动化工具的运作逻辑与使用场景,并定期发布透明报告,披露违规内容处理数量、申诉结果与误判率。 独立监督机制与外部审计同样至关重要。政府或第三方监管机构可以授权进行合规审查与算法审计,确保平台在执行规则时不偏离法律与公共利益。

事实核查与社区治理应成为治理生态的重要部分:资助独立第三方事实核查组织,支持社区自下而上的内容管理实践,同时建立高效的申诉通道与人工复核机制,缓解自动化误判带来的权利侵害。 对虚假信息的针对性策略 公众对平台应负责虚假信息的诉求高,原因在于虚假内容的社会危害性往往直接且广泛。从流言引发暴力事件到误导选民的宣传,虚假信息能够动员情绪并破坏公共信任。治理虚假信息需区分不同类型的误导内容,并采取分层处置策略。 对明确恶意制造的虚假信息应执行严格惩处,包括下架内容、减少传播优先级、暂停违规账户,以及必要时配合司法调查。对模糊或争议性信息,平台可以标注信息来源、提供事实核查链接或附加上下文说明,以帮助用户形成判断。

针对快速传播的谣言,平台应优先采取限流和提示措施,并配合本地新闻媒体或权威机构迅速发布更正或澄清信息。 算法责任不容忽视。平台应评估推荐与排序机制在放大虚假信息上的风险,采取设计性减缓措施,例如降低低信誉来源的推荐权重、限制仇恨或煽动性内容的曝光优先级。算法透明度与可解释性研究的推进将帮助监管者与公众理解平台如何影响信息传播。 生成式AI与新兴技术的治理难题 生成式AI使得伪造信息的门槛更低,文本、图像、语音与视频皆可被高质量合成,给事实核查带来挑战。公众对AI内容监管的两极化态度反映了对未知风险的担忧。

针对AI生成内容,政策应强调来源可追溯性与水印技术的广泛应用,同时要求模型开发者在训练与发布阶段承担更明确的尽责义务。 此外,应建立跨行业协作机制,推动学术界、技术公司与媒体之间的信息共享与早期预警系统。国际协调尤为重要,因为AI工具与虚假信息传播往往跨越国界。建立通行的技术标准与最佳实践,将有助于降低生成式AI被滥用的概率。 小平台与去中心化平台的挑战 治理策略不能忽视中小型平台与去中心化社区的存在。大型平台有能力投入资源建立合规体系,但中小平台往往人力与资金不足,规则实施难度更高。

去中心化平台或分布式社群则通过技术规避单一责任主体,使传统的监管方式失效。对这类平台,需要探索差异化的合规门槛与支持机制,例如提供技术工具包、建立行业互助基金,或通过激励机制引导其采纳基线治理标准。 公众参与与数字素养提升 治理的长期成功还依赖于公众的数字素养和参与感。仅靠平台与政府并不足以保障信息生态的健康。教育体系与媒体机构应加强对信息甄别能力的培养,鼓励公民在面对信息时采取审慎态度。平台可以将数字素养工具内建于用户界面,提供事实核查提示、来源评分与信源背景介绍,帮助用户在日常使用中形成良好习惯。

政策建议与企业责任 面向未来,政策设计应坚持多元主体参与、风险导向与灵活可执行的原则。政府应制定清晰的最低合规标准并提供执行框架,法律应强调保护言论自由与公共安全的平衡。平台需将治理能力视为企业核心责任,投入透明度建设、第三方审计与人才培养。民间组织、学界与媒体应参与监督与事实核查,共同构建更具韧性的数字公共空间。 结语 公众更偏向由平台而非政府主导内容政策,反映了对政府政治化干预的担忧、对平台技术能力的期待,以及对言论自由保护的敏感性。然而,单纯的自律无法解决所有问题,公众同样期望平台为虚假信息承担责任。

可持续的治理路径应当在法律底线与平台运营灵活性之间找到平衡,通过透明、问责与多方协作,建立既能保护言论多样性又能遏制有害信息的数字生态。未来的治理不会由单一主体完成,而是需要政府、平台、媒体、学界与公众共同参与,合力打造可信赖的在线公共空间。 。