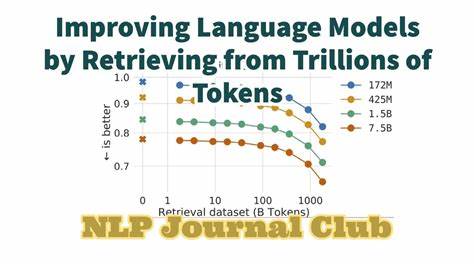

随着人工智能技术的迅猛发展,特别是大型语言模型在自然语言处理领域的卓越表现,提升模型的透明度和可解释性成为业界关注的焦点。OLMoTrace作为一项创新技术应运而生,致力于帮助研究者和开发者追踪语言模型生成文本的来源,直接关联模型输出与其庞大的训练数据集,实现了前所未有的可追溯性。OLMoTrace由Allen Institute for Artificial Intelligence(Ai2)研发,集成在其AI Playground中,支持实时识别并展示模型输出中与训练数据出现过的相同长文本片段,使用户得以窥见模型“记忆”的根源。专为Ai2旗舰模型如OLMo 2 32B Instruct设计,它背后的技术架构涵盖了对数万亿个训练数据标记的高效索引和检索,明显提升了数据匹配的计算效率和规模适应能力。语言模型训练数据量巨大,达到数万亿词元,对这些庞大数据的存储、查询与匹配提出了极为严苛的挑战。OLMoTrace利用了一种革新的索引方式——infini-gram索引,配合并行计算算法,将跨度匹配的时间复杂度从传统的平方级别降至近似线性水平,使得实时分析模型输出成为可能。

它首先对模型文本输出进行分词,并寻找所有满足特定条件的文本跨度,这些跨度必须完整出现于训练数据中,且以逻辑语言单位完整对齐,不被句号或换行符中断。随后,系统以“跨度单词概率”指标对找到的片段进行排序,优先展现稀有且独特的文本,从而剔除大量通用表达和无关内容,显著提升用户关注点的相关性。通过OLMoTrace,用户不仅可以直观观察语言模型在何处“借用”了训练数据中的具体表达,还可以进一步检查训练文档的权威性,为事实核验提供直接依据。例如,当模型输出涉及具体人物、事件或数据时,OLMoTrace能够快速定位训练数据出处,从而厘清模型信息的真实来源。这为诸如新闻报道、学术写作等领域提供了重要工具,有助于防范虚假内容的传播和评估语言模型生成信息的可信度。另一方面,在创意写作和生成任务中,OLMoTrace同样有助于理解模型产出的灵感源泉,追溯其独特辞藻及结构的训练根基。

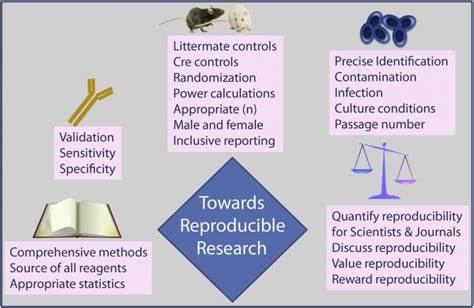

此外,OLMoTrace在数学问题和逻辑推理能力的追踪中也展现了强大效用。通过识别训练数据中重复出现的数学表达式和解题过程,OLMoTrace揭示了模型此类能力的多大程度上依赖于机械记忆而非推理,从而推动模型能力提升方案的设计更为科学合理。值得关注的是,OLMoTrace还帮助工程师们辨析模型输出中的错误信息或不实内容。例如模型错误宣称知识截止日期时,通过追踪发现问题源自后期训练数据,由此让开发团队采取措施清理训练集,避免类似错误再现,体现了OLMoTrace在模型调优与质量控制中的独特价值。OLMoTrace不仅是一个文本追踪工具,更是推动AI透明度和责任化治理的重要桥梁。通过开放训练数据和工具接口,Ai2鼓励研究社区和公众参与,携手揭开语言模型“黑盒”的神秘面纱,促进人工智能技术在伦理和科学上的健康发展。

Ai2所构建的训练数据体系涵盖了多个阶段,包括预训练、监督微调、偏好学习及强化学习奖励等,涵盖了数十亿文档和数万亿词元,涵盖了多种数据类型。这些庞大的数据群经过细致整合,为OLMoTrace的高效匹配奠定基础,也为模型在通用性和精准性之间奠定平衡。技术层面,OLMoTrace的并行化设计和创新索引结构使其能够在极大输出文本中快速锁定关键跨度,减少计算资源消耗,确保用户体验流畅。此外,文档相关性的排序机制(基于BM25算法)进一步提升了检索结果的实用性,使用户优先查看最具价值的训练数据片段。未来,OLMoTrace有潜力在多领域发挥深远影响。它不仅为语言模型的研究和开发注入透明因素,也有望应用于法律合规、内容监管、信息溯源等实务场景,为AI系统打造更加可信赖的生态环境。

随着更多模型和数据的加入,OLMoTrace的示范效应将逐步扩大,为开放科学和公众信任树立新黄金标准。总之,OLMoTrace是人工智能透明化进程中的标杆技术,通过将语言模型输出和庞大训练数据集紧密结合,开辟了语言模型分析和应用的新纪元。它为解决“为什么模型会这么回答”的疑惑提供了真切答案,为AI研究注入了强大的科学验证力量。随着技术不断演进,OLMoTrace及其背后的开放理念必将引领语言模型未来发展的方向,助力构建更加智能、可信和负责任的AI世界。