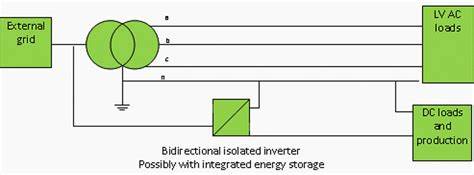

近年来,随着人工智能技术的飞速进步,尤其是在大型语言模型(Large Language Models, 简称LLM)领域的突破,如何有效评估这些模型的表现成为业内关注的焦点。作为最受关注的评测平台之一,Chatbot Arena凭借其独特的基于“氛围投票”的评测机制,迅速聚集了大量模型爱好者和开发者,其排行榜甚至被视作衡量模型优劣的重要参考标准。然而,近期这套体系遭遇了来自业内多方的质疑与批评,揭示出排行榜制度内在的公正性问题以及透明度的缺失。深入剖析这一争议不仅有助于更好地理解当前LLM领域的评测挑战,也为未来构建更科学公平的评价体系提供了重要启示。 Chatbot Arena之所以在行业内获得广泛认可,关键在于它采用了类似国际象棋Elo积分系统的竞赛排名机制。用户通过对两个随机匿名模型的输出进行比较,投票选出更优表现,逐步积累和调整模型分数,形成排行榜。

这种方式从参与式和趣味性角度极具吸引力,也为模型之间的直接对抗提供了数据支持。然而,随着投资金额和行业焦点的不断聚集,排行榜背后的方法论局限开始逐渐暴露。 2024年底,一篇由Cohere Labs联合多所知名学术机构撰写的论文《排行榜幻象》(The Leaderboard Illusion)引发关注。长达68页的深入报告系统性揭示了Chatbot Arena排行榜存在的多重问题。论文指出,部分大型模型供应商利用平台的“私密测试”机制,在公开排名前反复测试大量不同模型版本,选择表现最佳的版本提交,从而导致排行榜失去公正性。这种选择性公开分数的行为本质上是一种“榜单作弊”,使得同一供应商持续占据榜首位置,其他模型难以公平竞争。

更为严重的是,这种私密测试和分数撤回机制长期未被充分披露,导致外界难以得知各模型在平台上真实的被测试规模和成绩波动。Cohere等开源模型团队反映,其提交的模型在抽样测试频次及数据访问上明显不及大型商业供应商,进一步加剧了不平衡和不公平。论文强调,公开排名频率的不均衡、公开模型的悄然下架和私密多版本测试,综合形成了数据访问权和曝光率的巨大差异,极大影响了榜单的代表性和信服度。 此外,Chatbot Arena在评分机制上存在对某些回答格式的偏好,如偏好使用项目符号清单、限定回答长度等,这也导致部分模型因迎合“投票偏好”而排名上升,而非真正反映模型在多样化复杂任务中的综合表现。此类“迎合玩法”的现象削弱了榜单对模型实际能力的评估价值。 针对这些问题,Chatbot Arena官方回应称其已有政策防止供应商只公布排名最高的分数,且只发布公开发布版本的得分,试图维护排行榜的公正性。

然而,业内专家和观察者普遍认为这一回应未能正面解决“私密多版本测试及选择性公布”的核心漏洞。该漏洞不仅鼓励供应商“精心打磨”模型以迎合投票人喜好,更阻碍了外部对模型研发真实水平的全面了解。 透明度缺失是此次批评的根本原因。行业内部普遍呼吁,若某模型连续登顶榜单,应附带详细信息披露其测试过程、参与对比的版本数量及其得分区间。只有在充分透明的环境下,用户、开发者和投资者才能合理评估排行榜的权威性和模型的真实实力,避免被表面光鲜的排名误导。 在对Chatbot Arena争议的反思中,不少业内知名人士开始寻求替代或补充的评测方案。

OpenRouter平台被视为一大潜力方向。该平台允许用户及企业自由切换不同提供商的API,基于真实的使用场景和实际用户需求进行隐私保护的私有评测。通过真实使用行为的积累,OpenRouter排名能较好地反映模型的综合性价比和实际效能,减轻了传统排行榜游戏化的风险。但其挑战在于数据集中度过高时,单一大客户的偏好可能对排名产生过大影响。 对于整个LLM评测生态而言,Chatbot Arena的争议凸显了当前评测体系亟须改革的紧迫性。评测不仅要追求技术指标上的精准,而且要充分保障评测过程的公开、公平与可追溯性。

评估体系设计者应考虑多维度、多样化的评测数据来源,并建立严密的抽样、发布和更新机制,减少人为操纵空间。尤其在商业利益高度交织的环境中,建立监管与社区共同参与的多方监督机制尤为重要。 未来,伴随着模型技术的不断成熟与应用场景的日益丰富,评测体系也需向更贴近实际应用需求的方向演进。直接基于用户真实使用反馈,结合自动化、多样化的评测任务,将有助于构建更具公信力的模型排名。同时,行业内应加强模型版本控制与溯源管理,提升整体开源与商业模型的测试透明性,促进良性竞争。 总结来看,Chatbot Arena这次引发的讨论不仅是对一个排行榜的质疑,更反映了整个LLM领域关于技术评价公正性和透明度的深刻挑战。

只有通过不断完善评测框架和提升信息公开水平,行业才能建立更加可信赖的模型评价体系,推动大型语言模型的健康发展和合理应用。未来的评测生态必将更加多元和透明,也将赋能更多创新型模型逐步崭露头角,引领人工智能走向更广阔的前景。